In questo articolo imparerai tutto ciò che devi sapere sui modelli linguistici di grandi dimensioni (LLM) in modo pratico e semplice. Scoprirai cosa sono esattamente, come funzionano all’interno e quali sono le loro applicazioni più importanti nel 2025. Imparerai anche a conoscere i rischi da tenere in considerazione e come scegliere il modello più adatto alle tue esigenze.

Se ti sei mai chiesto come ChatGPT, Claude o Gemini possano comprendere e generare testo quasi come un essere umano, ecco le risposte. Ti mostreremo tutto, dalle basi alle tendenze più avanzate, sempre con esempi pratici che puoi applicare.

Punti chiave

Gli LLM rappresentano una rivoluzione tecnologica che sta trasformando il modo in cui interagiamo con le macchine ed elaboriamo le informazioni. Ecco i punti essenziali che dovresti sapere:

• Gli LLM sono modelli di intelligenza artificiale specializzati nel linguaggio che utilizzano architetture Transformer per elaborare trilioni di parametri e generare testo simile a quello umano.

• Il suo addestramento richiede ingenti risorse: GPT-3 ha consumato 1.287 MWh di elettricità e ha prodotto più di 500 tonnellate di CO2, equivalenti a 600 voli transatlantici.

• Le applicazioni pratiche includono la generazione di contenuti, la traduzione multilingue, la conversione di codice e gli assistenti virtuali che consentono di risparmiare il 30-90% del tempo nelle attività di routine.

• I rischi principali sono le allucinazioni (2,5-15% delle risposte false), i pregiudizi ereditati dai dati di addestramento e le vulnerabilità della privacy e della sicurezza.

• Il futuro punta verso modelli multimodali più efficienti, contesti fino a 2 milioni di token e una regolamentazione responsabile come la nuova legge europea sull’IA.

Comprendere queste capacità e limitazioni ti consentirà di sfruttare il potenziale degli LLM mentre navighi responsabilmente in questo panorama tecnologico in continua evoluzione.

Che cos’è un LLM o “Large Language Model”?

Immagina un sistema in grado di leggere milioni di libri, articoli e pagine Web in pochi giorni e quindi utilizzare tutte queste conoscenze per tenere conversazioni, scrivere testi o risolvere problemi complessi. Questo è esattamente ciò che fa un modello linguistico di grandi dimensioni.

Un LLM è un tipo di intelligenza artificiale specializzata nella comprensione e nella generazione del linguaggio umano. A differenza dei programmi tradizionali che seguono regole specifiche, questi modelli apprendono i modelli linguistici analizzando enormi quantità di testo. Il risultato è sorprendente: possono scrivere come le persone, tradurre lingue, codificare codice o rispondere a domande praticamente su qualsiasi argomento.

Perché sono così importanti ora? Perché hanno raggiunto un livello di sofisticazione che consente loro di svolgere compiti che in precedenza potevano essere svolti solo dagli esseri umani. ChatGPT, Claude, Gemelli… tutti questi nomi che senti costantemente sono esempi di LLM che stanno cambiando il modo in cui lavoriamo, studiamo e comunichiamo.

Che cos’è un LLM o “Large Language Model”?

Definizione tecnica di LLM

Un Large Language Model (LLM) è un sistema di intelligenza artificiale addestrato su enormi quantità di testo in grado di comprendere e generare il linguaggio umano in modo sorprendentemente naturale. Pensalo come un programma che ha “letto” milioni di libri, articoli e pagine Web e ora può tenere conversazioni, scrivere testi e rispondere alle domande in modo coerente.

La base tecnica di questi modelli sono i trasformatori, un’architettura di reti neurali che funziona come un sofisticato sistema di attenzione. Immaginate di leggere una frase: i trasformatori possono “guardare” tutte le parole contemporaneamente e capire come si relazionano tra loro, piuttosto che elaborarle una per una come facevano i sistemi precedenti.

Durante l’addestramento, questi sistemi imparano a prevedere quale parola viene dopo in un testo, sviluppando gradualmente una profonda comprensione della grammatica, del significato e del contesto. Si tratta di un processo di autoapprendimento in cui il modello scopre modelli linguistici senza che nessuno gli insegni regole specifiche.

Differenza tra LLM e altri modelli di intelligenza artificiale

Ti sei mai chiesto cosa rende speciali gli LLM rispetto ad altri tipi di intelligenza artificiale? La differenza principale sta nella loro specializzazione e focalizzazione.

Mentre l’intelligenza artificiale è un termine ampio che include qualsiasi sistema che imita le capacità umane, gli LLM si concentrano esclusivamente sul linguaggio. Altri modelli di intelligenza artificiale possono essere progettati per riconoscere le immagini, prevedere le tendenze del mercato o controllare i robot, ma gli LLM sono esperti solo nella comprensione e nella generazione di testo.

Le differenze principali includono:

- Specializzazione linguistica: gli LLM padroneggiano compiti come la traduzione, il riassunto o la scrittura, mentre altri modelli di intelligenza artificiale si concentrano su aree completamente diverse come la visione artificiale o l’analisi dei dati.

- Architettura specifica: utilizzano trasformatori ottimizzati per rilevare le relazioni tra le parole, cosa che altri tipi di intelligenza artificiale non richiedono necessariamente.

- Capacità generative: Molti LLM possono creare contenuti originali, anche se l’IA generativa comprende più del testo, comprese immagini, musica e codice.

Perché si chiamano modelli linguistici “grandi”?

Il termine “big” non è una montatura pubblicitaria. Si riferisce a tre aspetti che sono davvero impressionanti per la loro grandezza:

Dimensione dei parametri: gli LLM contengono trilioni di parametri, che sono come gli “aggiustamenti interni” che ne determinano il funzionamento. Per darvi un’idea della scala, GPT-3 ha 175.000 milioni di parametri, mentre Jurassic-1 ne ha 178.000 milioni. È come se avessero milioni di piccole decisioni programmate dentro di loro.

Volume di dati di addestramento: questi modelli hanno elaborato enormi quantità di testo da Internet. Stiamo parlando di Common Crawl con più di 50.000 milioni di pagine web e di Wikipedia con tanto di 57 milioni di articoli. Si tratta di più informazioni di quante chiunque possa leggere in diverse vite.

Capacità computazionale: l’addestramento di un LLM richiede che i supercomputer lavorino per settimane o mesi. Ognuno di questi trilioni di parametri deve essere messo a punto, il che richiede una potenza di calcolo straordinaria.

I modelli più importanti che puoi attualmente utilizzare includono:

- GPT di OpenAI , noto per la sua capacità di ragionamento e risposte coerenti

- Claude che può analizzare documenti molto lunghi con un massimo di 100.000 token

- Meta Flame , ottimizzato per applicazioni pratiche e reali

- Gemini di Google DeepMind , già integrato in Gmail e in altri servizi che probabilmente utilizzi quotidianamente

Ognuno di loro ha dei punti di forza particolari, ma tutti condividono quella “grande” caratteristica che li rende così potenti nel lavorare con il linguaggio umano.

Architettura dei modelli LLM: come sono costruiti

Ti sei mai chiesto cosa c’è dietro la capacità di ChatGPT di mantenere una conversazione coerente? In questa sezione scoprirai come questi sistemi sono costruiti dall’interno. Ti mostreremo in modo semplice i componenti principali che consentono agli LLM di comprendere e generare testo come se fossero umani.

Ricorda che sebbene l’architettura possa sembrare complessa all’inizio, comprenderla ti aiuterà a scegliere meglio quale modello utilizzare in base alle tue esigenze.

Reti neurali profonde e livelli di attenzione

Gli LLM funzionano attraverso reti neurali multistrato che imitano, in qualche modo, il funzionamento del cervello umano. Pensa a queste reti come a una serie di filtri interconnessi, in cui ogni livello elabora e perfeziona le informazioni ricevute dal livello precedente.

La principale differenza con i modelli tradizionali è il numero di strati. Mentre i vecchi sistemi utilizzavano uno o due strati, gli LLM di oggi impiegano centinaia o addirittura migliaia di livelli per elaborare le informazioni. Ogni nodo in questi livelli ha un peso e una soglia specifici che determinano se deve essere attivato e passare le informazioni al livello successivo.

All’interno di questa architettura, troverai tre tipi principali di livelli:

- Incorporamento di livelli: converti le parole in numeri che il modello può comprendere

- Livelli di attenzione: aiuta il modello a identificare quali parti del testo sono più importanti

- Forward Feed Layers: elabora tutte queste informazioni per generare la risposta finale

Trasformatori e cura di sé

È qui che avviene la magia. I Transformers, introdotti nel 2017, hanno cambiato completamente le carte in tavola. Questa architettura consente al modello di elaborare contemporaneamente tutte le parole di una frase, anziché parola per parola.

Il meccanismo di auto-cura è al centro di questa tecnologia. Funziona valutando la relazione tra ogni parola e tutte le altre parole nel testo. Ad esempio, nella frase “Il cane nel parco abbaia rumorosamente”, il sistema capisce che “abbaia” si riferisce a “cane”, non a “parco”.

Questa capacità di comprendere le relazioni a distanza era molto difficile per i modelli precedenti. Inoltre, elaborando tutto in parallelo, la formazione è molto più veloce ed efficiente.

I trasformatori utilizzano due componenti principali: un codificatore che comprende il testo di input e un decodificatore che genera la risposta. Tuttavia, alcuni modelli come GPT utilizzano solo la parte del decoder.

Tokenizzazione e incorporamento

Prima di elaborare qualsiasi testo, gli LLM devono convertirlo in numeri utilizzando la tokenizzazione. Questo processo divide il testo in piccole unità chiamate token.

Il metodo più comunemente utilizzato è la codifica delle coppie di byte (BPE), che identifica le combinazioni di lettere più frequenti e le converte in token. Ciò consente al modello di gestire in modo intelligente nuove parole, nomi propri e persino errori di battitura.

Una volta tokenizzata, ogni parola viene convertita in un vettore numerico chiamato embedding. Questi vettori catturano il significato delle parole in modo tale che parole simili abbiano numeri simili.

Infine, poiché i Transformers elaborano tutto contemporaneamente, devono conoscere l’ordine delle parole. Per fare ciò, utilizzano codifiche posizionali che vengono aggiunte a ciascun incorporamento. Così il modello capisce che “Maria ama Giovanni” è diverso da “Giovanni ama Maria”.

Se hai domande su questi concetti tecnici, ti consigliamo di iniziare con gli aspetti più pratici e poi approfondire i dettagli in base alle tue esigenze specifiche.

Addestrare un modello LLM: quanto costa davvero?

La creazione di un modello linguistico di grandi dimensioni non è simile all’installazione di un programma nel computer. È un processo che consuma enormi risorse e determina se il modello sarà utile o meno. Ecco tutto quello che c’è da sapere su questo processo.

Come imparano gli LLM? Due metodi principali

Esistono due modi principali per addestrare questi modelli, ognuno con i propri vantaggi:

Pre-training autoregressivo: modelli come GPT funzionano come un sistema di completamento delle frasi. Imparano a prevedere quale sarà la parola successiva in base a tutte le parole precedenti. È come quando digiti sul tuo cellulare e ti suggerisce la parola successiva.

Pre-training mascherato: modelli come BERT utilizzano un metodo diverso. Le parole casuali sono nascoste in un testo e il modello deve indovinare quali mancano. È come fare un esercizio di riempimento degli spazi vuoti.

La differenza fondamentale è che i modelli autoregressivi guardano solo indietro per prevedere, mentre i modelli mascherati possono guardare sia indietro che in avanti, ottenendo una comprensione più completa del contesto.

I costi reali: cifre che ti sorprenderanno

La formazione di un LLM è straordinariamente costosa. Per darvi un’idea chiara:

Enorme consumo di energia: GPT-3 ha avuto bisogno di 1.287 MWh di elettricità per il suo addestramento. Ciò equivale al consumo annuo di oltre 100 famiglie.

Significativa impronta di carbonio: il processo ha generato più di 500 tonnellate di CO2, paragonabili a 600 voli tra New York e Londra o a ciò che 38 famiglie spagnole producono in un anno intero.

Elevato investimento economico:

- Un modello con 1.500 milioni di parametri è costato 0,95 milioni di euro nel 2020

- Il GPT-3 (175 miliardi di parametri) è costato circa 3,82 miliardi di euro

- GPT-4 ha superato i 95,42 milioni di euro a causa della sua maggiore complessità

Ricorda che questi costi si dividono in due fasi: l’allenamento iniziale consuma il 20-40% dell’energia totale ma avviene una sola volta. La fase di utilizzo continuo può rappresentare il 50-60% del dispendio energetico a lungo termine.

Sapevi che la generazione di immagini consuma 2,907 kWh per 1.000 operazioni, mentre la generazione di testo richiede solo 0,047 kWh? La generazione di testo è molto più efficiente.

Come imparano senza la supervisione umana?

L’apprendimento auto-supervisionato è la chiave per il successo degli LLM. A differenza dei metodi tradizionali che richiedono l’etichettatura manuale dei dati, questi modelli generano le proprie etichette da testo non elaborato.

Il processo funziona in questo modo: il modello impara a prevedere le parti mancanti del testo o la parola successiva in una sequenza. Ciò ti consente di allenarti con enormi quantità di testo da Internet senza la necessità di taggare manualmente.

Il processo si divide in due fasi:

Passaggio 1: attività di pretexting: il modello apprende le rappresentazioni del linguaggio attraverso attività come la previsione di parole nascoste o il completamento di sequenze.

Passaggio 2: Compiti specifici – Le rappresentazioni apprese vengono applicate a compiti specifici come la traduzione o la classificazione del testo.

Esistono due tecniche principali:

- Apprendimento autopredittivo: il modello prevede parti di dati in base ad altre parti

- Apprendimento contrastivo: il modello impara a distinguere le relazioni tra diversi campioni di dati

Questa metodologia consente di sfruttare in modo efficiente le enormi risorse computazionali necessarie per creare LLM sempre più potenti.

Applicazioni pratiche degli LLM nel 2025

Gli LLM non sono più solo esperimenti di laboratorio. Entro il 2025, questi strumenti risolveranno problemi reali nelle aziende di tutti i settori. Ecco le app più utili che puoi distribuire oggi.

Generazione automatica di testi e riassunti

Hai bisogno di elaborare rapidamente grandi volumi di informazioni? Gli LLM eccellono nella loro capacità di creare contenuti originali e riassumere documenti lunghi mantenendo i punti chiave.

La creazione di riepiloghi automatici consente di risparmiare tempo e risorse significativi durante l’elaborazione delle informazioni. Questa funzionalità è particolarmente utile per:

- Articoli di ricerca e documentazione tecnica

- Documenti legali e finanziari

- Feedback dei clienti e analisi delle tendenze

- Rapporti aziendali e ricerche di mercato

Ci sono due metodi principali che puoi usare. Il riassunto estrattivo identifica ed estrae le frasi più rilevanti dal testo originale, mentre il riassunto astratto genera nuove frasi che catturano l’essenza del contenuto. A seconda delle tue esigenze, puoi ottenere qualsiasi cosa, da brevi riassunti ad analisi dettagliate.

Strumenti più avanzati forniscono anche punteggi di ranking per valutare la pertinenza delle frasi estratte e delle informazioni posizionali per individuare gli elementi più importanti.

Traduzione multilingue e conversione del codice

Se lavori con più linguaggi o hai bisogno di modernizzare il vecchio codice, gli LLM offrono soluzioni precise che superano i metodi tradizionali.

Per la traduzione, questi modelli catturano le sfumature culturali e preservano il tono del testo originale. Il modello DeepL supera ChatGPT-4, Google e Microsoft in termini di qualità, richiedendo una revisione significativamente inferiore: mentre Google ha bisogno del doppio delle correzioni e ChatGPT-4 del triplo per raggiungere la stessa qualità.

In termini di conversione del codice, gli LLM si sono dimostrati straordinariamente efficaci nella migrazione dei sistemi legacy. Lo strumento CodeScribe, ad esempio, combina l’ingegneria rapida con la supervisione umana per convertire in modo efficiente il codice Fortran in C++.

I risultati sono impressionanti: mentre prima dell’utilizzo di LLM si potevano convertire 2-3 file al giorno, con questi strumenti la produttività aumenta a 10-12 file al giorno.

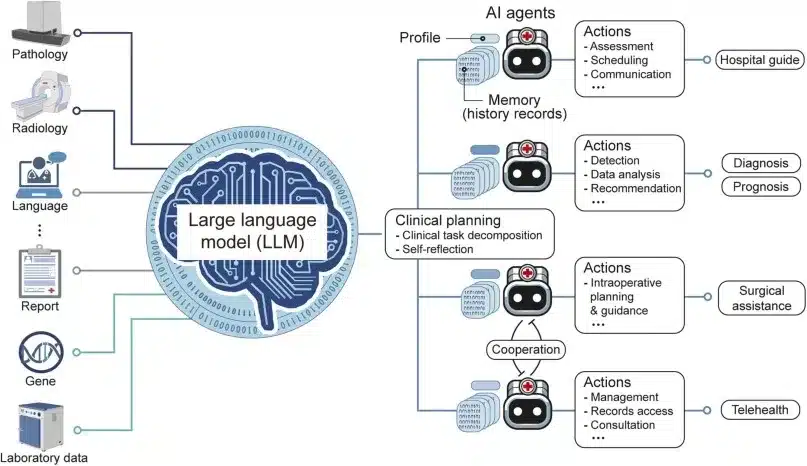

Assistenti virtuali e chatbot aziendali

Vuoi automatizzare il servizio clienti o migliorare i processi interni? Gli assistenti basati su LLM mantengono conversazioni fluide, comprendono domande complesse e si adattano allo stile di ogni utente.

Ricorda che c’è una differenza importante: gli assistenti AI sono reattivi e svolgono compiti su richiesta, mentre gli agenti AI sono proattivi e lavorano in modo autonomo per raggiungere obiettivi specifici.

Uno studio condotto su 167 aziende ha identificato il servizio clienti come il caso d’uso più popolare per l’adozione degli agenti LLM. Nelle operazioni interne, questi agenti possono risparmiare dal 30% al 90% del tempo dedicato alle attività di routine.

Il supporto automatizzato ti consente di rispondere alle domande 24 ore al giorno, fornire informazioni coerenti e personalizzare l’esperienza in base alla cronologia del cliente. Nelle vendite, puoi usarli per qualificare i potenziali clienti e raccogliere informazioni preziose senza l’intervento umano.

Se non sei sicuro di quale app sia più adatta alla tua attività, ti consigliamo di iniziare con un test pilota nell’area che attualmente richiede più tempo.

Come si valuta effettivamente un modello LLM?

Se ti sei mai chiesto come i ricercatori determinano se un LLM è buono o cattivo, ecco la risposta. Valutare questi modelli non è così semplice come sembra e conoscere questi metodi ti aiuterà a capire meglio cosa significano davvero quei punteggi che vedi nei confronti.

La metrica della perplessità: quanto è “confuso” il modello?

La perplessità è uno dei modi più basilari per misurare il funzionamento di un LLM. Pensalo come un misuratore di “confusione” del modello: più basso è il punteggio, meno confuso è il modello nel prevedere la parola successiva.

Te lo spieghiamo con un semplice esempio. Se dai a una modella la frase “Il gatto sta dormendo nel…” E puoi facilmente prevedere che la prossima parola è “divano”, avrai una bassa perplessità. Se non avete idea di cosa accadrà dopo, la perplessità sarà alta.

Il processo funziona calcolando la probabilità inversa del testo del test, normalizzata per parola. Quando un modello è molto sicuro delle sue previsioni, si ottengono numeri bassi che indicano prestazioni migliori.

Ricorda che la perplessità, per quanto utile, non ti dice tutto sulla qualità del modello. Un modello può essere ottimo nel prevedere le parole, ma terribile nel creare testi coerenti o creativi.

Benchmark: i “test di guida” degli LLM

Per poter confrontare i modelli in modo equo, la comunità scientifica ha sviluppato una serie di test standardizzati. Sono come gli esami di guida, ma per l’intelligenza artificiale:

MMLU (Massive Multitask Language Understanding): questo è il test più completo, con circa 16.000 domande a scelta multipla che coprono 57 materie diverse, dalla matematica alla storia. È come se il modello fosse stato esaminato durante tutta la carriera universitaria.

ARC (AI2 Reasoning Challenge): contiene più di 7.700 domande di scienze a livello scolastico, suddivise in facili e difficili. Perfetto per misurare se il modello può ragionare come uno studente.

TruthfulQA: questo test è speciale perché misura se la modella sta dicendo la verità o inventando risposte quando non sa qualcosa. Molto utile per rilevare quelle “allucinazioni” di cui parleremo più avanti.

Esistono anche test specializzati come HumanEval per la programmazione, GSM8K per la matematica e Chatbot Arena in cui gli utenti reali votano le risposte che preferiscono.

Una tendenza interessante è la valutazione “LLM-as-a-judge”, in cui un modello avanzato come GPT-4 funge da giudice per valutare altri modelli. L’MT-Bench utilizza questa metodologia per testare le conversazioni a più turni.

I problemi con le valutazioni attuali

Sebbene questi test siano utili, presentano limitazioni importanti di cui è necessario essere consapevoli. Un recente studio di Apple ha dimostrato che le prestazioni degli LLM “si deteriorano quando aumenta la complessità delle domande”. I ricercatori hanno notato che piccoli cambiamenti nelle domande possono alterare completamente i risultati, indicando che questi modelli sono “molto flessibili ma anche molto fragili”.

Un altro problema serio è la “contaminazione dei dati”. Poiché i modelli vengono addestrati con testi provenienti da Internet, c’è il rischio che abbiano “memorizzato” le risposte dei test, invalidando i risultati. È come se uno studente avesse visto l’esame prima di farlo.

Inoltre, i benchmark vengono rapidamente “saturati”. Quando i modelli più avanzati ottengono un punteggio del 99%, non sono più utili per misurare i progressi. Ecco perché hanno sviluppato test più difficili come MMLU-Pro, che include domande più complicate e più opzioni di risposta.

Il limite più grande è che queste valutazioni non misurano aspetti cruciali come l’empatia, la creatività o la comprensione pragmatica del linguaggio, che sono fondamentali per le applicazioni nel mondo reale.

Se stai valutando gli LLM per la tua azienda o il tuo progetto, ti consigliamo di non fare affidamento esclusivamente su questi punteggi. I test pratici con casi d’uso reali sono spesso più rivelatori dei benchmark accademici.

Rischi e limiti degli attuali LLM

Avete già visto le impressionanti capacità degli LLM, ma dovete anche conoscere i loro importanti limiti. Questi modelli, sebbene potenti, presentano sfide significative che è necessario considerare prima di distribuirli in applicazioni sensibili.

Allucinazioni e generazione di false informazioni

Sai cosa sono le allucinazioni nei modelli linguistici? È un fenomeno in cui questi sistemi generano risposte che sembrano convincenti ma contengono informazioni completamente false o inventate. Ciò accade perché gli LLM operano attraverso la previsione probabilistica delle parole, dando priorità al fatto che il testo suoni coerente rispetto alla veridicità dei fatti.

Un esempio che ti aiuterà a capire la gravità del problema: un avvocato ha utilizzato ChatGPT per redigere una memoria legale con riferimenti generati dall’intelligenza artificiale, solo per scoprire in seguito che i casi legali citati non esistevano affatto, con conseguenti sanzioni da parte del giudice.

I dati sono rivelatori. Anche i modelli più avanzati hanno allucinazioni tra il 2,5% e l’8,5% delle volte in compiti generali, una cifra che può superare il 15% in alcuni modelli. In domini specializzati come il diritto, il tasso di allucinazioni può raggiungere tra il 69% e l’88% delle risposte.

Distorsioni nei dati di addestramento

Gli LLM ereditano e amplificano i pregiudizi presenti nei loro dati di addestramento. Puoi pensare a questo come a uno studente che impara da libri che contengono pregiudizi storici: inevitabilmente incorporeranno quelle prospettive distorte.

Ecco un esempio concreto: quando si chiede a ChatGPT possibili nomi dirigenziali, il 60% dei nomi generati sono maschili, mentre quando si richiedono nomi di insegnanti, la maggior parte sono femminili. Questo rivela come i modelli perpetuano gli stereotipi di genere presenti nei loro dati di addestramento.

Inoltre, uno studio recente ha rilevato che le risposte dei principali modelli LLM tendono ad allinearsi con profili demografici specifici: principalmente uomini, adulti, altamente istruiti e con un interesse per la politica.

Problemi di privacy e sicurezza

Quando interagisci con gli LLM, dovresti considerare i rischi relativi alla privacy e alla sicurezza delle tue informazioni. Quando si inseriscono dati in questi sistemi, c’è il pericolo che queste informazioni possano essere memorizzate, utilizzate per la formazione futura o, nel peggiore dei casi, esposte a terzi a causa di vulnerabilità di sicurezza.

Le minacce più critiche identificate da OWASP includono:

- Iniezione rapida

- Gestione non sicura delle partenze

- Avvelenamento dei dati di addestramento

- Modello di negazione del servizio

Queste vulnerabilità potrebbero consentire agli aggressori di manipolare il comportamento dell’LLM per estrarre informazioni sensibili o eseguire codice dannoso.

Un caso reale che illustra questi rischi: i dipendenti Samsung hanno condiviso informazioni riservate con ChatGPT mentre lo utilizzavano per attività lavorative, esponendo codice e registrazioni di riunioni che potrebbero potenzialmente essere rese pubbliche.

Ricorda che conoscere questi rischi non significa che dovresti evitare gli LLM, ma che dovresti usarli in modo informato e responsabile.

I modelli LLM più importanti nel 2025: quale scegliere?

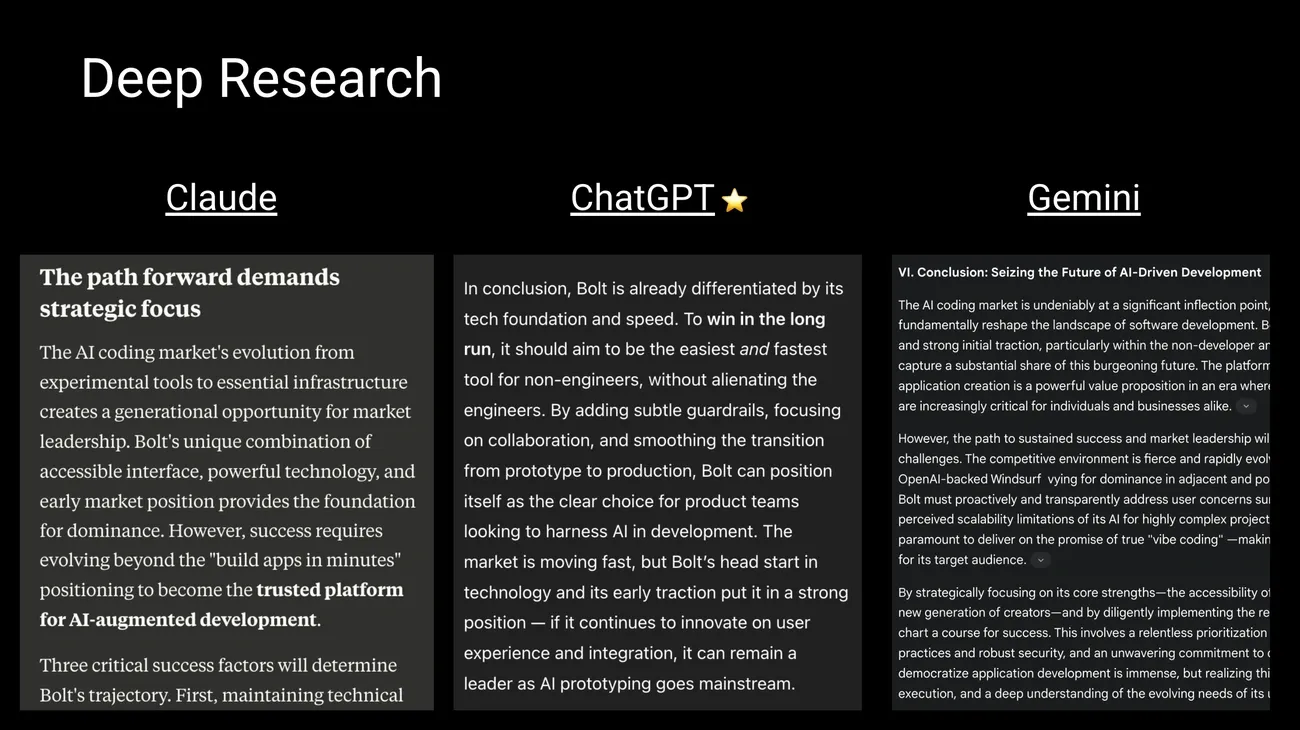

Fonte immagine: Behind the Craft di Peter Yang

Ti stai chiedendo quale sia il miglior modello LLM per i tuoi progetti? Il panorama è in continua evoluzione, con nuovi modelli che migliorano le capacità dei loro predecessori. Di seguito, ti mostriamo le opzioni più importanti in modo che tu possa scegliere quella più adatta in base alle tue esigenze.

GPT-4, Claude 3 e Gemini 1.5: i leader di mercato

I modelli di business attualmente dominano il mercato grazie alle loro capacità avanzate.

Claude 3 Opus di Anthropic eccelle in compiti complessi di ragionamento e risoluzione dei problemi, superando GPT-4 in benchmark come il ragionamento esperto di livello universitario (GPQA) e la matematica di base (GSM8K). Consigliamo Claude se lavori con analisi approfondite o devi risolvere problemi che richiedono una logica avanzata.

Gemini 1.5 Pro di Google offre straordinarie capacità di analisi multimodale e può elaborare fino a 1 milione di token, consentendo di analizzare lunghi documenti o addirittura ore di video. È l’ideale se è necessario elaborare grandi volumi di informazioni in una sola volta.

Alternative open source: LLaMA 3, Mistral e DeepSeek

Preferisci il pieno controllo sui tuoi dati? I modelli open source stanno avanzando rapidamente. LLaMA di Meta ti consente di installare localmente versioni con parametri di diverse dimensioni, mantenendo tutte le tue informazioni sul tuo server.

Mistral si distingue per la sua efficienza e offre versioni ottimizzate per funzionare sia su CPU che su GPU. Se hai risorse limitate ma hai bisogno di buone prestazioni, Mistral potrebbe essere la tua migliore opzione.

DeepSeek ha guadagnato popolarità per le sue eccezionali prestazioni nel ragionamento e nella codifica, competendo direttamente con i modelli commerciali. Il vantaggio principale di queste alternative gratuite è che tutte le informazioni rimangono sul tuo dispositivo, garantendo la completa privacy dei tuoi dati.

Come confrontare i parametri e la capacità dei token?

Le funzionalità variano in modo significativo a seconda dell’architettura di ciascun modello. GPT-4o offre un contesto di 128.000 token, mentre Gemini 1.5 Pro alza questo limite a 1 milione (con l’intenzione di espanderlo a 2 milioni). Claude 3 Opus gestisce fino a 200.000 token, consentendo di analizzare documenti di grandi dimensioni.

Ricorda che anche le dimensioni contano: sebbene le cifre esatte siano riservate, si stima che GPT-4 contenga circa 1,8 trilioni di parametri, mentre Gemini 1.5 Pro è di circa 1,5 trilioni e Claude Opus circa 200.000 milioni di parametri.

La scelta del modello giusto dipenderà dalle tue esigenze specifiche: budget, volume di dati da elaborare, livello di privacy richiesto e tipo di attività che svolgerai.

Dove stanno andando gli LLM? Le tendenze che daranno forma al futuro

Vi siete mai chiesti come saranno gli LLM nei prossimi anni? L’evoluzione di questi modelli sta avanzando a un ritmo rapido e conoscere le tendenze ti aiuterà a prepararti per i cambiamenti in arrivo.

Modelli che capiscono tutto: multimodalità e contesti estesi

La tendenza più importante che vedrai è l’integrazione multimodale. Nuovi modelli come Gemini 1.5 e GPT-4o elaborano contemporaneamente testo, immagini, audio e video, consentendo interazioni più naturali e complete con l’utente. Ciò significa che sarai in grado di caricare una foto, porre una domanda vocale e ricevere una risposta scritta, tutto nella stessa conversazione.

Inoltre, la capacità di gestire contesti di grandi dimensioni ha fatto un salto straordinario. Mentre in precedenza le modelle “dimenticavano” le informazioni dopo poche pagine, ora possono elaborare fino a 1 milione di token su Gemini, con l’intenzione di raggiungere presto i 2 milioni. Ciò ti consente di analizzare interi documenti, interi libri o persino ore di video senza perdere il filo della conversazione.

Modelli più efficienti: meno risorse, migliori prestazioni

Una tendenza che ti avvantaggerà direttamente è la quantizzazione. Questa tecnica riduce l’accuratezza numerica dei pesi del modello, passando da rappresentazioni a 32 bit a formati più compatti come INT8 o INT4. Cosa significa questo per te? Modelli fino a 8 volte più piccoli, minor consumo energetico e maggiore velocità di risposta.

Modelli come DeepSeek-V3 dimostrano che è possibile ottenere prestazioni eccezionali a costi significativamente inferiori. Se prevedi di utilizzare LLM nella tua azienda, questa tendenza ti consentirà di accedere a funzionalità avanzate senza la necessità di grandi investimenti in hardware.

Regolamentazione: le nuove regole del gioco

Ricorda che l’Unione europea ha emanato la prima legge completa sull’IA, con un’attuazione graduale fino al 2026. Questo quadro classifica i sistemi in base al loro livello di rischio e impone obblighi proporzionati, vietando le pratiche ritenute inaccettabili. Anche la Cina, il Canada e altri paesi stanno sviluppando i propri schemi normativi.

Che impatto avrà questo sul tuo uso quotidiano? Maggiore trasparenza nel funzionamento dei modelli, migliore protezione dei dati personali e standard di qualità e sicurezza più elevati.

L’equilibrio tra innovazione e controllo responsabile determinerà la velocità con cui è possibile accedere a queste nuove funzionalità e a quali condizioni.

Conclusione

Cosa abbiamo imparato sugli LLM durante questo viaggio? In primo luogo, che questi modelli rappresentano una tecnologia straordinaria che sta già cambiando il nostro modo di lavorare e comunicare.

Ricorda che gli LLM funzionano elaborando enormi quantità di testo per apprendere modelli in linguaggio umano. La loro architettura basata su trasformatori consente loro di comprendere il contesto e generare risposte coerenti, anche se non sempre accurate.

Per quanto riguarda le applicazioni pratiche, puoi utilizzarle per generare contenuti, riassumere documenti, tradurre testi o creare assistenti virtuali per la tua attività. La produttività che offrono è notevole: possono risparmiare tra il 30% e il 90% del tempo nelle attività di routine.

Tuttavia, sii consapevole dei suoi importanti limiti. Le allucinazioni si verificano dal 2,5% al 15% delle volte, i pregiudizi sono presenti nelle loro risposte e dovresti essere cauto riguardo alle informazioni sensibili che condividi.

Se hai intenzione di utilizzare questi modelli regolarmente, ti consigliamo di:

• Valuta le tue esigenze specifiche prima di scegliere tra opzioni commerciali come GPT-4o, Claude 3 o Gemini 1.5 • Considera alternative open source come LLaMA o Mistral se hai bisogno di un maggiore controllo sui tuoi dati • Verifica sempre le informazioni importanti generate da questi sistemi

Il futuro punta verso modelli multimodali più efficienti e con contesti più lunghi. Anche la regolamentazione sta arrivando, soprattutto in Europa.

In qualità di utente di queste tecnologie, la comprensione di questi concetti ti consentirà di sfruttarne meglio il potenziale, evitando i rischi principali. La chiave è usarli come strumenti potenti, ma sempre con la supervisione e il giudizio umano.

Punti chiave

Gli LLM rappresentano una rivoluzione tecnologica che sta trasformando il modo in cui interagiamo con le macchine ed elaboriamo le informazioni. Ecco i punti essenziali che dovresti sapere:

• Gli LLM sono modelli di intelligenza artificiale specializzati nel linguaggio che utilizzano architetture Transformer per elaborare trilioni di parametri e generare testo simile a quello umano.

• Il suo addestramento richiede ingenti risorse: GPT-3 ha consumato 1.287 MWh di elettricità e ha prodotto più di 500 tonnellate di CO2, equivalenti a 600 voli transatlantici.

• Le applicazioni pratiche includono la generazione di contenuti, la traduzione multilingue, la conversione di codice e gli assistenti virtuali che consentono di risparmiare il 30-90% del tempo nelle attività di routine.

• I rischi principali sono le allucinazioni (2,5-15% delle risposte false), i pregiudizi ereditati dai dati di addestramento e le vulnerabilità della privacy e della sicurezza.

• Il futuro punta verso modelli multimodali più efficienti, contesti fino a 2 milioni di token e una regolamentazione responsabile come la nuova legge europea sull’IA.

Comprendere queste capacità e limitazioni ti consentirà di sfruttare il potenziale degli LLM mentre navighi responsabilmente in questo panorama tecnologico in continua evoluzione.

Ricorda che puoi utilizzare tutta la potenza dei modelli llm nei tuoi agenti di intelligenza artificiale con n8n e utilizzare i loro modelli di elaborazione nei tuoi flussi di lavoro.

FAQs

Domanda 1. Che cos’è esattamente un LLM e come funziona? Un LLM (Large Language Model) è un modello di intelligenza artificiale progettato per comprendere e generare il linguaggio umano. Funziona analizzando enormi set di dati testuali e utilizzando reti neurali profonde per apprendere modelli linguistici e generare testo coerente.

Domanda 2. Quali sono le applicazioni pratiche più comuni degli LLM nel 2025? Le applicazioni più comuni includono la generazione automatica di contenuti, la traduzione multilingue, la conversione di codice tra linguaggi di programmazione e assistenti virtuali avanzati per il servizio clienti e la produttività aziendale.

Domanda 3. Quali sono i principali rischi associati all’uso di LLM? I rischi più significativi sono le allucinazioni (generazione di informazioni false), la perpetuazione di pregiudizi presenti nei dati di addestramento e i problemi di privacy e sicurezza legati alla gestione dei dati sensibili.

Domanda 4. Come viene valutata la performance di un LLM? Le prestazioni vengono valutate utilizzando metriche come la perplessità, che misura la capacità predittiva del modello, e benchmark standardizzati che valutano diverse capacità come la comprensione, il ragionamento e la generazione di testo. Le valutazioni contraddittorie vengono utilizzate anche per testare la robustezza del modello.

Domanda 5. Quali sono le tendenze future nello sviluppo degli LLM? Le tendenze includono lo sviluppo di modelli multimodali che integrano testo, immagini e audio, la capacità di gestire contesti più lunghi (fino a milioni di token), tecniche di ridimensionamento per migliorare l’efficienza e un’attenzione alla governance e alla regolamentazione responsabili di queste tecnologie.