I modelli LLM 2025 offrono una varietà di opzioni per bilanciare velocità, costi e capacità in base alle esigenze specifiche. In questo articolo metteremo a confronto i principali modelli, i loro punti forti e deboli e come ottenere il massimo da essi:

– GPT-4o è leader nella velocità multimodale con 110 token/secondo e capacità audio in tempo reale, ideale per conversazioni interattive ed elaborazione multimediale.

• DeepSeek R1 è l’opzione più economica con costi inferiori del 90-95% rispetto ai concorrenti, perfetta per attività di ragionamento matematico e sviluppo software.

• Gemini 2.5 Pro si distingue per la sua enorme finestra di contesto di 1M+ token, che consente di elaborare fino a 1.500 pagine contemporaneamente per un’analisi approfondita dei documenti.

– Claude 4 Opus stabilisce lo standard nella codifica professionale con il 72,5% di SWE-bench e una capacità di lavoro continua per 7 ore senza degradazione.

• La scelta del modello dovrebbe essere basata su casi d’uso specifici: velocità per il tempo reale (GPT-4o), economia per volumi elevati (DeepSeek R1) o prestazioni massime per lo sviluppo complesso (Claude 4 Opus).

La concorrenza tra questi modelli porterà a miglioramenti costanti nel 2025, offrendo versioni gratuite da sperimentare prima delle implementazioni aziendali su larga scala.

GPT-4o

Fonte immagine: Cody AI

Cosa rende speciale il GPT-4o tra tutti i modelli disponibili? Questo modello OpenAI, dove la “o” sta per “omni”, rappresenta un importante salto di qualità nell’intelligenza artificiale. A differenza delle versioni precedenti che elaboravano solo testo, GPT-4o può lavorare con testo, audio, immagini e video contemporaneamente e in tempo reale. Questa capacità multimodale lo rende uno strumento davvero versatile per qualsiasi applicazione tu possa immaginare.

Che velocità offre GPT-4o?

La velocità di GPT-4o è davvero impressionante. Quando parli con loro tramite audio, riceverai risposte in soli 232 millisecondi, con una media di 320 millisecondi, più o meno lo stesso tempo di risposta umano in una conversazione naturale.

Per capire il miglioramento che questo rappresenta, guarda questi dati comparativi:

- GPT-3.5 ha impiegato 2,8 secondi per rispondere

- GPT-4 ha avuto bisogno di 5,4 secondi per generare le risposte

In termini di elaborazione testi, GPT-4o raggiunge i 110 token al secondo, una velocità circa tre volte superiore a quella di GPT-4 Turbo. Questa velocità supera anche altri modelli concorrenti come il Claude 3 Opus e il Gemini 1.5 Pro.

Come fa a raggiungere questa velocità? La chiave è nella sua architettura integrata. Mentre i modelli precedenti richiedevano fino a tre sistemi separati per elaborare l’audio (trascrizione, generazione e sintesi), GPT-4o unifica tutto in un’unica rete neurale.

Quanto costa utilizzare GPT-4o?

OpenAI è riuscito a rendere GPT-4o molto più economico, con una riduzione dei costi del 50% rispetto a GPT-4 Turbo. Ecco l’attuale struttura dei prezzi:

| Tipo di token | Prezzo |

| Token di ingresso | 0,01 USD per 1.000 token |

| Token di output | 0,03 USD per 1.000 token |

Per darti un’idea pratica: l’elaborazione di un testo di 500 parole ti costerebbe circa 7,64 € (inclusi 625 token di input e 725 token di output).

Se stai cercando un’opzione ancora più economica, puoi utilizzare GPT-4o mini. Questa versione costa 0,15 dollari per milione di token di input e 0,60 dollari per milione di token di output, il che la rende circa 7,2 volte più economica di GPT-4.

Quante informazioni può elaborare GPT-4o?

GPT-4o gestisce una finestra di contesto di 128.000 token, un notevole miglioramento rispetto agli 8.192 token del GPT-4 originale. Cosa significa questo per te in pratica?

Con questa capacità ampliata, GPT-4o può:

- Analisi di interi documenti lunghi

- Avere lunghe conversazioni ricordando tutto il contesto precedente

- Elabora e rispondi in base a grandi volumi di informazioni

- Genera fino a 16.384 token in un’unica risposta

Ricorda che sebbene questa finestra di contesto sia ampia, modelli come Claude 3.5 Sonnet offrono 200.000 token e Gemini 1.5 Pro raggiunge i 2 milioni.

Quando consigliamo di utilizzare GPT-4o?

GPT-4o eccelle soprattutto quando è necessaria un’elaborazione multimodale e risposte rapide. Ti consigliamo di prenderlo in considerazione per:

Conversazioni in tempo reale: la sua bassa latenza lo rende la scelta ideale per chatbot e assistenti virtuali che richiedono interazioni fluide e naturali.

Elaborazione di lingue diverse: mostra miglioramenti significativi quando si lavora con lingue diverse dall’inglese. Ad esempio, utilizza 4,4 volte meno token per il gujarati, 3,5 volte meno per il telugu e 3,3 volte meno per il tamil.

Analisi delle immagini: la sua maggiore capacità di comprendere i contenuti visivi lo rende perfetto per descrivere documenti, diagrammi o schermate.

Lavorare con l’audio: può elaborare direttamente l’input audio, rilevando non solo il contenuto verbale ma anche il tono, identificando più altoparlanti e filtrando il rumore di fondo.

Creazione di contenuti multimediali: genera testo e immagini in modo integrato e contestuale.

Tuttavia, tieni presente che sebbene GPT-4o sia più veloce di GPT-4 Turbo, non mostra un aumento significativo delle capacità di ragionamento complessive. Se hai bisogno di un ragionamento complesso, altri modelli potrebbero essere più adatti al tuo progetto.

Sonetto di Claude 4

Fonte immagine: CometAPI

Siete alla ricerca di un modello LLM che combini prestazioni eccezionali con costi ragionevoli? Claude Sonnet 4, pubblicato da Anthropic nel maggio 2025, rappresenta esattamente quella soluzione equilibrata di cui hai bisogno. Questo modello è stato specificamente progettato per offrire capacità avanzate di codifica e ragionamento senza compromettere il budget, posizionandosi come l’alternativa più pratica all’interno della famiglia Claude 4.

A differenza del fratello maggiore Claude Opus 4, Sonnet 4 dà la priorità all’efficienza senza sacrificare la qualità, rendendolo la scelta ideale per gli sviluppatori e le aziende che cercano il massimo valore per il loro investimento.

Claude Sonnet Velocità 4

Ti stai chiedendo quanto velocemente può elaborare le tue richieste? Claude Sonnet 4 è ottimizzato per applicazioni ad alto volume, con limiti ufficiali che superano significativamente le versioni precedenti:

- 50 richieste al minuto (RPM)

- 30.000 token di input al minuto (ITPM)

- 8.000 token di output al minuto (OTPM)

Come conferma l’annuncio ufficiale di Anthropic: “Abbiamo aumentato i limiti di velocità API per Claude Sonnet 4”. Questo miglioramento consente di elaborare più dati senza raggiungere frequentemente i limiti, ridimensionare le applicazioni per servire più utenti contemporaneamente ed eseguire più chiamate API in parallelo.

Ricordiamo che Sonnet 4 implementa un innovativo sistema “cache-aware ITPM”. Solo i token di input non memorizzati nella cache vengono conteggiati ai fini dei limiti di velocità. Ad esempio, con un limite ITPM di 2.000.000 e una percentuale di riscontri nella cache dell’80%, è possibile elaborare in modo efficace 10.000.000 di token di input totali al minuto.

Claude Sonetto 4 Costo

La struttura dei prezzi di Claude Sonnet 4 è progettata per essere accessibile e prevedibile:

| Tipo di token | standard | Prezzo con cache (5 min) | Prezzo con cache (1 ora) | Riscontri nella cache |

| Token di ingresso | 2,86 EUR/IVA | 3,58 EUR/IVA | 5,73 EUR/IVA | 0,29 EUR/MTok |

| Token di output | 14,31 EUR/IVA | – | – | – |

È consigliabile usare la memorizzazione nella cache rapida per ottimizzare i costi, soprattutto se l’applicazione esegue query ripetitive. Per i contesti lunghi (più di 200K token) quando si utilizza la finestra di contesto 1M, si applica una commissione premium: 5,73 EUR per milione di token di input e 21,47 EUR per milione di token di output.

Se gestisci volumi di elaborazione elevati, l’API Batch ti offre uno sconto del 50%, riducendo il costo a 1,43 EUR/MTok per l’input e 7,16 EUR/MTok per l’output.

Claude Sonnet 4 finestra contestuale

Hai bisogno di elaborare documenti lunghi o avere lunghe conversazioni? Claude Sonnet 4 offre una finestra di contesto standard di 200K token (circa 150.000 parole o circa 500 pagine di testo), che consente di analizzare basi di codice complesse in un’unica interazione.

Per le organizzazioni con livello di utilizzo 4 e quelle con limiti personalizzati, Claude Sonnet 4 offre una finestra espansa fino a 1 milione di token in modalità beta. Questa funzionalità è disponibile tramite l’API Anthropic, Amazon Bedrock e Google Vertex AI, che consente:

- Analisi del codice su larga scala (fino a 75.000 righe di codice)

- Elaborazione dei documenti estremamente estesa

- Creazione di agenti di intelligenza artificiale con capacità di ragionamento a lungo termine

Per accedere a questa funzione, includi l’intestazione beta “context-1m-2025-08-07” nelle tue richieste API.

Miglior uso di Claude Sonnet 4

Claude Sonnet 4 eccelle soprattutto in questi scenari:

Codifica e sviluppo: con punteggi eccezionali in benchmark come SWE-bench (72,7%, superando leggermente Opus 4 con il 72,5%), è perfetto per le attività di programmazione, dalla generazione del codice al refactoring completo.

Agenti del servizio clienti: la sua efficienza e velocità lo rendono la scelta ideale per chatbot e assistenti virtuali ad alto volume che richiedono risposte rapide ma sofisticate.

Elaborazione dei documenti: Perfetto per riassumere, analizzare o estrarre informazioni da documenti di grandi dimensioni grazie alla sua ampia finestra contestuale.

Applicazioni aziendali convenienti: bilanciando prestazioni e costi, è la scelta preferita per le implementazioni che richiedono un’elaborazione intensiva mantenendo i vincoli di budget.

Un ulteriore vantaggio è la sua disponibilità gratuita attraverso l’interfaccia web di Claude, a differenza di Opus 4 che richiede un abbonamento a pagamento. Questo lo rende una risorsa preziosa se si desidera sperimentare modelli LLM ad alte prestazioni senza costi iniziali.

Grok 3

Fonte immagine: CometAPI

Cerchi un modello LLM con capacità di ragionamento avanzate? Grok 3, rilasciato da xAI nel febbraio 2025, potrebbe essere la soluzione di cui hai bisogno. Sviluppato sotto la direzione di Elon Musk, questo modello è stato addestrato utilizzando un impressionante data center con 200.000 unità di elaborazione grafica (GPU). Questo investimento computazionale, dieci volte maggiore rispetto al suo predecessore, si è tradotto in 200 milioni di ore di calcolo accumulate.

Che velocità offre Grok 3?

Ecco i risultati più importanti di Grok 3 in termini di velocità di elaborazione:

- Ha risolto un complesso puzzle di ragionamento logico in soli 67 secondi, mentre concorrenti come DeepSeek R1 hanno impiegato 343 secondi

- La sua modalità “Think” elaborava query complesse, generando codice di animazione 3D in 114 secondi

Inoltre, xAI offre una variante ottimizzata chiamata Grok 3 Mini, che dà la priorità alla velocità rispetto a un certo grado di precisione. Questa flessibilità ti consente di scegliere tra la massima potenza o risposte più agili in base alle tue esigenze specifiche.

Struttura dei costi di Grok 3

Di seguito, troverai la struttura dei prezzi che ti permetterà di valutare quale versione si adatta meglio al tuo budget:

| Modello | di input | Costo del token di output |

| Grok 3 | 2,86 EUR/milione | 14,31 euro per milione |

| Grok 3 Mini | 0,29 EUR/milione | 0,48 EUR/milione |

Come puoi vedere, Grok 3 Mini è circa 10 volte più economico per i token di input e 30 volte più economico per i token di output. Consigliamo questa variante se siete alla ricerca di un’alternativa economica per applicazioni ad alto volume.

L’accesso principale si ottiene tramite l’abbonamento X Premium+, al costo di 38,17 euro al mese negli Stati Uniti dopo un recente aumento da 20,99 euro. Puoi anche prendere in considerazione il piano “SuperGrok” pubblicizzato a 28,63 euro al mese che offrirà funzionalità più avanzate.

Capacità di contesto disponibile

Sia Grok 3 che Grok 3 Mini offrono una finestra contestuale di 131.072 token. Questa funzionalità consente di elaborare documenti lunghi e di avere lunghe conversazioni senza perdere informazioni contestuali rilevanti.

Ricorda che, sebbene possa teoricamente gestire fino a un milione di token, gli studi sugli utenti suggeriscono che le prestazioni ottimali vengono mantenute fino a circa 80.000 token. Oltre questa soglia, si potrebbe sperimentare un graduale degrado della coerenza.

Quando usare Grok 3?

Consigliamo Grok 3 in particolare per questi scenari:

Ragionamento matematico e scientifico: Ottieni risultati eccezionali in test come AIME (matematica) e GPQA (fisica, chimica e biologia), battendo concorrenti di alto livello.

Sviluppo del codice: genera codice più strutturato e funzionale rispetto ad altri modelli, soprattutto nelle applicazioni web e nelle interfacce utente. La sua capacità di produrre soluzioni HTML5 ottimizzate lo rende ideale se sei un programmatore.

Ricerca con DeepSearch: il suo motore di ricerca integrato esegue la scansione di Internet e del social network X fornendo risposte documentate più velocemente rispetto ad alternative come Gemini e OpenAI.

Scrittura creativa: Dimostra capacità di narrazione superiori con una migliore costruzione del personaggio e progressione della trama.

Generazione di contenuti con meno restrizioni: offri un approccio meno censurato, affrontando argomenti sensibili in modo più diretto quando esplicitamente richiesto.

Se avete bisogno di un modello LLM con forti capacità di ragionamento e siete alla ricerca di un equilibrio efficace tra velocità, costi e ampiezza del contesto, Grok 3 rappresenta un’opzione potente che dovreste prendere in considerazione nel 2025.

DeepSeek R1

Fonte immagine: DeepSeek

Siete alla ricerca di un modello LLM che combini la potenza di ragionamento con prezzi accessibili? DeepSeek R1, sviluppato in Cina e rilasciato nel gennaio 2025, potrebbe essere esattamente ciò di cui hai bisogno. Questo modello di ragionamento si basa su DeepSeek V3, ma incorpora miglioramenti significativi attraverso l’apprendimento per rinforzo (RL), rendendolo uno strumento eccezionalmente potente per la risoluzione di problemi matematici e logici, nonché per l’analisi scientifica.

DeepSeek R1 Velocità

Quando valuti DeepSeek R1, noterai che il suo approccio dà la priorità alla precisione rispetto alla velocità:

- Elabora circa 28 token al secondo

- È circa 6 volte più lento di o1-mini e due volte più lento di ChatGPT 4o

- Dedica più tempo al ragionamento profondo prima di generare risposte

Questa velocità più lenta ha una ragione: DeepSeek R1 si autocorregge durante la sua catena di pensiero, rilevando i propri errori prima di offrire la risposta finale. Se hai bisogno di risposte estremamente precise per compiti complessi, questo approccio deliberativo ti sarà vantaggioso, soprattutto quando la precisione è più importante della velocità immediata.

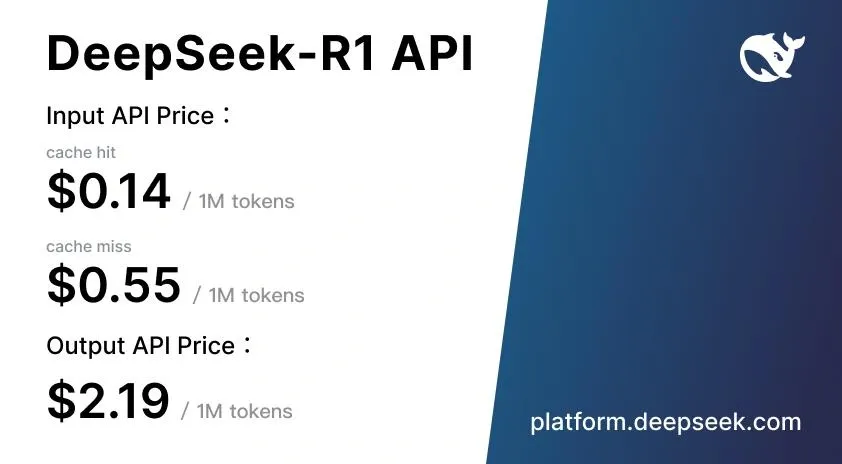

Costo di DeepSeek R1

Qui troverai uno dei vantaggi più importanti di DeepSeek R1: la sua struttura dei prezzi altamente competitiva.

| Tipo di token | Prezzo standard |

| Token di input (riscontro nella cache) | <citazione index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0.13 |

| Token di input (cache miss) | <indice delle citazioni=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”0,13 EUR |

| Token di output | <citazione index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0.13 |

Questi prezzi sono inferiori del 90-95% rispetto a OpenAI o1, che costa 14,31 euro per milione di token di input e 57,25 euro per milione di token di output. Inoltre, DeepSeek implementa un sistema di caching intelligente che offre un risparmio fino al 90% per query ripetute.

Ti consigliamo di provare DeepSeek R1 gratuitamente tramite la piattaforma web DeepSeek Chat, dove puoi sperimentare le sue funzionalità senza costi iniziali.

Finestra contestuale di DeepSeek R1

DeepSeek R1 gestisce una finestra di contesto di 128K token, consentendoti di:

- Elabora attività di ragionamento complesse e in più fasi

- Mantieni la coerenza tra documenti lunghi

- Segui complesse catene di ragionamento senza perdere informazioni

- Gestisci discussioni tecniche dettagliate mantenendo il contesto completo

Questa capacità pone DeepSeek R1 allo stesso livello di GPT-4o (128K), anche se inferiore a Claude 3.5 Sonnet (200K) e Gemini 1.5 Pro (2 milioni).

Miglior utilizzo di DeepSeek R1

DeepSeek R1 eccelle in particolare quando hai bisogno di:

- Risoluzione di problemi matematici e tecnici: ideale per la ricerca scientifica, l’ingegneria e la finanza

- Sviluppo software e codifica: competere efficacemente con Claude e OpenAI o1-mini nella programmazione automatizzata

- Attività di generazione aumentata dal recupero (RAG): funziona bene come GPT-4o con un ragionamento esplicito passo dopo passo

- Personalizzazione tramite open source: la tua licenza MIT consente modifiche per esigenze specifiche

- App per il mercato cinese: Appositamente ottimizzate per la comprensione della lingua cinese

Ricorda che DeepSeek R1 ha alcune importanti limitazioni. Le sue prestazioni multilingue sono scarse al di fuori dell’inglese e del cinese e non supporta l’analisi delle immagini, limitandone l’utilità nelle applicazioni multimodali.

Secondo il modello DeepSeek-R1-Zero, il ragionamento può nascere da zero utilizzando solo RL, consentendo di sviluppare funzionalità avanzate senza fare affidamento su dati etichettati. Ciò rende DeepSeek R1 particolarmente prezioso per i team di ricerca che desiderano esplorare nuove tecniche di addestramento dei modelli.

Gemelli 2.5 Pro

Fonte immagine: CometAPI

Introdotto nel marzo 2025, Gemini 2.5 Pro è il modello di ragionamento più avanzato che Google abbia sviluppato finora. Se stai cercando uno strumento in grado di risolvere problemi complessi, questo modello ti offre capacità di ragionamento avanzate e una finestra di contesto che cambierà il modo in cui elabori grandi volumi di informazioni.

Gemini 2.5 Pro Velocità

Ti chiedi cosa rende speciale la velocità della Gemini 2.5 Pro? A differenza di altri modelli LLM, questo sistema funziona in un modo unico: impiega circa 20 secondi sul ragionamento iniziale e poi genera token a una velocità straordinariamente elevata. Pensalo come un processo “pensa prima di rispondere” che ti fornisce un perfetto equilibrio tra analisi approfondita e velocità nella generazione dei contenuti.

Il modello supera notevolmente la velocità delle versioni precedenti senza compromettere la qualità del risultato. Inoltre, Google ha progettato la sua infrastruttura per evitare i tipici limiti di velocità che si verificano con altri sistemi concorrenti, assicurandoti un’esperienza più fluida anche quando lavori con attività complesse.

Gemini 2.5 Pro Costo

La struttura dei prezzi di Gemini 2.5 Pro varia a seconda del volume di token utilizzati e del tipo di elaborazione necessaria:

| Tipo di lavorazione | Token di ingresso | Token di output |

| Standard (≤200 gettoni) | 1,25 USD per milione | $ 10,00 per milione |

| Standard (>200 gettoni) | $ 2.50 per milione | $ 15.00 per milione |

| Elaborazione batch | 0,625 dollari per milione | $ 5.00 per milione |

Google offre anche un sistema di memorizzazione nella cache in grado di ridurre significativamente i costi per le query ripetitive, con prezzi a partire da 0,125 dollari per milione di token.

Per accedere a Gemini 2.5 Pro puoi scegliere tra l’abbonamento Google AI Pro (21,99 €/mese) o Google AI Ultra (274,99 €/mese) se hai bisogno di limiti di utilizzo più elevati.

Finestra contestuale di Gemini 2.5 Pro

Una delle caratteristiche che ti impressioneranno di più di Gemini 2.5 Pro è la sua straordinaria finestra di contesto di 1.048.576 token, con l’intenzione di espanderla a 2 milioni nei futuri aggiornamenti. Cosa significa questo per te in termini pratici?

- È possibile elaborare fino a 1.500 pagine di testo contemporaneamente

- Analizza 30.000 righe di codice in un’unica operazione

- Avere conversazioni estese senza perdere informazioni contestuali

Questa ampia capacità contestuale semplifica l’analisi di interi documenti, basi di codice estese e set di dati complessi in un’unica sessione.

Miglior utilizzo di Gemini 2.5 Pro

Consigliamo Gemini 2.5 Pro soprattutto per:

- Sviluppo Web avanzato: guida la classifica WebDev Arena nella creazione di applicazioni web funzionali ed esteticamente accattivanti

- Ragionamento complesso: ideale quando è necessario risolvere problemi di matematica, scienze e sfaccettati che richiedono un’analisi passo dopo passo

- Trasformazione e modifica del codice: particolarmente efficace per l’automazione di complesse attività di programmazione

- Elaborazione multimodale: capacità di comprendere input di testo, codice, immagini, audio e video

Se sei uno sviluppatore, un ricercatore o un professionista che ha bisogno di elaborare grandi volumi di informazioni multimodali con un ragionamento profondo e preciso, questo modello sarà particolarmente prezioso per te.

Claude 4 Opus

Fonte immagine: CometAPI

Cerchi il modello LLM più potente per la programmazione avanzata? Claude Opus 4, lanciato nel maggio 2025, rappresenta la proposta premium di Anthropic e si posiziona come “il miglior modello di programmazione al mondo” secondo il suo produttore. Questa versione stabilisce un nuovo standard nell’intelligenza artificiale conversazionale, appositamente progettata per il ragionamento profondo e le attività di codifica complesse.

Claude Velocità 4 Opus

Claude Opus 4 offre una notevole potenza di elaborazione, con limiti ufficiali fissati a:

- 50 richieste al minuto (RPM)

- 30.000 token di input al minuto (ITPM)

- 8.000 token di output al minuto (OTPM)

Cosa rende davvero speciale questo modello? La sua capacità unica di sostenere sessioni di lavoro prolungate. Mentre altri concorrenti perdono consistenza dopo un’ora o due, Claude Opus 4 può lavorare ininterrottamente fino a sette ore senza degrado delle prestazioni. Questa funzione è essenziale se si lavora su progetti di programmazione complessi che richiedono una concentrazione prolungata.

Claude 4 Opus Costo

Ti consigliamo di considerare attentamente il tuo budget, poiché Claude Opus 4 rappresenta un investimento premium:

| Tipo di token | standard | Con elaborazione batch |

| Entrata | 14,31 EUR/IVA | 7,16 EUR/IVA |

| Uscita | 71,57 EUR/IVA | 35,78 EUR/IVA |

Questi prezzi collocano l’Opus 4 ai vertici del mercato. Tuttavia, è possibile ottimizzare i costi utilizzando i meccanismi offerti da Anthropic: caching rapido (riduzione dei costi fino al 90%) ed elaborazione batch (con uno sconto del 50%).

Finestra contestuale di Claude 4 Opus

Claude Opus 4 ha una finestra di contesto di 200.000 token, paragonabile al suo predecessore ma inferiore ai 1.048.576 token di Gemini 2.5 Pro. Si noti che questa limitazione può essere restrittiva per basi di codice estremamente grandi, ma è sufficiente per la maggior parte delle applicazioni pratiche.

Il modello incorpora una caratteristica unica: il “pensiero esteso”, una modalità che consente di passare dal ragionamento interno all’uso di strumenti esterni. Questa funzionalità migliora significativamente la capacità di risolvere problemi sofisticati.

Miglior uso di Claude 4 Opus

Quando scegliere Claude Opus 4? Si distingue in particolare in questi casi:

- Compiti di codifica complessi: SWE-bench guida il benchmark con il 72,5% e Terminal-bench con il 43,2%, superando concorrenti come GPT-4.1 (54,6%) e Gemini 2.5 Pro (63,2%).

- Ragionamento scientifico avanzato: raggiunge il 79,6% in GPQA Diamond (83,3% in modalità di calcolo elevato).

- Agenti AI autonomi: la sua lunga finestra di attenzione lo rende ideale per attività che richiedono migliaia di passaggi e ore di elaborazione continua.

- Refactoring del progetto: è possibile analizzare e modificare intere basi di codice in un’unica sessione.

Se sei uno sviluppatore professionista, un ricercatore o fai parte di team che creano agenti di intelligenza artificiale avanzati e hai bisogno del massimo livello di prestazioni, Claude Opus 4 rappresenta la tua scelta ottimale.

OpenAI o3

Fonte immagine: Apidog

OpenAI presenterà il suo modello o3 nell’aprile 2025, che segna un punto di svolta nel ragionamento artificiale. A differenza dei modelli di cui abbiamo parlato in precedenza, o3 è specificamente progettato per “pensare più a lungo prima di rispondere”, integrando capacità di ragionamento avanzate con l’accesso autonomo agli strumenti.

Che velocità offre OpenAI o3?

Sebbene o3 dia la priorità alla riflessione profonda, mantiene un’efficienza che ti sorprenderà:

- Supera il throughput o1 mantenendo la stessa latenza

- La sua architettura consente un ragionamento prolungato senza compromettere la velocità di risposta

- La versione o3-mini mostra tempi più veloci del 24% (7,7 secondi rispetto ai 10,16 secondi dell’o1-mini)

Rispetto ad altri modelli di ragionamento, o3 riesce a completare compiti complessi di solito in meno di un minuto, trovando un equilibrio efficace tra analisi profonda e agilità di risposta.

Struttura dei prezzi di OpenAI o3

Sarai felice di sapere che OpenAI ha ridotto significativamente i prezzi di o3:

| Tizio | originale | Prezzo attuale (80% di sconto) |

| Token di ingresso | 9,54 €/milione | 1,91 €/milione |

| Token di output | 38,17 €/milione | 7,63 €/milione |

| Input cache | – | 0,48 €/milione |

Questa riduzione posiziona o3 in modo competitivo rispetto a Gemini 2.5 Pro (0,95 euro/milione di input, 9,54 €/milione di output) e Claude Sonnet 4 (2,86 €/milione di input, 14,31 €/milione di output).

Funzionalità di contesto OpenAI o3

O3 offre straordinarie funzionalità contestuali che dovresti considerare:

- Gestisce fino a 128.000 token nelle distribuzioni standard

- Raggiungi 200.000 token in ambienti specifici

- Genera fino a 100.000 token di output

Questa ampiezza contestuale consente di analizzare documenti lunghi, codice complesso e di avere lunghe conversazioni senza perdita di coerenza.

Quando usare OpenAI o3?

Consigliamo o3 soprattutto per questi casi d’uso:

Programmazione di alto livello: è in testa a SWE-bench con il 71,7%, superando significativamente o1 (48,9%), il che lo rende la scelta migliore per lo sviluppo complesso.

Risoluzione matematica avanzata: con il 96,7% in AIME rispetto all’83,3% in o1, è l’ideale se hai bisogno di una precisione matematica eccezionale.

Ricerca scientifica: Raggiunge l’87,7% in GPQA Diamond, dimostrando padronanza in questioni scientifiche altamente complesse.

Analisi visiva integrata: incorpora le immagini nel tuo ragionamento, permettendoti di analizzare diagrammi e grafici in modo contestuale.

Automazione con strumenti: combina autonomamente la ricerca web, l’analisi dei file e l’esecuzione di codice Python.

Inoltre, o3 si integra con la CLI di Codex, consentendo agli sviluppatori che desiderano semplificare il proprio flusso di lavoro di sfruttare le sue funzionalità direttamente dalla riga di comando.

Tabella di confronto

Hai bisogno di una rapida occhiata per confrontare tutti questi modelli? Ecco una tabella riassuntiva per aiutarti a identificare quale si adatta meglio alle tue esigenze specifiche.

Ricorda che ogni modello ha i suoi punti di forza particolari. Questo confronto ti consentirà di valutare rapidamente le principali differenze tra velocità, costi e funzionalità:

| Modello | Velocità | Costo (per milione di token) | Finestra | Casi d’uso ottimali |

| GPT-4o | 110 gettoni/secondo | Buy-in: €0.01/1.000 gettoni Produzione: 0,03 €/1.000 token |

128.000 token | • Conversazioni in tempo reale• Elaborazione multilingue • Analisi visiva • Trascrizione audio |

| Sonetto di Claude 4 | 50 richieste/min | Buy-in: €2.86 Produzione: 14,31 |

200.000 token (espandibili a 1 milione) | • Codifica • Assistenza clienti • Elaborazione documenti • Applicazioni aziendali |

| Grok 3 | 67 secondi (prove logiche) | Buy-in: €2.86 Produzione: 14,31 |

131.072 token• | Ragionamento matematico • Sviluppo di codice • Ricerca • Scrittura creativa |

| DeepSeek R1 | 28 gettoni/secondo | Buy-in: €0.52 Produzione: 2,09 |

128.000 token• | Risoluzione di problemi matematici • Sviluppo software • RAG• Mercato cinese |

| Gemelli 2.5 Pro | 20 secondi iniziali + alta velocità | Ingresso: $ 1,25 Produzione: $ 10,00 |

1.048.576 token• | Sviluppo web • Ragionamento complesso • Trasformazione del codice • Elaborazione multimodale |

| Claude 4 Opus | 50 richieste/min | Ingresso: 14,31 €Produzione: 71,57 |

200.000 token• | Codifica complessa • Ragionamento scientifico • Agenti autonomi di intelligenza artificiale• Refactoring |

| OpenAI o3 | N/A | Ingresso: 1,91 €Produzione: 7,63 |

128.000 token (espandibile a 200K) | • Programmazione avanzata • Matematica • Scienze • Ragionamento visivo |

Se stai cercando l’opzione più economica, DeepSeek R1 offre prezzi imbattibili. Per la massima velocità nelle applicazioni multimodali, GPT-4o è la migliore alternativa. Hai bisogno di elaborare documenti lunghi? Gemini 2.5 Pro con la sua enorme finestra contestuale sarà perfetto per te.

Ti consigliamo di valutare i tuoi casi d’uso specifici prima di decidere su un modello. La maggior parte offre versioni gratuite in modo da poterle provare senza costi iniziali.

Conclusione

Quale modello LLM si adatta meglio alle tue esigenze specifiche? La risposta dipende interamente dai casi d’uso specifici e dal budget disponibile.

Ricorda che ogni modello ha i suoi punti di forza. GPT-4o eccelle quando hai bisogno di risposte multimodali rapide, mentre Claude Sonnet 4 ti offre un eccezionale equilibrio tra prestazioni e costi. Se lavori con un ragionamento matematico complesso, Grok 3 potrebbe essere la tua migliore opzione.

Cerchi l’alternativa più economica? DeepSeek R1 rappresenta un’opzione straordinaria, soprattutto se è necessario risolvere problemi tecnici complessi senza compromettere il budget. Per elaborare documenti lunghi o enormi basi di codice, Gemini 2.5 Pro consente di gestire più di un milione di token in una singola sessione.

Se hai intenzione di utilizzare questi modelli per lo sviluppo professionale che richiede le massime prestazioni, Claude 4 Opus stabilisce gli standard più elevati nella codifica avanzata. D’altra parte, OpenAI o3 eccelle particolarmente nella programmazione e nella matematica con capacità visive integrate.

La cosa interessante dei modelli è che possono essere utilizzati nei nostri agenti di intelligenza artificiale con n8n. Attraverso i nostri modelli, puoi utilizzare tutta la potenza dei diversi modelli nei tuoi flussi di lavoro per raggiungere qualsiasi obiettivo che ti sei prefissato.

Come scegliere il modello ideale?

Ti consigliamo di considerare questi aspetti chiave:

Passaggio 1: definisci il tuo caso d’uso principale

- Hai bisogno di elaborare grandi volumi di documenti? Gemini 2.5 Pro o Claude Sonnet 4 sono le migliori alternative.

- Dai la priorità alle conversazioni interattive rapide? GPT-4o ti offrirà la migliore esperienza.

- Lavori con problemi matematici complessi? DeepSeek R1 o Grok 3 eccellono in questi compiti.

Passaggio 2: valuta il tuo budget

- Per applicazioni ad alto volume con un budget limitato: DeepSeek R1

- Per un equilibrio qualità-prezzo: Claude Sonnet 4

- Per le massime prestazioni senza restrizioni di costo: Claude 4 Opus

Passaggio 3: sperimenta prima di decidere Fortunatamente, la maggior parte di questi modelli offre versioni gratuite o crediti di prova. Provalo gratuitamente con tutti i modelli che ritieni validi per il tuo caso d’uso specifico.

La concorrenza tra gli sviluppatori continua a portare a miglioramenti costanti in termini di velocità, riduzione dei costi ed espansione della capacità. Ciò significa che probabilmente nel corso del 2025 vedrai aggiornamenti significativi che andranno direttamente a vantaggio della tua distribuzione.

Se hai bisogno di integrare questi modelli nei tuoi sistemi esistenti come CRM, ERP o applicazioni specifiche, ricorda che molti offrono API robuste e una documentazione dettagliata per facilitare l’integrazione.

La scelta del modello giusto può fare la differenza tra un’implementazione di successo e un investimento sprecato male. Prenditi il tempo necessario per valutare ogni opzione con i tuoi dati effettivi prima di impegnarti in una distribuzione su larga scala.

ANNEX, nuovo modello ChatGPT-5

Fonte immagine: OpenAI

Nell’aprile 2025, OpenAI ha introdotto ChatGPT-5, l’evoluzione più significativa dopo GPT-4, consolidando la sua posizione di punto di riferimento nei modelli linguistici multimodali. Questo nuovo sistema non solo migliora la velocità e il costo per token, ma introduce una comprensione contestuale molto più profonda e una memoria attiva che cambia il modo in cui interagisci con l’IA.

Velocità e prestazioni

ChatGPT-5 offre prestazioni 2,3 volte superiori a quelle di GPT-4o, raggiungendo una velocità media di 250 token al secondo con latenze di risposta inferiori a 180 millisecondi in modalità vocale. Questo salto è dovuto a un’architettura di inferenza ottimizzata e all’elaborazione unificata di testo, audio, immagini e video all’interno di una singola rete neurale.

Il risultato è un’esperienza più fluida, soprattutto nelle applicazioni in tempo reale o negli ambienti di assistenza conversazionale continua.

Contesto e capacità di memoria

Uno dei maggiori progressi di ChatGPT-5 è la sua finestra di contesto ampliata a 512.000 token (1 milione nella versione enterprise), che consente di analizzare documenti estesi, repository di codice o interi report aziendali senza frammentare le informazioni.

Inoltre, incorpora la memoria persistente, che conserva la cronologia delle interazioni, le preferenze di stile e il contesto utente tra le sessioni. Ciò consente un adattamento progressivo e risposte più coerenti nel tempo.

Costi ed efficienza

OpenAI è riuscita a ridurre i costi di circa il 60% rispetto a GPT-4o. Il prezzo medio per 1.000 token è di circa 0,012 euro, rendendo ChatGPT-5 la versione più economica ed efficiente della serie fino ad oggi.

Questo miglioramento consente di scalare i progetti aziendali e i flussi di automazione complessi senza compromettere la precisione o la velocità.

Integrazione e automazione

ChatGPT-5 estende l’interoperabilità dei modelli precedenti attraverso il supporto nativo per il Model Context Protocol (MCP). Grazie a questo livello standard, è possibile connettersi direttamente con strumenti come n8n, Zapier, Make, CRM o ERP, eseguendo attività automatizzate e mantenendo il contesto tra i sistemi.

Il suo supporto API esteso consente inoltre la generazione e la convalida dei dati in tempo reale, ideale per flussi con agenti autonomi o processi di verifica.

Esperienza di conversazione migliorata

Nella sezione vocale, ChatGPT-5 raggiunge un notevole livello di naturalezza. Riconosce le intonazioni, le pause e le emozioni in modo più accurato, offrendo un dialogo che è praticamente indistinguibile dal dialogo umano.

Il sistema adegua il tono in base al contesto – informativo, tecnico o commerciale – e mostra una migliore comprensione di lingue diverse dall’inglese, correggendo uno dei punti deboli di GPT-4.

Riepilogo comparativo

| Caratteristica | GPT-4 | GPT-4o | ChatGPT-5 |

|---|---|---|---|

| Velocità media | 60 gettoni/s | 110 gettoni/s | 250 gettoni/s |

| Finestra contestuale | 8K – 128K | 128 mila | 512 K – 1 M |

| Modalità | Testo | Testo, audio, immagine | Testo, audio, immagine, video |

| Memoria persistente | No | Parziale | Sì, tra una sessione e l’altra |

| Costo approssimativo | €0,03/1K | 0,015 €/1K | 0,012 €/1K |

| Integrazione | API | API | API + MCP (n8n, Zapier, ecc.) |

Conclusione

ChatGPT-5 rappresenta la maturità dell’approccio “omni” di OpenAI.

La sua combinazione di maggiore velocità, costi ridotti, contesto ampliato e memoria reale lo posiziona come il modello più equilibrato per il 2025.

Inoltre, la sua integrazione con strumenti di automazione come n8n apre nuove possibilità per la creazione di agenti di intelligenza artificiale che si connettono, pensano e agiscono su dati reali senza intervento manuale.

FAQs

Domanda 1. Qual è il modello LLM più veloce disponibile nel 2025? GPT-4o si distingue per la sua velocità, elaborando 110 token al secondo e offrendo risposte audio in soli 232 millisecondi, rendendolo ideale per conversazioni in tempo reale e applicazioni che richiedono risposte rapide.

Domanda 2. Quale modello offre il miglior rapporto qualità-prezzo? DeepSeek R1 si posiziona come l’opzione più economica, con prezzi fino al 90-95% inferiori a quelli di concorrenti come OpenAI, pur mantenendo alte prestazioni nelle attività di ragionamento e sviluppo software.

Domanda 3. Qual è il modello più adatto per l’elaborazione di grandi volumi di informazioni? Gemini 2.5 Pro eccelle con la sua impressionante finestra di contesto di 1.048.576 token, che consente di elaborare fino a 1.500 pagine di testo contemporaneamente, rendendolo ideale per l’analisi di documenti di grandi dimensioni e basi di codice complesse.

Domanda 4. Qual è il modello più avanzato per le attività di programmazione? Claude 4 Opus è considerato “il miglior modello di programmazione al mondo”, leader di benchmark come SWE-bench con prestazioni del 72,5% ed eccelle in complesse attività di codifica e refactoring di interi progetti.

Domanda 5. Come si sono evoluti i costi dei modelli LLM nel 2025? I costi sono diminuiti in modo significativo. Ad esempio, OpenAI o3 ha ridotto i suoi prezzi dell’80%, offrendo tariffe competitive di 1,91 euro per milione di token di input e 7,63 euro per milione di token di output, rendendo i modelli avanzati più accessibili.