Neste artigo, você aprenderá tudo o que precisa saber sobre Large Language Models (LLMs) de forma prática e simples. Você descobrirá o que exatamente são, como funcionam internamente e quais são suas aplicações mais importantes em 2025. Você também aprenderá sobre os riscos que deve levar em consideração e como escolher o modelo mais adequado às suas necessidades.

Se você já se perguntou como ChatGPT, Claude ou Gemini podem entender e gerar texto quase como um humano, aqui estão as respostas. Mostraremos tudo, desde o básico até as tendências mais avançadas, sempre com exemplos práticos que você pode aplicar.

Pontos-chave

Os LLMs representam uma revolução tecnológica que está transformando a maneira como interagimos com as máquinas e processamos informações. Aqui estão os pontos essenciais que você deve saber:

• LLMs são modelos de IA especializados em linguagem que usam arquiteturas Transformer para processar trilhões de parâmetros e gerar texto semelhante ao humano.

• Seu treinamento requer recursos massivos: o GPT-3 consumiu 1.287 MWh de eletricidade e produziu mais de 500 toneladas de CO2, o equivalente a 600 voos transatlânticos.

• As aplicações práticas incluem geração de conteúdo, tradução multilíngue, conversão de código e assistentes virtuais que economizam de 30 a 90% do tempo em tarefas rotineiras.

• Os principais riscos são alucinações (2,5-15% de respostas falsas), preconceitos herdados de dados de treinamento e vulnerabilidades de privacidade e segurança.

• O futuro aponta para modelos multimodais mais eficientes, contextos de até 2 milhões de tokens e regulamentação responsável, como a nova lei europeia de IA.

Compreender esses recursos e limitações permitirá que você aproveite o potencial dos LLMs enquanto navega com responsabilidade neste cenário tecnológico em constante evolução.

O que é um LLM ou ‘Large Language Model’?

Imagine um sistema que pode ler milhões de livros, artigos e páginas da web em questão de dias e, em seguida, usar todo esse conhecimento para manter conversas, escrever textos ou resolver problemas complexos. Isso é exatamente o que um Large Language Model faz.

Um LLM é um tipo de inteligência artificial especializada em entender e gerar linguagem humana. Ao contrário dos programas tradicionais que seguem regras específicas, esses modelos aprendem padrões de linguagem analisando grandes quantidades de texto. O resultado é incrível: eles podem escrever como pessoas, traduzir idiomas, codificar códigos ou responder a perguntas sobre praticamente qualquer assunto.

Por que eles são tão importantes agora? Porque eles atingiram um nível de sofisticação que lhes permite realizar tarefas que antes só podiam ser feitas por humanos. ChatGPT, Claude, Gêmeos… todos esses nomes que você ouve constantemente são exemplos de LLMs que estão mudando a maneira como trabalhamos, estudamos e nos comunicamos.

O que é um LLM ou ‘Large Language Model’?

Definição técnica de LLM

Um Large Language Model (LLM) é um sistema de inteligência artificial treinado em grandes quantidades de texto que pode entender e gerar linguagem humana de uma maneira surpreendentemente natural. Pense nisso como um programa que “leu” milhões de livros, artigos e páginas da web e agora pode manter conversas, escrever textos e responder a perguntas de forma consistente.

A base técnica desses modelos são os transformadores, uma arquitetura de redes neurais que funciona como um sofisticado sistema de atenção. Imagine que você está lendo uma frase: os transformadores podem “olhar” para todas as palavras ao mesmo tempo e entender como elas se relacionam umas com as outras, em vez de processá-las uma a uma, como os sistemas anteriores faziam.

Durante o treinamento, esses sistemas aprendem a prever qual palavra vem a seguir em um texto, desenvolvendo gradualmente uma compreensão profunda da gramática, significado e contexto. É um processo de autoaprendizagem em que o modelo descobre padrões linguísticos sem que ninguém lhe ensine regras específicas.

Diferença entre LLM e outros modelos de IA

Você já se perguntou o que torna os LLMs especiais em comparação com outros tipos de inteligência artificial? A principal diferença está em sua especialização e foco.

Embora a IA seja um termo amplo que inclui qualquer sistema que imite as capacidades humanas, os LLMs se concentram exclusivamente na linguagem. Outros modelos de IA podem ser projetados para reconhecer imagens, prever tendências de mercado ou controlar robôs, mas os LLMs são especialistas apenas em entender e gerar texto.

As principais diferenças incluem:

- Especialização em idiomas: os LLMs dominam tarefas como traduzir, resumir ou escrever, enquanto outros modelos de IA se concentram em áreas completamente diferentes, como visão computacional ou análise de dados.

- Arquitetura específica: eles usam transformadores otimizados para captar relacionamentos entre palavras, algo que outros tipos de IA não exigem necessariamente.

- Recursos generativos: muitos LLMs podem criar conteúdo original, embora a IA generativa englobe mais do que texto, incluindo imagens, música e código.

Por que eles são chamados de modelos de linguagem ‘grandes’?

O termo “grande” não é um hype publicitário. Ele se refere a três aspectos que são realmente impressionantes por sua magnitude:

Tamanho do parâmetro: Os LLMs contêm trilhões de parâmetros, que são como os “ajustes internos” que determinam como eles funcionam. Para se ter uma ideia da escala, o GPT-3 tem 175.000 milhões de parâmetros, enquanto o Jurassic-1 tem 178.000 milhões. É como se eles tivessem milhões de pequenas decisões programadas dentro deles.

Volume de dados de treinamento: esses modelos processaram grandes quantidades de texto da Internet. Estamos falando do Common Crawl com mais de 50.000 milhões de páginas da web e da Wikipedia completa com seus 57 milhões de artigos. Isso é mais informação do que qualquer um poderia ler em várias vidas.

Capacidade computacional: Treinar um LLM requer supercomputadores trabalhando por semanas ou meses. Cada um desses trilhões de parâmetros deve ser ajustado, o que exige um poder de computação extraordinário.

Os modelos mais proeminentes que você pode usar atualmente incluem:

- GPT da OpenAI , conhecido por sua capacidade de raciocínio e respostas coerentes

- Claude que pode analisar documentos muito longos com até 100.000 tokens

- Meta Flame , otimizado para aplicações práticas do mundo real

- Google DeepMind’s Gemini , já integrado ao Gmail e outros serviços que você provavelmente usa no dia a dia

Cada um tem pontos fortes particulares, mas todos compartilham aquela característica “grande” que os torna tão poderosos no trabalho com a linguagem humana.

Arquitetura de modelos LLM: como eles são construídos

Você já se perguntou o que está por trás da capacidade do ChatGPT de manter uma conversa coerente? Nesta seção, você descobrirá como esses sistemas são construídos por dentro. Mostraremos de forma simples os principais componentes que permitem que os LLMs entendam e gerem texto como se fossem humanos.

Lembre-se de que, embora a arquitetura possa parecer complexa no início, entendê-la ajudará você a escolher melhor qual modelo usar de acordo com suas necessidades.

Redes neurais profundas e camadas de atenção

Os LLMs funcionam por meio de redes neurais de várias camadas que imitam, de alguma forma, o funcionamento do cérebro humano. Pense nessas redes como uma série de filtros interconectados, onde cada camada processa e refina as informações recebidas da camada anterior.

A principal diferença com os modelos tradicionais é o número de camadas. Enquanto os sistemas antigos usavam uma ou duas camadas, os LLMs de hoje empregam centenas ou até milhares de camadas para processar informações. Cada nó nessas camadas tem um peso e limite específicos que determinam se ele deve ser ativado e passar informações para a próxima camada.

Dentro dessa arquitetura, você encontrará três tipos principais de camadas:

- Camadas de inserção: converta palavras em números que o modelo possa entender

- Camadas de atenção: ajude o modelo a identificar quais partes do texto são mais importantes

- Camadas de alimentação direta: processe todas essas informações para gerar a resposta final

Transformadores e autocuidado

É aqui que a mágica realmente acontece. Os Transformers, introduzidos em 2017, mudaram completamente o jogo. Essa arquitetura permite que o modelo processe todas as palavras em uma frase ao mesmo tempo, em vez de palavra por palavra.

O mecanismo de autocuidado está no centro dessa tecnologia. Funciona avaliando a relação entre cada palavra e todas as outras palavras do texto. Por exemplo, na frase “O cachorro no parque late alto”, o sistema entende que “late” se refere a “cachorro”, não a “parque”.

Essa capacidade de entender relacionamentos de longa distância era muito difícil para os modelos anteriores. Além disso, ao processar tudo em paralelo, o treinamento é muito mais rápido e eficiente.

Os transformadores usam dois componentes principais: um codificador que entende o texto de entrada e um decodificador que gera a resposta. No entanto, alguns modelos, como o GPT, usam apenas a parte do decodificador.

Tokenização e incorporações

Antes de processar qualquer texto, os LLMs precisam convertê-lo em números usando tokenização. Esse processo divide o texto em pequenas unidades chamadas tokens.

O método mais comumente usado é o Byte Pair Encoding (BPE), que identifica as combinações de letras mais frequentes e as converte em tokens. Isso permite que o modelo lide com novas palavras, nomes próprios e até erros de digitação de forma inteligente.

Uma vez tokenizada, cada palavra é convertida em um vetor numérico chamado incorporação. Esses vetores capturam o significado das palavras de tal forma que palavras semelhantes têm números semelhantes.

Finalmente, como os Transformers processam tudo simultaneamente, eles precisam saber a ordem das palavras. Para fazer isso, eles usam codificações posicionais que são adicionadas a cada incorporação. Assim, o modelo entende que “Maria ama João” é diferente de “João ama Maria”.

Se você tiver alguma dúvida sobre esses conceitos técnicos, recomendamos começar com os aspectos mais práticos e depois se aprofundar nos detalhes de acordo com suas necessidades específicas.

Treinamento de um modelo LLM: quanto custa realmente?

Criar um modelo de linguagem grande não é como instalar um programa em seu computador. É um processo que consome recursos massivos e determina se o modelo será útil ou não. Aqui está tudo o que você precisa saber sobre esse processo.

Como os LLMs aprendem? Dois métodos principais

Existem duas maneiras principais de treinar esses modelos, cada uma com suas próprias vantagens:

Pré-treinamento autorregressivo: Modelos como o GPT funcionam como um sistema de conclusão de frases. Eles aprendem a prever qual será a próxima palavra com base em todas as palavras anteriores. É como quando você digita no seu celular e ele sugere a próxima palavra.

Pré-treino mascarado: Modelos como o BERT usam um método diferente. Palavras aleatórias ficam escondidas em um texto e o modelo deve adivinhar quais estão faltando. É como fazer um exercício de preenchimento de lacunas.

A principal diferença é que os modelos autorregressivos olham apenas para trás para prever, enquanto os modelos mascarados podem olhar para trás e para frente, obtendo uma compreensão mais completa do contexto.

Os custos reais: números que vão te surpreender

Treinar um LLM é extraordinariamente caro. Para lhe dar uma ideia clara:

Consumo massivo de energia: GPT-3 precisava de 1.287 MWh de eletricidade para seu treinamento. Isso equivale ao consumo anual de mais de 100 famílias.

Pegada de carbono significativa: O processo gerou mais de 500 toneladas métricas de CO2, comparável a 600 voos entre Nova York e Londres ou o que 38 famílias espanholas produzem em um ano inteiro.

Alto investimento econômico:

- Um modelo com 1.500 milhões de parâmetros custou 0,95 milhões de euros em 2020

- GPT-3 (175 bilhões de parâmetros) custou aproximadamente € 3,82 bilhões

- GPT-4 ultrapassou os 95,42 milhões de euros devido à sua maior complexidade

Lembre-se de que esses custos são divididos em duas fases: o treinamento inicial consome 20-40% da energia total, mas ocorre apenas uma vez. A fase de uso contínuo pode representar 50-60% do gasto de energia a longo prazo.

Você sabia que a geração de imagens consome 2.907 kWh por 1.000 operações, enquanto a geração de texto precisa apenas de 0.047 kWh? A geração de texto é muito mais eficiente.

Como eles aprendem sem supervisão humana?

O aprendizado auto-supervisionado é a chave para LLMs bem-sucedidos. Ao contrário dos métodos tradicionais que precisam de dados rotulados manualmente, esses modelos geram seus próprios rótulos a partir de texto bruto.

O processo funciona assim: o modelo aprende a prever partes ausentes do texto ou a próxima palavra em uma sequência. Isso permite que você treine com grandes quantidades de texto da Internet sem a necessidade de marcação manual.

O processo é dividido em duas etapas:

Etapa 1: Tarefas de pretexto – O modelo aprende representações da linguagem por meio de tarefas como prever palavras ocultas ou completar sequências.

Etapa 2: Tarefas específicas – As representações aprendidas são aplicadas a tarefas específicas, como tradução ou classificação de texto.

Existem duas técnicas principais:

- Aprendizado autopreditivo: o modelo prevê partes dos dados com base em outras partes

- Aprendizagem contrastiva: o modelo aprende a distinguir relações entre diferentes amostras de dados

Essa metodologia permite aproveitar com eficiência os enormes recursos computacionais necessários para criar LLMs cada vez mais poderosos.

Aplicações práticas de LLMs em 2025

Os LLMs não são mais apenas experimentos de laboratório. Até 2025, essas ferramentas resolvem problemas reais em empresas de todos os setores. Aqui estão os aplicativos mais úteis que você pode implantar hoje.

Geração automática de texto e resumos

Você precisa processar grandes volumes de informações rapidamente? Os LLMs se destacam em sua capacidade de criar conteúdo original e resumir documentos longos, mantendo os pontos-chave.

A criação de resumos automáticos permite que você economize tempo e recursos significativos ao processar informações. Essa funcionalidade é especialmente valiosa para:

- Artigos de pesquisa e documentação técnica

- Documentos Legais e Financeiros

- Feedback do cliente e análise de tendências

- Relatórios de negócios e pesquisas de mercado

Existem dois métodos principais que você pode usar. O resumo extrativo identifica e extrai as frases mais relevantes do texto original, enquanto o resumo abstrato gera novas frases que capturam a essência do conteúdo. Dependendo de suas necessidades, você pode obter qualquer coisa, desde resumos curtos até análises detalhadas.

Ferramentas mais avançadas também fornecem pontuações de classificação para avaliar a relevância das frases extraídas e informações posicionais para localizar os elementos mais importantes.

Tradução multilíngue e conversão de código

Se você trabalha com várias linguagens ou precisa modernizar códigos antigos, os LLMs oferecem soluções precisas que superam os métodos tradicionais.

Para tradução, esses modelos capturam nuances culturais e preservam o tom do texto original. O modelo DeepL supera ChatGPT-4, Google e Microsoft em qualidade, exigindo significativamente menos revisão: enquanto o Google precisa do dobro de correções e ChatGPT-4 triplica para atingir a mesma qualidade.

Em termos de conversão de código, os LLMs provaram ser extraordinariamente eficazes na migração de sistemas legados. A ferramenta CodeScribe, por exemplo, combina engenharia imediata com supervisão humana para converter com eficiência o código Fortran em C++.

Os resultados são impressionantes: enquanto antes do uso do LLM você podia converter de 2 a 3 arquivos por dia, com essas ferramentas a produtividade aumenta para 10 a 12 arquivos por dia.

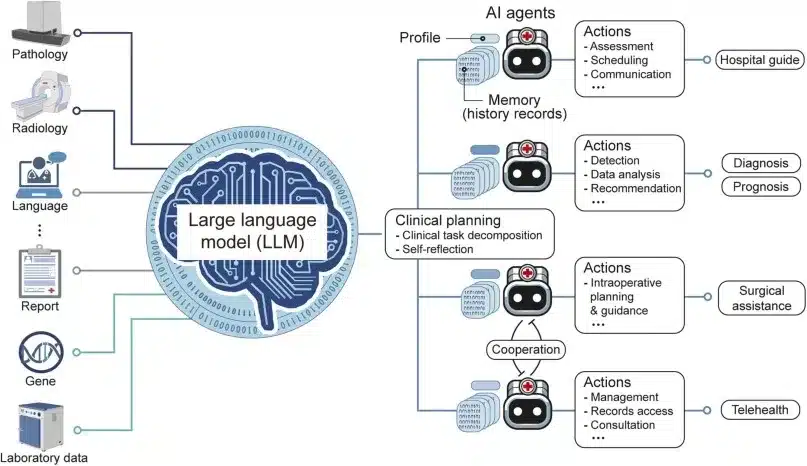

Assistentes virtuais e chatbots de negócios

Quer automatizar o atendimento ao cliente ou melhorar os processos internos? Os assistentes com tecnologia LLM mantêm conversas fluidas, entendem questões complexas e se adaptam ao estilo de cada usuário.

Lembre-se de que há uma diferença importante: os assistentes de IA são reativos e executam tarefas sob demanda, enquanto os agentes de IA são proativos e trabalham de forma autônoma para atingir objetivos específicos.

Um estudo entre 167 empresas identificou o atendimento ao cliente como o caso de uso mais popular para a adoção de agentes LLM. Em operações internas, esses agentes podem economizar de 30% a 90% do tempo gasto em tarefas rotineiras.

O suporte automatizado permite que você responda a consultas 24 horas por dia, forneça informações consistentes e personalize a experiência com base no histórico do cliente. Em vendas, você pode usá-los para qualificar clientes em potencial e coletar informações valiosas sem intervenção humana.

Se você não tiver certeza de qual aplicativo é mais adequado para o seu negócio, recomendamos começar com um teste piloto na área que atualmente consome mais tempo.

Como você realmente avalia um modelo de LLM?

Se você já se perguntou como os pesquisadores determinam se um LLM é bom ou ruim, aqui está a resposta. Avaliar esses modelos não é tão simples quanto parece, e conhecer esses métodos ajudará você a entender melhor o que realmente significam as pontuações que você vê nas comparações.

A métrica da perplexidade: quão “confuso” é o modelo?

A perplexidade é uma das maneiras mais básicas de medir o quão bem um LLM funciona. Pense nisso como um medidor de “confusão” do modelo: quanto menor a pontuação, menos confuso o modelo fica ao prever a próxima palavra.

Nós explicamos para você com um exemplo simples. Se você der a um modelo a frase “O gato está dormindo no…” e você pode facilmente prever que a próxima palavra é “sofá”, você terá baixa perplexidade. Se você não tem ideia do que vem a seguir, a perplexidade será alta.

O processo funciona calculando a probabilidade inversa do texto de teste, normalizada por palavra. Quando um modelo está muito confiante em suas previsões, você obtém números baixos que indicam melhor desempenho.

Lembre-se de que a perplexidade, embora útil, não diz tudo sobre a qualidade do modelo. Um modelo pode ser ótimo para prever palavras, mas péssimo para criar textos coerentes ou criativos.

Benchmarks: Os “testes de condução” de LLMs

Para poder comparar os modelos de forma justa, a comunidade científica desenvolveu uma série de testes padronizados. Eles são como testes de direção, mas para inteligência artificial:

MMLU (Massive Multitask Language Understanding): Este é o teste mais abrangente, com cerca de 16.000 questões de múltipla escolha cobrindo 57 assuntos diferentes, de matemática a história. É como se você tivesse o modelo examinado ao longo da carreira universitária.

ARC (AI2 Reasoning Challenge): Contém mais de 7.700 questões científicas de nível escolar, divididas em fáceis e difíceis. Perfeito para medir se o modelo pode raciocinar como um aluno.

TruthfulQA: Este teste é especial porque mede se o modelo está dizendo a verdade ou inventando respostas quando não sabe algo. Muito útil para detectar aquelas “alucinações” de que falaremos mais tarde.

Existem também testes especializados, como HumanEval para programação, GSM8K para matemática e Chatbot Arena , onde usuários reais votam em quais respostas preferem.

Uma tendência interessante são as avaliações “LLM-as-a-judge”, onde um modelo avançado como o GPT-4 atua como um juiz para avaliar outros modelos. O MT-Bench usa essa metodologia para testar conversas de vários turnos.

Os problemas com as avaliações atuais

Embora esses testes sejam úteis, eles têm limitações importantes das quais você deve estar ciente. Um estudo recente da Apple mostrou que o desempenho dos LLMs “se deteriora quando a complexidade das perguntas aumenta”. Os pesquisadores observaram que pequenas mudanças nas perguntas podem alterar completamente os resultados, indicando que esses modelos são “muito flexíveis, mas também muito frágeis”.

Outro problema sério é a “contaminação de dados”. Como os modelos são treinados com textos da internet, existe o risco de terem “memorizado” as respostas dos testes, invalidando os resultados. É como se um aluno tivesse visto o exame antes de fazê-lo.

Além disso, os benchmarks são rapidamente “saturados”. Quando os modelos mais avançados pontuam 99%, eles não são mais úteis para medir o progresso. É por isso que eles desenvolveram testes mais difíceis, como o MMLU-Pro, que inclui perguntas mais complicadas e mais opções de resposta.

A maior limitação é que essas avaliações não medem aspectos cruciais, como empatia, criatividade ou compreensão pragmática da linguagem, que são essenciais para aplicações no mundo real.

Se você estiver avaliando LLMs para sua empresa ou projeto, recomendamos que você não confie apenas nessas pontuações. Testes práticos com casos de uso do mundo real costumam ser mais reveladores do que benchmarks acadêmicos.

Riscos e limitações dos LLMs atuais

Você já viu os recursos impressionantes dos LLMs, mas também precisa conhecer suas limitações importantes. Esses modelos, embora poderosos, apresentam desafios significativos que você deve considerar antes de implantá-los em aplicativos confidenciais.

Alucinações e geração de informações falsas

Você sabe o que são alucinações em modelos de linguagem? É um fenômeno em que esses sistemas geram respostas que parecem convincentes, mas contêm informações completamente falsas ou inventadas. Isso acontece porque os LLMs operam por meio de previsão probabilística de palavras, priorizando que o texto soe coerente sobre a veracidade dos fatos.

Um exemplo que ajudará você a entender a gravidade do problema: um advogado usou o ChatGPT para redigir um resumo jurídico com referências geradas por IA, apenas para descobrir mais tarde que os casos legais citados não existiam, resultando em penalidades do juiz.

Os dados são reveladores. Mesmo os modelos mais avançados alucinam entre 2,5% e 8,5% do tempo em tarefas gerais, número que pode ultrapassar 15% em alguns modelos. Em domínios especializados, como o direito, a taxa de alucinações pode atingir entre 69% e 88% das respostas.

Vieses nos dados de treinamento

Os LLMs herdam e amplificam os vieses presentes em seus dados de treinamento. Você pode pensar nisso como um aluno aprendendo com livros que contêm preconceitos históricos – eles inevitavelmente incorporarão essas perspectivas tendenciosas.

Aqui está um exemplo concreto: quando você pede ao ChatGPT possíveis nomes executivos, 60% dos nomes gerados são masculinos, enquanto ao solicitar nomes de professores, a maioria é feminina. Isso revela como os modelos perpetuam os estereótipos de gênero presentes em seus dados de treinamento.

Além disso, um estudo recente descobriu que as respostas dos principais modelos de LLM tendem a se alinhar com perfis demográficos específicos: principalmente homens, adultos, altamente educados e com interesse em política.

Questões de privacidade e segurança

Ao interagir com LLMs, você deve considerar os riscos relacionados à privacidade e segurança de suas informações. Ao inserir dados nesses sistemas, existe o perigo de que essas informações possam ser armazenadas, usadas para treinamentos futuros ou, na pior das hipóteses, expostas a terceiros devido a vulnerabilidades de segurança.

As ameaças mais críticas identificadas pelo OWASP incluem:

- Injeção imediata

- Manuseio inseguro das partidas

- Envenenamento de dados de treinamento

- Modelo de negação de serviço

Essas vulnerabilidades podem permitir que invasores manipulem o comportamento do LLM para extrair informações confidenciais ou executar código malicioso.

Um caso real que ilustra esses riscos: os funcionários da Samsung compartilharam informações confidenciais com o ChatGPT enquanto o usavam para tarefas de trabalho, expondo códigos e gravações de reuniões que poderiam ser tornadas públicas.

Lembre-se de que conhecer esses riscos não significa que você deva evitar LLMs, mas que deve usá-los de maneira informada e responsável.

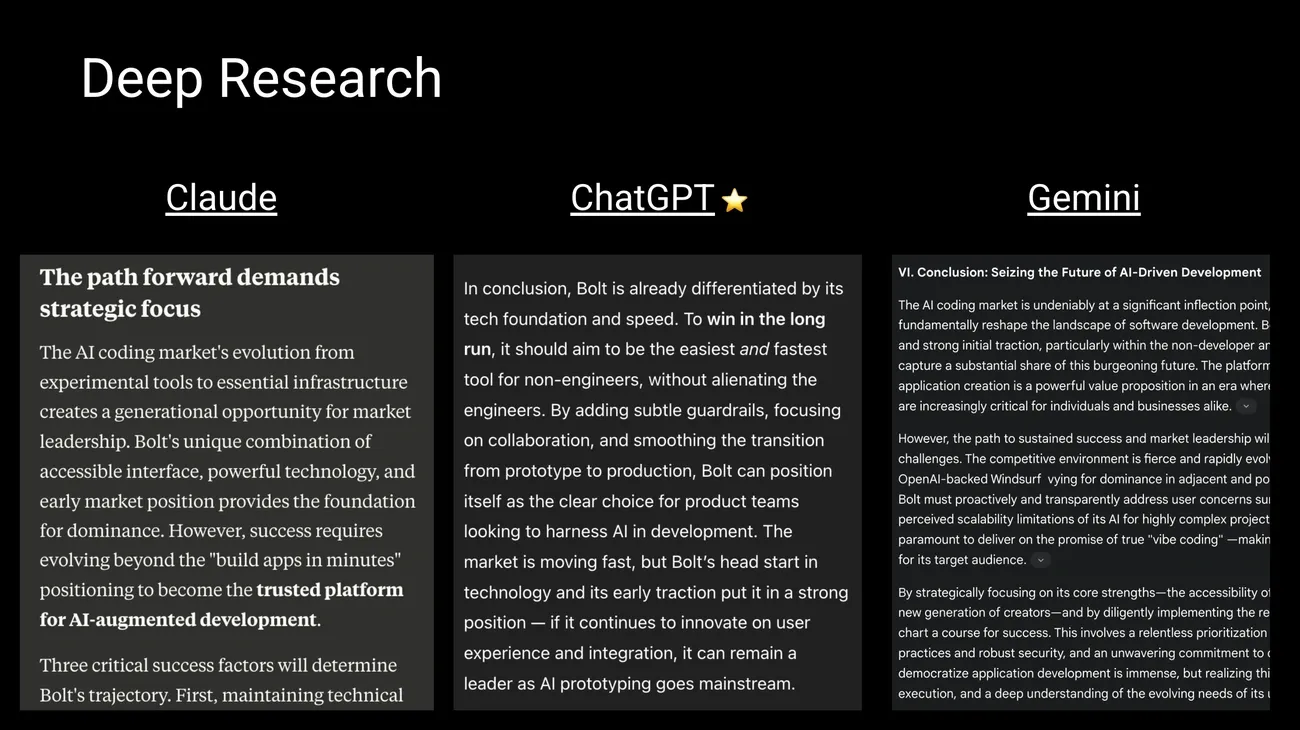

Modelos de LLM mais importantes em 2025: qual escolher?

Fonte da imagem: Por trás da nave por Peter Yang

Quer saber qual é o melhor modelo de LLM para seus projetos? O cenário está em constante evolução, com novos modelos melhorando as capacidades de seus antecessores. Abaixo, mostramos as opções mais destacadas para que você possa escolher a mais adequada de acordo com suas necessidades.

GPT-4, Claude 3 e Gemini 1.5: os líderes de mercado

Os modelos de negócios atualmente dominam o mercado graças às suas capacidades avançadas. O GPT-4o da OpenAI se destaca por sua capacidade multimodal em tempo real, processando texto, imagens e áudio com latência mínima de aproximadamente 300 ms. Se você precisa de um modelo para tarefas que exigem respostas rápidas e processamento de mídia, esta é uma ótima opção.

O Claude 3 Opus da Anthropic se destaca em tarefas complexas de raciocínio e resolução de problemas, superando o GPT-4 em benchmarks como raciocínio especializado em nível de pós-graduação (GPQA) e matemática básica (GSM8K). Recomendamos Claude se você trabalha com análise profunda ou precisa resolver problemas que exigem lógica avançada.

O Gemini 1.5 Pro do Google oferece recursos impressionantes de análise multimodal e pode processar até 1 milhão de tokens, permitindo que você analise documentos longos ou até horas de vídeo. É ideal se você precisar processar grandes volumes de informações de uma só vez.

Alternativas de código aberto: LLaMA 3, Mistral e DeepSeek

Prefere controle total sobre seus dados? Os modelos de código aberto estão avançando rapidamente. O LLaMA da Meta permite que você instale localmente versões com diferentes tamanhos de parâmetros, mantendo todas as suas informações em seu próprio servidor.

O Mistral se destaca por sua eficiência e oferece versões otimizadas para rodar em CPU e GPU. Se você tem recursos limitados, mas precisa de um bom desempenho, o Mistral pode ser sua melhor opção.

O DeepSeek ganhou popularidade por seu desempenho excepcional em raciocínio e codificação, competindo diretamente com modelos comerciais. A principal vantagem dessas alternativas gratuitas é que todas as informações permanecem no seu dispositivo, garantindo total privacidade dos seus dados.

Como comparar parâmetros e capacidade do token?

Os recursos variam significativamente dependendo da arquitetura de cada modelo. O GPT-4o oferece um contexto de 128.000 tokens, enquanto o Gemini 1.5 Pro aumenta esse limite para 1 milhão (com planos de expandi-lo para 2 milhões). O Claude 3 Opus lida com até 200.000 tokens, permitindo que você analise documentos muito grandes.

Lembre-se de que o tamanho também é importante: embora os números exatos sejam confidenciais, estima-se que o GPT-4 contenha aproximadamente 1,8 trilhão de parâmetros, enquanto o Gemini 1,5 Pro tem cerca de 1,5 trilhão e o Claude Opus aproximadamente 200.000 milhões de parâmetros.

A escolha do modelo certo dependerá de suas necessidades específicas: orçamento, volume de dados a serem processados, nível de privacidade necessário e tipo de tarefas que você executará.

Para onde estão indo os LLMs? As tendências que moldarão o futuro

Você já se perguntou como serão os LLMs nos próximos anos? A evolução desses modelos está avançando em ritmo acelerado, e conhecer as tendências o ajudará a se preparar para as mudanças que estão por vir.

Modelos que entendem tudo: multimodalidade e contextos extensos

A tendência mais importante que você verá é a integração multimodal. Novos modelos como Gemini 1.5 e GPT-4o processam simultaneamente texto, imagens, áudio e vídeo, permitindo interações mais naturais e completas com o usuário. Isso significa que você poderá fazer upload de uma foto, fazer uma pergunta de voz e receber uma resposta por escrito, tudo na mesma conversa.

Além disso, a capacidade de lidar com grandes contextos deu um salto extraordinário. Enquanto os modelos anteriormente “esqueciam” as informações após algumas páginas, agora eles podem processar até 1 milhão de tokens no Gemini, com planos de chegar a 2 milhões em breve. Isso permite que você analise documentos inteiros, livros inteiros ou até mesmo horas de vídeo sem perder o fio da conversa.

Modelos mais eficientes: menos recursos, melhor desempenho

Uma tendência que irá beneficiá-lo diretamente é a quantização. Essa técnica reduz a precisão numérica dos pesos do modelo, passando de representações de 32 bits para formatos mais compactos, como INT8 ou INT4. O que isso significa para você? Modelos até 8 vezes menores, menor consumo de energia e velocidade de resposta mais rápida.

Modelos como o DeepSeek-V3 provam que você pode obter um desempenho excepcional a custos significativamente mais baixos. Se você planeja usar o LLM em sua empresa, essa tendência permitirá que você acesse recursos avançados sem a necessidade de grandes investimentos em hardware.

Regulamento: as novas regras do jogo

Recorda que a União Europeia promulgou a primeira lei abrangente sobre IA, com aplicação gradual até 2026. Este quadro classifica os sistemas de acordo com o seu nível de risco e impõe obrigações proporcionadas, proibindo práticas consideradas inaceitáveis. China, Canadá e outros países também estão desenvolvendo seus próprios esquemas regulatórios.

Que impacto isso terá no seu uso diário? Maior transparência no funcionamento dos modelos, melhor proteção de seus dados pessoais e padrões mais elevados de qualidade e segurança.

O equilíbrio entre inovação e controle responsável determinará a rapidez com que você pode acessar esses novos recursos e em que condições.

Conclusão

O que aprendemos sobre LLMs ao longo dessa jornada? Principalmente, que esses modelos representam uma tecnologia extraordinária que já está mudando a maneira como trabalhamos e nos comunicamos.

Lembre-se de que os LLMs funcionam processando grandes quantidades de texto para aprender padrões na linguagem humana. Sua arquitetura baseada em transformador permite que eles entendam o contexto e gerem respostas consistentes, embora nem sempre precisas.

Quanto às aplicações práticas, você pode usá-las para gerar conteúdo, resumir documentos, traduzir textos ou criar assistentes virtuais para o seu negócio. A produtividade que oferecem é considerável: podem economizar entre 30% e 90% do tempo em tarefas rotineiras.

No entanto, esteja ciente de suas limitações importantes. As alucinações ocorrem de 2,5% a 15% das vezes, os vieses estão presentes em suas respostas e você deve ser cauteloso com as informações confidenciais que compartilha.

Se você for usar esses modelos regularmente, recomendamos que:

• Avalie suas necessidades específicas antes de escolher entre opções comerciais, como GPT-4o, Claude 3 ou Gemini 1.5 • Considere alternativas de código aberto, como LLaMA ou Mistral, se precisar de mais controle sobre seus dados • Sempre verifique as informações importantes geradas por esses sistemas

O futuro aponta para modelos multimodais mais eficientes e com contextos mais longos. A regulamentação também está chegando, especialmente na Europa.

Como usuário dessas tecnologias, sua compreensão desses conceitos permitirá que você aproveite melhor seu potencial, evitando seus principais riscos. A chave é usá-los como ferramentas poderosas, mas sempre com supervisão e julgamento humanos.

Principais takeaways

Os LLMs representam uma revolução tecnológica que está transformando a maneira como interagimos com as máquinas e processamos informações. Aqui estão os pontos essenciais que você deve saber:

• LLMs são modelos de IA especializados em linguagem que usam arquiteturas Transformer para processar trilhões de parâmetros e gerar texto semelhante ao humano.

• Seu treinamento requer recursos massivos: o GPT-3 consumiu 1.287 MWh de eletricidade e produziu mais de 500 toneladas de CO2, o equivalente a 600 voos transatlânticos.

• As aplicações práticas incluem geração de conteúdo, tradução multilíngue, conversão de código e assistentes virtuais que economizam de 30 a 90% do tempo em tarefas rotineiras.

• Os principais riscos são alucinações (2,5-15% de respostas falsas), preconceitos herdados de dados de treinamento e vulnerabilidades de privacidade e segurança.

• O futuro aponta para modelos multimodais mais eficientes, contextos de até 2 milhões de tokens e regulamentação responsável, como a nova lei europeia de IA.

Compreender esses recursos e limitações permitirá que você aproveite o potencial dos LLMs enquanto navega com responsabilidade neste cenário tecnológico em constante evolução.

Lembre-se de que você pode usar todo o poder dos modelos llm em seus agentes de IA com o n8n e usar seus modelos de processamento em seus fluxos de trabalho.

Perguntas frequentes

1º trimestre. O que exatamente é um LLM e como ele funciona? Um LLM (Large Language Model) é um modelo de inteligência artificial projetado para entender e gerar linguagem humana. Ele funciona analisando enormes conjuntos de dados textuais e usando redes neurais profundas para aprender padrões linguísticos e gerar texto coerente.

2º trimestre. Quais são as aplicações práticas mais comuns dos LLMs em 2025? As aplicações mais comuns incluem geração automática de conteúdo, tradução multilíngue, conversão de código entre linguagens de programação e assistentes virtuais avançados para atendimento ao cliente e produtividade dos negócios.

3º trimestre. Quais são os principais riscos associados ao uso do LLM? Os riscos mais significativos são as alucinações (geração de informações falsas), a perpetuação de vieses presentes nos dados de treinamento e as questões de privacidade e segurança relacionadas ao tratamento de dados sensíveis.

4º trimestre. Como o desempenho de um LLM é avaliado? O desempenho é avaliado usando métricas como perplexidade, que mede a capacidade preditiva do modelo, e benchmarks padronizados que avaliam diferentes recursos, como compreensão, raciocínio e geração de texto. Avaliações contraditórias também são usadas para testar a robustez do modelo.

Pergunta 5. Quais são as tendências futuras no desenvolvimento de LLM? As tendências incluem o desenvolvimento de modelos multimodais que integram texto, imagem e áudio, a capacidade de lidar com contextos mais longos (até milhões de tokens), técnicas de downsizing para melhorar a eficiência e um foco na governança e regulamentação responsáveis dessas tecnologias.