Os modelos LLM 2025 oferecem uma variedade de opções para equilibrar velocidade, custo e recursos com base em necessidades específicas. Neste artigo vamos comparar os principais modelos, suas pontas fortes e fracas e como você pode aproveitá-los ao máximo:

• O GPT-4o lidera em velocidade multimodal com 110 tokens/segundo e recursos de áudio em tempo real, ideal para conversas interativas e processamento de multimídia.

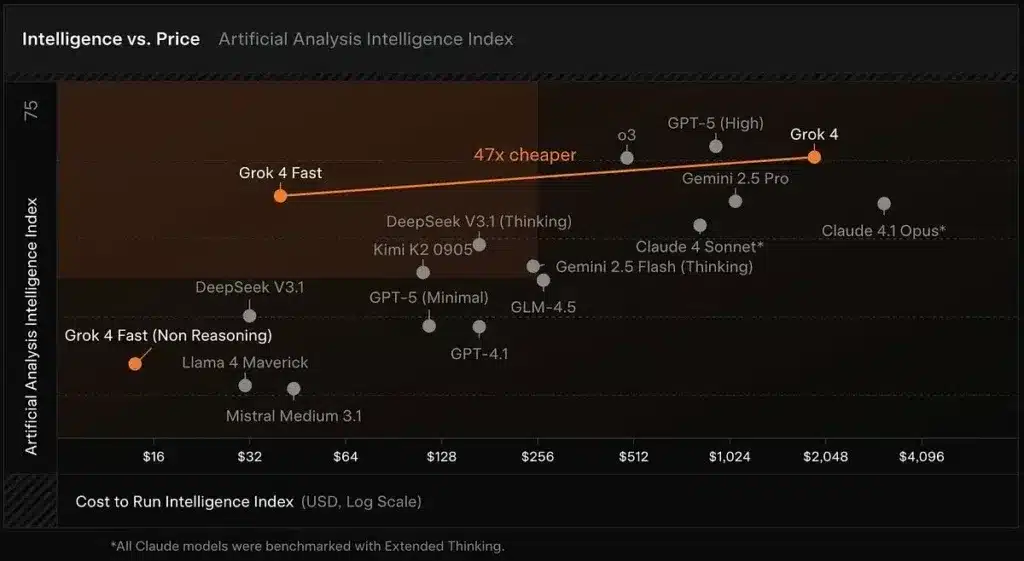

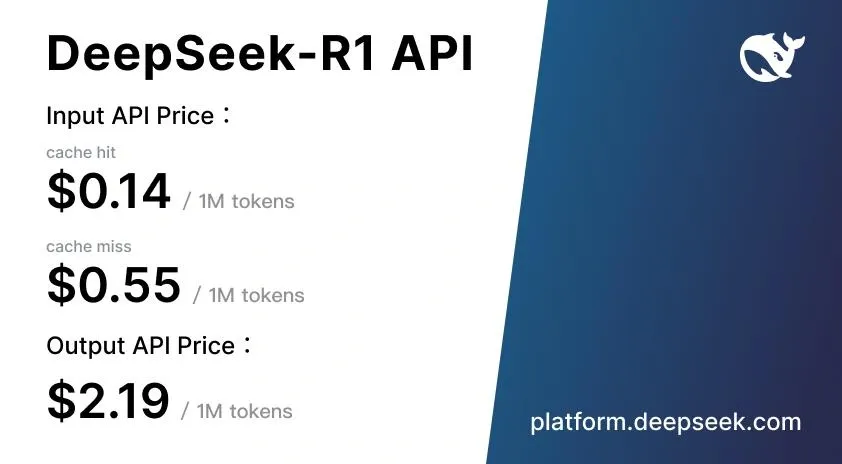

• O DeepSeek R1 é a opção mais econômica com custos 90-95% menores que os concorrentes, perfeito para tarefas de raciocínio matemático e desenvolvimento de software.

• O Gemini 2.5 Pro se destaca por sua enorme janela de contexto de 1 milhão + tokens, permitindo que até 1.500 páginas sejam processadas simultaneamente para uma extensa análise de documentos.

– Claude 4 Opus define o padrão em codificação profissional com 72,5% SWE-bench e capacidade de trabalho contínua por 7 horas sem degradação.

• A escolha do modelo deve ser baseada em casos de uso específicos: velocidade em tempo real (GPT-4o), economia para alto volume (DeepSeek R1) ou desempenho máximo para desenvolvimento complexo (Claude 4 Opus).

A competição entre esses modelos impulsiona melhorias constantes em 2025, oferecendo versões gratuitas para experimentar antes de implantações corporativas em larga escala.

GPT-4o

Fonte da imagem: Cody AI

O que torna o GPT-4o especial entre todos os modelos disponíveis? Este modelo OpenAI, onde o “o” significa “omni”, representa um grande salto qualitativo na inteligência artificial. Ao contrário das versões anteriores que processavam apenas texto, o GPT-4o pode trabalhar com texto, áudio, imagens e vídeo simultaneamente e em tempo real. Essa capacidade multimodal o torna uma ferramenta verdadeiramente versátil para praticamente qualquer aplicação que você possa imaginar.

Qual velocidade o GPT-4o oferece?

A velocidade do GPT-4o é realmente impressionante. Ao falar com eles por áudio, você receberá respostas em apenas 232 milissegundos, com uma média de 320 milissegundos – aproximadamente o mesmo que o tempo de resposta humano em uma conversa natural.

Para entender a melhoria que isso representa, observe estes dados comparativos:

- GPT-3.5 levou 2.8 segundos para responder

- GPT-4 precisou de 5,4 segundos para gerar respostas

Em termos de processamento de texto, o GPT-4o atinge 110 tokens por segundo, uma velocidade cerca de três vezes mais rápida que o GPT-4 Turbo. Essa velocidade também supera outros modelos concorrentes, como o Claude 3 Opus e o Gemini 1.5 Pro.

Como ele atinge essa velocidade? A chave está em sua arquitetura integrada. Enquanto os modelos anteriores exigiam até três sistemas separados para processar áudio (transcrição, geração e síntese), o GPT-4o unifica tudo em uma única rede neural.

Quanto custa usar o GPT-4o?

A OpenAI conseguiu tornar o GPT-4o muito mais barato, com uma redução de custo de 50% em comparação com o GPT-4 Turbo. Aqui está a estrutura de preços atual:

| Tipo de token | Preço |

| Tokens de entrada | US$0,01 por 1.000 tokens |

| Tokens de saída | US$0,03 por 1.000 tokens |

Para lhe dar uma ideia prática: processar um texto de 500 palavras custaria aproximadamente € 7,64 (incluindo 625 tokens de entrada e 725 tokens de saída).

Se você está procurando uma opção ainda mais barata, pode usar o GPT-4o mini. Esta versão custa US$ 0,15 por milhão de tokens de entrada e US$ 0,60 por milhão de tokens de saída, tornando-a aproximadamente 7,2 vezes mais barata que o GPT-4.

Quanta informação o GPT-4o pode processar?

O GPT-4o lida com uma janela de contexto de 128.000 tokens, uma melhoria considerável em relação aos 8.192 tokens do GPT-4 original. O que isso significa para você na prática?

Com essa capacidade expandida, o GPT-4o pode:

- Analise documentos longos inteiros

- Tenha longas conversas lembrando todo o contexto anterior

- Processar e responder com base em grandes volumes de informação

- Gere até 16.384 tokens em uma única resposta

Lembre-se de que, embora essa janela de contexto seja ampla, modelos como o Claude 3.5 Sonnet oferecem 200.000 tokens e o Gemini 1.5 Pro chega a 2 milhões.

Quando recomendamos o uso do GPT-4o?

O GPT-4o se destaca especialmente quando você precisa de processamento multimodal e respostas rápidas. Recomendamos que você o considere para:

Conversas em tempo real: Sua baixa latência o torna a escolha ideal para chatbots e assistentes virtuais que exigem interações fluidas e naturais.

Processamento de linguagem diversa: mostra melhorias significativas ao trabalhar com idiomas diferentes do inglês. Por exemplo, ele usa 4,4 vezes menos tokens para Gujarati, 3,5 vezes menos para Telugu e 3,3 vezes menos para Tamil.

Análise de imagem: Sua capacidade aprimorada de entender o conteúdo visual o torna perfeito para descrever documentos, diagramas ou capturas de tela.

Trabalhando com áudio: ele pode processar a entrada de áudio diretamente, captando não apenas o conteúdo verbal, mas também o tom, identificando vários alto-falantes e filtrando o ruído de fundo.

Criação de mídia: Gere texto e imagens de forma integrada e contextual.

No entanto, lembre-se de que, embora o GPT-4o seja mais rápido que o GPT-4 Turbo, ele não mostra um aumento significativo nas habilidades gerais de raciocínio. Se você precisar de raciocínio complexo, outros modelos podem ser mais adequados para o seu projeto.

Claude Soneto 4

Fonte da imagem: CometAPI

Procurando um modelo LLM que combine desempenho excepcional com custos razoáveis? Claude Sonnet 4, lançado pela Anthropic em maio de 2025, representa exatamente a solução equilibrada que você precisa. Este modelo foi projetado especificamente para oferecer recursos avançados de codificação e raciocínio sem comprometer seu orçamento, posicionando-se como a alternativa mais prática dentro da família Claude 4.

Ao contrário de seu irmão mais velho Claude Opus 4, o Sonnet 4 prioriza a eficiência sem sacrificar a qualidade, tornando-o a escolha ideal para desenvolvedores e empresas que buscam o máximo valor para seu investimento.

Claude Soneto Velocidade 4

Quer saber com que rapidez ele pode processar suas perguntas? O Claude Sonnet 4 é otimizado para aplicações de alto volume, com limites oficiais que excedem significativamente as versões anteriores:

- 50 solicitações por minuto (RPM)

- 30.000 tokens de entrada por minuto (ITPM)

- 8.000 tokens de saída por minuto (OTPM)

Como o anúncio oficial da Anthropic confirma: “Aumentamos os limites de velocidade da API para Claude Sonnet 4”. Esse aprimoramento permite que você processe mais dados sem atingir limites com frequência, dimensione seus aplicativos para atender a mais usuários simultaneamente e execute várias chamadas de API em paralelo.

Lembre-se de que o Sonnet 4 implementa um sistema inovador de “ITPM com reconhecimento de cache”. Somente tokens de entrada não armazenados em cache contam para os limites de taxa. Por exemplo, com um limite de ITPM de 2.000.000 e uma taxa de acertos de cache de 80%, você pode processar efetivamente 10.000.000 de tokens de entrada totais por minuto.

Custo do Soneto 4 de Claude

A estrutura de preços do Claude Sonnet 4 foi projetada para ser acessível e previsível:

| Tipo de token | padrão | Preço com cache (5 min) | Preço com cache (1 hora) | Acertos de cache |

| Tokens de entrada | EUR 2,86/mês | EUR 3,58/mês | EUR 5.73/mês | 0,29 EUR/mês |

| Tokens de saída | EUR 14.31/mês | – | – | – |

Recomendamos usar o cache imediato para otimizar os custos, especialmente se o aplicativo executar consultas repetitivas. Para contextos longos (mais de 200 mil tokens) quando você usa a janela de contexto de 1 milhão, uma taxa premium se aplica: EUR 5,73 por milhão de tokens de entrada e EUR 21,47 por milhão de tokens de saída.

Se você lida com alto volume de processamento, a API do Lote oferece um desconto de 50%, reduzindo o custo para EUR 1,43/MTok para entrada e EUR 7,16/MTok para saída.

Janela de contexto do Claude Sonnet 4

Você precisa processar documentos longos ou ter longas conversas? O Claude Sonnet 4 oferece uma janela de contexto padrão de 200 mil tokens (aproximadamente 150.000 palavras ou cerca de 500 páginas de texto), permitindo que você analise bases de código complexas em uma única interação.

Para organizações no nível de uso 4 e aquelas com limites personalizados, o Claude Sonnet 4 fornece uma janela expandida de até 1 milhão de tokens no modo beta. Esse recurso está disponível por meio da API Anthropic, do Amazon Bedrock e do Google Vertex AI, permitindo:

- Análise de código em grande escala (até 75.000 linhas de código)

- Processamento de documentos extremamente extenso

- Construindo agentes de IA com recursos de raciocínio longo

Para acessar esse recurso, inclua o cabeçalho beta “context-1m-2025-08-07” em suas solicitações de API.

Melhor uso do Soneto 4 de Claude

Claude Sonnet 4 se destaca especialmente nestes cenários:

Codificação e desenvolvimento: Com pontuações excepcionais em benchmarks como SWE-bench (72,7%, superando ligeiramente o Opus 4 com 72,5%), é perfeito para tarefas de programação, desde a geração de código até a refatoração completa.

Agentes de atendimento ao cliente: Sua eficiência e velocidade o tornam a escolha ideal para chatbots de alto volume e assistentes virtuais que exigem respostas rápidas, mas sofisticadas.

Processamento de documentos: Perfeito para resumir, analisar ou extrair informações de documentos grandes, graças à sua ampla janela de contexto.

Aplicativos corporativos econômicos: equilibrando desempenho e custo, é a escolha preferida para implementações que exigem processamento intensivo, mantendo as restrições orçamentárias.

Uma vantagem adicional é sua disponibilidade gratuita através da interface web do Claude, ao contrário do Opus 4, que requer uma assinatura paga. Isso o torna um recurso valioso se você quiser experimentar modelos LLM de alto desempenho sem custo inicial.

Grok 3

Fonte da imagem: CometAPI

Procurando um modelo LLM com recursos avançados de raciocínio? Grok 3, lançado pela xAI em fevereiro de 2025, pode ser a solução que você precisa. Desenvolvido sob a direção de Elon Musk, este modelo foi treinado usando um data center impressionante com

Qual velocidade o Grok 3 oferece?

Aqui estão os resultados mais notáveis do Grok 3 em termos de velocidade de processamento:

- Ele resolveu um quebra-cabeça de raciocínio lógico complexo em apenas 67 segundos, enquanto concorrentes como o DeepSeek R1 levaram 343 segundos

- Seu modo “Think” processou consultas complexas, gerando código de animação 3D em 114 segundos

Além disso, o xAI oferece uma variante otimizada chamada Grok 3 Mini, que prioriza a velocidade em vez de um certo grau de precisão. Essa flexibilidade permite que você escolha entre potência máxima ou respostas mais ágeis com base em suas necessidades específicas.

Estrutura de Custos Grok 3

Abaixo, você encontrará a estrutura de preços que permitirá avaliar qual versão melhor se adapta ao seu orçamento:

| Modelo | Custo do token de entrada | Custo do token de saída |

| Grok 3 | 2,86 euros por milhão | 14,31 euros por milhão |

| Grok 3 Mini | 0,29 euros por milhão | 0,48 euros por milhão |

Como você pode ver, o Grok 3 Mini é aproximadamente 10 vezes mais barato para tokens de entrada e 30 vezes mais barato para tokens de saída. Recomendamos esta variante se você estiver procurando por uma alternativa econômica para aplicações de alto volume.

O acesso primário é obtido por meio da assinatura X Premium+, que custa € 38,17 por mês nos EUA, após um aumento recente de € 20,99. Você também pode considerar o plano “SuperGrok” anunciado por EUR 28.63 por mês que oferecerá funcionalidades mais avançadas.

Capacidade de contexto disponível

Tanto o Grok 3 quanto o Grok 3 Mini fornecem uma janela de contexto de 131.072 tokens. Esse recurso permite que você processe documentos longos e tenha longas conversas sem perder informações contextuais relevantes.

Lembre-se de que, embora teoricamente possa lidar com até um milhão de tokens, estudos de usuários sugerem que o desempenho ideal é mantido até aproximadamente 80.000 tokens. Além desse limite, você pode experimentar uma degradação gradual da coerência.

Quando usar o Grok 3?

Recomendamos o Grok 3 especialmente para estes cenários:

Raciocínio matemático e científico: Obtenha excelentes resultados em testes como AIME (matemática) e GPQA (física, química e biologia), superando concorrentes de alto nível.

Desenvolvimento de código: Gera código mais estruturado e funcional do que outros modelos, especialmente em aplicações web e interfaces de usuário. Sua capacidade de produzir soluções HTML5 otimizadas o torna ideal se você for um programador.

Pesquise com o DeepSearch: Seu mecanismo de pesquisa integrado verifica a Internet e a rede social X, fornecendo respostas documentadas mais rapidamente do que alternativas como Gemini e OpenAI.

Escrita criativa: Demonstre habilidades superiores de contar histórias com melhor construção de personagens e progressão do enredo.

Geração de conteúdo com menos restrições: Ofereça uma abordagem menos censurada, abordando tópicos sensíveis mais diretamente quando explicitamente solicitado.

Se você precisa de um modelo LLM com fortes recursos de raciocínio e está procurando um equilíbrio eficaz entre velocidade, custo e amplitude de contexto, o Grok 3 representa uma opção poderosa que você deve considerar em 2025.

Busca Profunda R1

Fonte da imagem: DeepSeek

Procurando um modelo de LLM que combine poder de raciocínio com preços acessíveis? O DeepSeek R1, desenvolvido na China e lançado em janeiro de 2025, pode ser exatamente o que você precisa. Este modelo de raciocínio é baseado no DeepSeek V3, mas incorpora melhorias significativas por meio do aprendizado por reforço (RL), tornando-o uma ferramenta excepcionalmente poderosa para resolver problemas matemáticos e lógicos, bem como para análises científicas.

Velocidade do DeepSeek R1

Ao avaliar o DeepSeek R1, você notará que sua abordagem prioriza a precisão em vez da velocidade:

- Processa aproximadamente 28 tokens por segundo

- É cerca de 6 vezes mais lento que o o1-mini e duas vezes mais lento que o ChatGPT 4o

- Gaste mais tempo em raciocínio profundo antes de gerar respostas

Essa velocidade mais lenta tem um motivo: o DeepSeek R1 se autocorrige durante sua cadeia de pensamento, detectando seus próprios erros antes de oferecer a resposta final. Se você precisar de respostas extremamente precisas para tarefas complexas, essa abordagem deliberativa será benéfica para você, especialmente quando a precisão é mais importante do que a velocidade imediata.

Custo do DeepSeek R1

Aqui você encontrará uma das vantagens mais marcantes do DeepSeek R1: sua estrutura de preços altamente competitiva.

| Tipo de token | Preço padrão |

| Tokens de entrada (acerto de cache) | <citation index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0,13 |

| Tokens de entrada (perda de cache) | <citation index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0,13 |

| Tokens de saída | <citation index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0,13 |

Esses preços são 90-95% mais baixos do que o OpenAI o1, que custa € 14,31 por milhão de tokens de entrada e € 57,25 por milhão de tokens de saída. Além disso, o DeepSeek implementa um sistema de cache inteligente que oferece até 90% de economia para consultas repetidas.

Recomendamos experimentar o DeepSeek R1 gratuitamente por meio da plataforma web DeepSeek Chat, onde você pode experimentar seus recursos sem nenhum custo inicial.

Janela de contexto do DeepSeek R1

O DeepSeek R1 lida com uma janela de contexto de 128 mil tokens, permitindo que você:

- Processe tarefas de raciocínio complexas e de várias etapas

- Mantenha a consistência em documentos longos

- Siga cadeias complexas de raciocínio sem perder informações

- Lide com discussões técnicas detalhadas, mantendo o contexto completo

Esse recurso coloca o DeepSeek R1 no mesmo nível do GPT-4o (128K), embora abaixo do Claude 3.5 Sonnet (200K) e do Gemini 1.5 Pro (2 milhões).

Melhor uso do DeepSeek R1

O DeepSeek R1 se destaca particularmente quando você precisa:

- Resolução de problemas matemáticos e técnicos: Ideal para pesquisa científica, engenharia e finanças

- Desenvolvimento e codificação de software: Competir efetivamente com Claude e OpenAI o1-mini em programação automatizada

- Tarefas de geração aumentada por recuperação (RAG): Executa tão bem quanto GPT-4o com raciocínio passo a passo explícito

- Personalização por meio de código aberto: Sua licença do MIT permite modificações para necessidades específicas

- Aplicativos para o mercado chinês: Especialmente otimizado para compreensão do idioma chinês

Lembre-se de que o DeepSeek R1 tem algumas limitações importantes. Seu desempenho multilíngue é ruim fora do inglês e chinês e não suporta análise de imagens, restringindo sua utilidade em aplicações multimodais.

De acordo com o modelo DeepSeek-R1-Zero, o raciocínio pode surgir do zero usando apenas RL, permitindo que recursos avançados sejam desenvolvidos sem depender de dados rotulados. Isso torna o DeepSeek R1 particularmente valioso para equipes de pesquisa que buscam explorar novas técnicas de treinamento de modelos.

Gêmeos 2.5 Pro

Fonte da imagem: CometAPI

Introduzido em março de 2025, o Gemini 2.5 Pro é o modelo de raciocínio mais avançado que o Google desenvolveu até agora. Se você está procurando uma ferramenta que possa resolver problemas complexos, esse modelo oferece recursos de raciocínio aprimorados e uma janela de contexto que mudará a maneira como você processa grandes volumes de informações.

Velocidade do Gemini 2.5 Pro

Quer saber o que torna a velocidade do Gemini 2.5 Pro especial? Ao contrário de outros modelos LLM, este sistema funciona de uma maneira única: gasta aproximadamente 20 segundos no raciocínio inicial e depois gera tokens em uma velocidade extraordinariamente alta. Pense nisso como um processo de “pensar antes de responder” que fornece um equilíbrio perfeito entre análise profunda e velocidade na geração de conteúdo.

O modelo excede significativamente a velocidade das versões anteriores sem comprometer a qualidade do resultado. Além disso, o Google projetou sua infraestrutura para evitar os limites de velocidade típicos que você experimenta com outros sistemas concorrentes, garantindo que você tenha uma experiência mais tranquila mesmo ao trabalhar com tarefas complexas.

Custo do Gemini 2.5 Pro

A estrutura de preços do Gemini 2.5 Pro varia de acordo com o volume de tokens que você usa e o tipo de processamento que você precisa:

| Tipo de processamento | Tokens de entrada | Tokens de saída |

| Padrão (≤200 mil tokens) | US$ 1,25 por milhão | US$ 10,00 por milhão |

| Padrão (>200 mil tokens) | US$ 2,50 por milhão | US$ 15,00 por milhão |

| Processamento em lote | US$ 0,625 por milhão | US$ 5,00 por milhão |

O Google também oferece um sistema de cache que pode reduzir significativamente seus custos para consultas repetitivas, com preços a partir de US$ 0,125 por milhão de tokens.

Para acessar o Gemini 2.5 Pro, você pode escolher entre a assinatura do Google AI Pro (€ 21,99/mês) ou Google AI Ultra (€ 274,99/mês) se precisar de limites de uso mais altos.

Janela de contexto do Gemini 2.5 Pro

Um dos recursos com os quais você ficará mais impressionado no Gemini 2.5 Pro é sua extraordinária janela de contexto de 1.048.576 tokens, com planos de expandi-la para 2 milhões em atualizações futuras. O que isso significa para você em termos práticos?

- Você pode processar até 1.500 páginas de texto simultaneamente

- Analise 30.000 linhas de código em uma única operação

- Tenha conversas extensas sem perder informações contextuais

Esse amplo recurso contextual facilita a análise de documentos inteiros, bases de código extensas e conjuntos de dados complexos em uma única sessão.

Melhor uso do Gemini 2.5 Pro

Recomendamos o Gemini 2.5 Pro especialmente para:

- Desenvolvimento Web Avançado: Lidera o ranking da WebDev Arena na criação de aplicativos web funcionais e esteticamente atraentes

- Raciocínio complexo: Ideal quando você precisa resolver problemas de matemática, ciências e multifacetados que exigem análise passo a passo

- Transformação e edição de código: Particularmente eficaz para automatizar tarefas de programação complexas

- Processamento multimodal: Capacidade de entender entradas de texto, código, imagem, áudio e vídeo

Se você é um desenvolvedor, pesquisador ou profissional que precisa processar grandes volumes de informações multimodais com raciocínio profundo e preciso, este modelo será especialmente valioso para você.

Claude 4 Opus

Fonte da imagem: CometAPI

Procurando o modelo LLM mais poderoso para programação avançada? O Claude Opus 4, lançado em maio de 2025, representa a proposta premium da Anthropic e se posiciona como “o melhor modelo de programação do mundo” de acordo com seu fabricante. Esta versão define um novo padrão em inteligência artificial conversacional, especialmente projetada para raciocínio profundo e tarefas complexas de codificação.

Claude Velocidade 4 Opus

Claude Opus 4 oferece um poder de processamento notável, com limites oficiais definidos em:

- 50 solicitações por minuto (RPM)

- 30.000 tokens de entrada por minuto (ITPM)

- 8.000 tokens de saída por minuto (OTPM)

O que realmente torna este modelo especial? Sua capacidade única de sustentar sessões de trabalho prolongadas. Enquanto outros concorrentes perdem consistência após uma ou duas horas, o Claude Opus 4 pode trabalhar continuamente por até sete horas sem degradação do desempenho. Esse recurso é essencial se você trabalha em projetos de programação complexos que exigem concentração sustentada.

Claude 4 Custo Opus

Recomendamos que você considere seu orçamento com cuidado, pois Claude Opus 4 representa um investimento premium:

| Tipo de token | padrão | Com processamento em lote |

| Entrada | EUR 14.31/mês | EUR 7.16/mês |

| Sair | EUR 71.57/mês | EUR 35.78/mês |

Esses preços colocam o Opus 4 no topo do mercado. No entanto, você pode otimizar os custos usando os mecanismos que a Anthropic oferece: cache imediato (reduzindo custos em até 90%) e processamento em lote (com 50% de desconto).

Janela de contexto de Claude 4 Opus

O Claude Opus 4 tem uma janela de contexto de 200.000 tokens, comparável ao seu antecessor, mas inferior aos 1.048.576 tokens do Gemini 2.5 Pro. Observe que essa limitação pode ser restritiva para bases de código extremamente grandes, mas é suficiente para a maioria das aplicações práticas.

O modelo incorpora um recurso exclusivo: “pensamento estendido”, um modo que permite alternar entre o raciocínio interno e o uso de ferramentas externas. Essa funcionalidade melhora significativamente sua capacidade de resolver problemas sofisticados.

Melhor uso de Claude 4 Opus

Quando você deve escolher Claude Opus 4? Destaca-se particularmente nestes casos:

- Tarefas complexas de codificação: SWE-bench lidera o benchmark com 72,5% e Terminal-bench com 43,2%, superando concorrentes como GPT-4.1 (54,6%) e Gemini 2.5 Pro (63,2%).

- Raciocínio científico avançado: Atinge 79,6% no GPQA Diamond (83,3% no modo de computação alta).

- Agentes autônomos de IA: Sua longa janela de atenção o torna ideal para tarefas que exigem milhares de etapas e horas de processamento contínuo.

- Refatoração de projetos: você pode analisar e modificar bases de código inteiras em uma única sessão.

Se você é um desenvolvedor profissional, pesquisador ou parte de equipes que criam agentes avançados de IA e precisam do mais alto nível de desempenho, Claude Opus 4 representa sua escolha ideal.

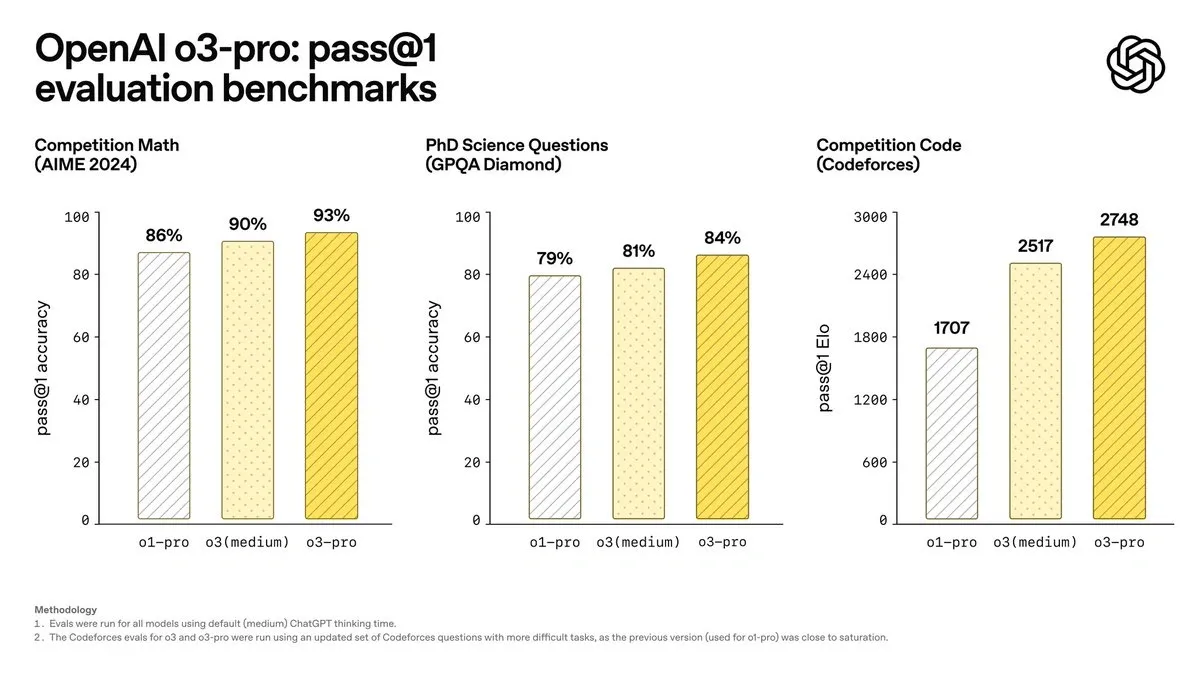

OpenAI o3

Fonte da imagem: Apidog

A OpenAI apresenta seu modelo o3 em abril de 2025, que marca um ponto de virada no raciocínio artificial. Ao contrário dos modelos que discutimos anteriormente, o o3 foi projetado especificamente para “pensar mais antes de responder”, integrando recursos avançados de raciocínio com acesso autônomo a ferramentas.

Qual velocidade o OpenAI o3 oferece?

Embora o o3 priorize a reflexão profunda, ele mantém uma eficiência que irá surpreendê-lo:

- Excede a taxa de transferência de o1, mantendo a mesma latência

- Sua arquitetura permite raciocínio prolongado sem comprometer a velocidade de resposta

- A versão o3-mini mostra tempos 24% mais rápidos (7,7 segundos em comparação com 10,16 segundos para o1-mini)

Comparado a outros modelos de raciocínio, o o3 consegue concluir tarefas complexas geralmente em menos de um minuto, atingindo um equilíbrio eficaz entre análise profunda e agilidade de resposta.

Estrutura de preços do OpenAI o3

Você ficará feliz em saber que a OpenAI reduziu significativamente os preços do o3:

| Cara | Preço original | Preço atual (redução de 80%) |

| Tokens de entrada | 9,54 €/milhão | € 1,91/milhão |

| Tokens de saída | 38,17 €/milhões | 7,63 €/milhões |

| Entrada | – | 0,48 €/milhão |

Essa redução posiciona o o3 competitivamente contra o Gemini 2.5 Pro (€ 0,95 / milhão de entrada, € 9,54 / milhão de produção) e Claude Sonnet 4 (€ 2,86 / milhão de entrada, € 14,31 / milhão de produção).

Capacidade de contexto OpenAI o3

O O3 oferece recursos contextuais extraordinários que você deve considerar:

- Lida com até 128.000 tokens em implantações padrão

- Alcance 200.000 tokens em ambientes específicos

- Gere até 100.000 tokens de saída

Essa amplitude contextual permite que você analise documentos longos, códigos complexos e tenha longas conversas sem perda de consistência.

Quando usar o OpenAI o3?

Recomendamos o o3 especialmente para estes casos de uso:

Programação de alto nível: Lidera o SWE-bench com 71,7%, superando significativamente o o1 (48,9%), tornando-o sua melhor escolha para desenvolvimento complexo.

Resolução matemática avançada: Com 96,7% em AIME em comparação com 83,3% em o1, é ideal se você precisar de precisão matemática excepcional.

Pesquisa científica: Atinge 87,7% no GPQA Diamante, demonstrando domínio em questões científicas de alta complexidade.

Análise visual integrada: Incorpora imagens em seu raciocínio, permitindo que você analise diagramas e gráficos de forma contextual.

Automação com ferramentas: combina pesquisa na web, análise de arquivos e execução de código Python de forma autônoma.

Além disso, o o3 se integra à Codex CLI, permitindo que os desenvolvedores que buscam otimizar seu fluxo de trabalho aproveitem seus recursos diretamente da linha de comando.

Tabela de comparação

Precisa de uma visão rápida para comparar todos esses modelos? Aqui está uma tabela de resumo para ajudá-lo a identificar qual deles atende melhor às suas necessidades específicas.

Lembre-se de que cada modelo tem seus pontos fortes particulares. Essa comparação permitirá que você avalie rapidamente as principais diferenças entre velocidade, custo e recursos:

| Modelo | Velocidade | Custo (por milhão de tokens) | Janela de | Casos de uso ideais |

| GPT-4o | 110 tokens/segundo | Buy-in: €0,01/1.000 tokens Saída: € 0,03/1.000 tokens |

128.000 tokens | • Conversas em tempo real• Processamento multilíngue • Análise visual • Transcrição de áudio |

| Claude Soneto 4 | 50 pedidos/min | Compra em: €2.86 Saída: € 14,31 |

200.000 tokens (expansível até 1 milhão) | • Codificação • Suporte ao cliente • Processamento de documentos • Aplicativos corporativos |

| Grok 3 | 67 segundos (provas lógicas) | Compra em: €2.86 Saída: € 14,31 |

131.072 tokens | • Raciocínio Matemático • Desenvolvimento de Código • Pesquisa • Escrita Criativa |

| Busca Profunda R1 | 28 tokens/segundo | Buy-in: 0,52 €Saída: € 2,09 |

128.000 tokens | • Resolução de problemas matemáticos • Desenvolvimento de software • RAG • Mercado chinês |

| Gêmeos 2.5 Pro | 20s Inicial + Alta Velocidade | Entrada: $ 1.25 Saída: US$ 10,00 |

1.048.576 tokens | • Desenvolvimento Web • Raciocínio Complexo • Transformação de Código • Processamento Multimodal |

| Claude 4 Opus | 50 pedidos/min | Entrada: € 14,31 Saída: € 71,57 |

200.000 tokens | • Codificação complexa • Raciocínio científico • Agentes autônomos de IA• Refatoração |

| OpenAI o3 | N/A | Entrada: € 1,91 Saída: € 7,63 |

128.000 tokens (expansível até 200K) | • Programação Avançada • Matemática • Ciências • Raciocínio Visual |

Se você está procurando a opção mais barata, o DeepSeek R1 oferece preços imbatíveis. Para velocidade máxima em aplicações multimodais, o GPT-4o é sua melhor alternativa. Você precisa processar documentos longos? O Gemini 2.5 Pro com sua enorme janela de contexto será perfeito para você.

Recomendamos que você avalie primeiro seus casos de uso específicos antes de decidir sobre um modelo. A maioria oferece versões gratuitas para que você possa experimentá-las sem nenhum custo inicial.

Conclusão

Qual modelo de LLM melhor atende às suas necessidades específicas? A resposta depende inteiramente de seus casos de uso específicos e do orçamento disponível.

Lembre-se de que cada modelo tem seus próprios pontos fortes. O GPT-4o se destaca quando você precisa de respostas multimodais rápidas, enquanto o Claude Sonnet 4 oferece um equilíbrio excepcional entre desempenho e custo. Se você trabalha com raciocínio matemático complexo, o Grok 3 pode ser sua melhor opção.

Procurando a alternativa mais barata? O DeepSeek R1 representa uma opção extraordinária, especialmente se você precisa resolver problemas técnicos complexos sem comprometer seu orçamento. Para processar documentos longos ou bases de código massivas, o Gemini 2.5 Pro permite que você lide com mais de um milhão de tokens em uma única sessão.

Se você for usar esses modelos para desenvolvimento profissional que requer desempenho máximo, o Claude 4 Opus define o mais alto padrão em codificação avançada. Por outro lado, o OpenAI o3 se destaca particularmente em programação e matemática com recursos visuais integrados.

O interessante sobre os modelos é que todos eles podem ser usados em nossos agentes de IA com n8n. Por meio de nossos modelos, você pode usar todo o poder dos diferentes modelos em seus fluxos de trabalho para atingir qualquer meta que definir para si mesmo.

Como escolher o seu modelo ideal?

Recomendamos que você considere estes aspectos principais:

Etapa 1: Defina seu caso de uso principal

- Você precisa processar grandes volumes de documentos? Gemini 2.5 Pro ou Claude Sonnet 4 são suas melhores alternativas.

- Você prioriza conversas interativas rápidas? GPT-4o oferecerá a melhor experiência.

- Você trabalha com problemas matemáticos complexos? O DeepSeek R1 ou o Grok 3 se destacam nessas tarefas.

Etapa 2: avaliar seu orçamento

- Para aplicações de alto volume com orçamento limitado: DeepSeek R1

- Para equilíbrio custo-desempenho: Claude Sonnet 4

- Para desempenho máximo sem restrições de custo: Claude 4 Opus

Etapa 3: experimente antes de decidir Felizmente, a maioria desses modelos oferece versões gratuitas ou créditos de avaliação. Experimente gratuitamente com todos os modelos que você considerar viáveis para seu caso de uso específico.

A concorrência entre os desenvolvedores continua a impulsionar melhorias constantes em velocidade, redução de custos e expansão de capacidade. Isso significa que você provavelmente verá atualizações significativas durante 2025 que beneficiarão diretamente sua implantação.

Se você precisar integrar esses modelos em seus sistemas existentes, como CRM, ERP ou aplicativos específicos, lembre-se de que muitos oferecem APIs robustas e documentação detalhada para facilitar a integração.

Escolher o modelo certo pode fazer a diferença entre uma implementação bem-sucedida e um investimento mal desperdiçado. Reserve um tempo para avaliar cada opção com seus dados reais antes de se comprometer com uma implantação em grande escala.

ANEXO, novo modelo ChatGPT-5

Fonte da imagem: OpenAI

Em abril de 2025, a OpenAI apresentou o ChatGPT-5, a evolução mais significativa desde o GPT-4, consolidando sua posição como referência em modelos de linguagem multimodal. Esse novo sistema não apenas melhora a velocidade e o custo por token, mas também introduz uma compreensão contextual muito mais profunda e uma memória ativa que muda a maneira como você interage com a IA.

Velocidade e desempenho

ChatGPT-5 oferece 2,3 vezes o desempenho do GPT-4o, atingindo uma velocidade média de 250 tokens por segundo com latências de resposta abaixo de 180 milissegundos no modo de voz. Esse salto se deve a uma arquitetura de inferência otimizada e processamento unificado de texto, áudio, imagem e vídeo em uma única rede neural.

O resultado é uma experiência mais tranquila, especialmente em aplicativos em tempo real ou ambientes de assistência conversacional contínua.

Contexto e capacidade de memória

Um dos maiores avanços do ChatGPT-5 é sua janela de contexto expandida para 512.000 tokens (1 milhão na versão corporativa), que permite que documentos extensos, repositórios de código ou relatórios corporativos inteiros sejam analisados sem fragmentar as informações.

Além disso, incorpora memória persistente, que preserva o histórico de interação, as preferências de estilo e o contexto do usuário entre as sessões. Isso permite uma adaptação progressiva e respostas mais coerentes ao longo do tempo.

Custo e eficiência

A OpenAI conseguiu reduzir os custos em cerca de 60% em comparação com o GPT-4o. O preço médio por 1.000 tokens ronda os 0,012€, tornando o ChatGPT-5 a versão mais barata e eficiente da série até à data.

Esse aprimoramento permite dimensionar projetos de negócios e fluxos de automação complexos sem comprometer a precisão ou a velocidade.

Integração e automação

ChatGPT-5 estende a interoperabilidade de modelos anteriores por meio de suporte nativo para o Model Context Protocol (MCP). Graças a esta camada padrão, você pode se conectar diretamente com ferramentas como n8n, Zapier, Make, CRMs ou ERPs, executando tarefas automatizadas e mantendo o contexto entre os sistemas.

Seu suporte estendido à API também permite a geração e validação de dados em tempo real, ideal para fluxos com agentes autônomos ou processos de verificação.

Experiência de conversação aprimorada

Na seção de voz, ChatGPT-5 atinge um nível notável de naturalidade. Ele reconhece entonações, pausas e emoções com mais precisão, oferecendo diálogos praticamente indistinguíveis do diálogo humano.

O sistema ajusta seu tom de acordo com o contexto – informativo, técnico ou comercial – e mostra uma melhor compreensão de outros idiomas além do inglês, corrigindo um dos pontos fracos do GPT-4.

Resumo Comparativo

| Característica | GPT-4 | GPT-4o | Bate-papoGPT-5 |

|---|---|---|---|

| Velocidade média | 60 tokens/s | 110 tokens/s | 250 tokens/s |

| Janela de contexto | 8K – 128K | 128 mil | 512 K – 1 M |

| Modalidades | Texto | Texto, áudio, imagem | Texto, áudio, imagem, vídeo |

| Memória persistente | Não | Parcial | Sim, entre sessões |

| Custo aproximado | € 0,03/1K | 0,015 €/1K | 0,012 €/1K |

| Integração | API | API | API + MCP (n8n, Zapier, etc.) |

Conclusão

ChatGPT-5 representa a maturidade da abordagem “omni” da OpenAI.

Sua combinação de maior velocidade, custos reduzidos, contexto expandido e memória verdadeira o posiciona como o modelo mais equilibrado para 2025.

Além disso, sua integração com ferramentas de automação como o n8n abre novas possibilidades para a construção de agentes de IA que conectam, pensam e agem em dados reais sem intervenção manual.

Perguntas frequentes

1º trimestre. Qual é o modelo LLM mais rápido disponível em 2025? O GPT-4o se destaca por sua velocidade, processando 110 tokens por segundo e oferecendo respostas de áudio em apenas 232 milissegundos, tornando-o ideal para conversas e aplicativos em tempo real que exigem respostas rápidas.

2º trimestre. Qual modelo oferece a melhor relação custo-benefício? O DeepSeek R1 se posiciona como a opção mais econômica, com preços até 90-95% mais baixos que os de concorrentes como a OpenAI, mantendo alto desempenho em tarefas de raciocínio e desenvolvimento de software.

3º trimestre. Qual é o modelo mais adequado para processar grandes volumes de informações? O Gemini 2.5 Pro se destaca com sua impressionante janela de contexto de 1.048.576 tokens, permitindo que até 1.500 páginas de texto sejam processadas simultaneamente, tornando-o ideal para analisar documentos grandes e bases de código complexas.

4º trimestre. Qual modelo é o mais avançado para tarefas de programação? Claude 4 Opus é considerado “o melhor modelo de programação do mundo”, liderando benchmarks como SWE-bench com 72,5% de desempenho e se destacando em tarefas complexas de codificação e refatoração de projetos inteiros.

Pergunta 5. Como os custos dos modelos LLM evoluíram em 2025? Os custos diminuíram significativamente. Por exemplo, o OpenAI o3 reduziu seus preços em 80%, oferecendo taxas competitivas de € 1,91 por milhão de tokens de entrada e € 7,63 por milhão de tokens de saída, tornando os modelos avançados mais acessíveis.