Die LLM-Modelle 2025 bieten eine Vielzahl von Optionen, um Geschwindigkeit, Kosten und Funktionen je nach Bedarf in Einklang zu bringen. In diesem Artikel vergleichen wir die wichtigsten Modelle, ihre starken und schwachen Spitzen und wie Sie das Beste aus ihnen herausholen können:

• GPT-4o ist führend in multimodaler Geschwindigkeit mit 110 Token/Sekunde und Echtzeit-Audiofunktionen, ideal für interaktive Gespräche und Multimedia-Verarbeitung.

• DeepSeek R1 ist die wirtschaftlichste Option mit 90-95% niedrigeren Kosten als bei der Konkurrenz, perfekt für mathematische Denkaufgaben und Softwareentwicklung.

• Gemini 2.5 Pro zeichnet sich durch sein riesiges Kontextfenster von 1M+ Token aus, mit dem bis zu 1.500 Seiten gleichzeitig für eine umfassende Dokumentenanalyse verarbeitet werden können.

• Claude 4 Opus setzt den Standard in der professionellen Codierung mit 72,5 % SWE-Bank und kontinuierlicher Arbeitskapazität von 7 Stunden ohne Beeinträchtigung.

• Die Wahl des Modells sollte auf spezifischen Anwendungsfällen basieren: Geschwindigkeit für Echtzeit (GPT-4o), Wirtschaftlichkeit für hohe Volumina (DeepSeek R1) oder maximale Leistung für komplexe Entwicklungen (Claude 4 Opus).

Der Wettbewerb zwischen diesen Modellen führt im Jahr 2025 zu stetigen Verbesserungen und bietet kostenlose Versionen, mit denen man experimentieren kann, bevor sie in großen Unternehmen eingesetzt werden.

GPT-4o

Bildquelle: Cody AI

Was ist das Besondere an GPT-4o unter all den verfügbaren Modellen? Dieses OpenAI-Modell, bei dem das “o” für “omni” steht, stellt einen großen qualitativen Sprung in der künstlichen Intelligenz dar. Im Gegensatz zu früheren Versionen, die nur Text verarbeiteten, kann GPT-4o gleichzeitig und in Echtzeit mit Text, Audio, Bildern und Video arbeiten. Diese multimodale Fähigkeit macht es zu einem wirklich vielseitigen Werkzeug für nahezu jede erdenkliche Anwendung.

Welche Geschwindigkeit bietet GPT-4o?

Die Geschwindigkeit von GPT-4o ist wirklich beeindruckend. Wenn Sie mit ihnen per Audio sprechen, erhalten Sie Antworten in nur 232 Millisekunden, mit einem Durchschnitt von 320 Millisekunden – etwa so viel wie die menschliche Reaktionszeit in einem natürlichen Gespräch.

Um die Verbesserung zu verstehen, die dies darstellt, sehen Sie sich diese Vergleichsdaten an:

- GPT-3.5 brauchte 2,8 Sekunden, um zu antworten

- GPT-4 benötigte 5,4 Sekunden, um Antworten zu generieren

In Bezug auf die Textverarbeitung erreicht GPT-4o 110 Token pro Sekunde, eine Geschwindigkeit, die etwa dreimal so hoch ist wie die von GPT-4 Turbo. Diese Geschwindigkeit übertrifft auch andere Konkurrenzmodelle wie das Claude 3 Opus und das Gemini 1.5 Pro.

Wie erreicht es diese Geschwindigkeit? Der Schlüssel liegt in der integrierten Architektur. Während frühere Modelle bis zu drei separate Systeme zur Verarbeitung von Audio (Transkription, Generierung und Synthese) benötigten, vereint GPT-4o alles in einem einzigen neuronalen Netzwerk.

Wie viel kostet die Nutzung von GPT-4o?

OpenAI hat es geschafft, GPT-4o viel billiger zu machen, mit einer Kostenreduzierung von 50 % im Vergleich zu GPT-4 Turbo. Hier ist die aktuelle Preisstruktur:

| Token-Typ | Preis |

| Token für den Eintrag | 0,01 $ pro 1.000 Token |

| Ausgabe-Token | 0,03 $ pro 1.000 Token |

Um Ihnen eine praktische Vorstellung zu geben: Die Verarbeitung eines Textes mit 500 Wörtern würde Sie ca. 7,64 € kosten (einschließlich 625 Eingabe-Token und 725 Ausgabe-Token).

Wenn Sie nach einer noch günstigeren Option suchen, können Sie GPT-4o mini verwenden. Diese Version kostet 0,15 US-Dollar pro Million Eingabe-Token und 0,60 US-Dollar pro Million Ausgabe-Token und ist damit etwa 7,2-mal günstiger als GPT-4.

Wie viele Informationen kann GPT-4o verarbeiten?

GPT-4o verarbeitet ein Kontextfenster von 128.000 Token, eine erhebliche Verbesserung gegenüber den 8.192 Token des ursprünglichen GPT-4. Was bedeutet das für Sie in der Praxis?

Mit dieser erweiterten Kapazität kann der GPT-4o:

- Analysieren Sie ganze lange Dokumente

- Führen Sie lange Gespräche, in denen Sie sich an den gesamten vorherigen Kontext erinnern

- Verarbeiten und reagieren Sie auf der Grundlage großer Informationsmengen

- Generieren Sie bis zu 16.384 Token in einer einzigen Antwort

Denken Sie daran, dass, obwohl dieses Kontextfenster breit ist, Modelle wie Claude 3.5 Sonnet 200.000 Token bieten und Gemini 1.5 Pro 2 Millionen erreicht.

Wann empfehlen wir die Verwendung von GPT-4o?

GPT-4o zeichnet sich besonders aus, wenn Sie eine multimodale Verarbeitung und schnelle Antworten benötigen. Wir empfehlen Ihnen, es in Betracht zu ziehen für:

Echtzeit-Konversationen: Seine geringe Latenz macht es zur idealen Wahl für Chatbots und virtuelle Assistenten, die flüssige und natürliche Interaktionen erfordern.

Vielfältige Sprachverarbeitung: Zeigt signifikante Verbesserungen bei der Arbeit mit anderen Sprachen als Englisch. Zum Beispiel werden 4,4-mal weniger Token für Gujarati, 3,5-mal weniger für Telugu und 3,3-mal weniger für Tamil verwendet.

Bildanalyse: Seine verbesserte Fähigkeit, visuelle Inhalte zu verstehen, macht es perfekt für die Beschreibung von Dokumenten, Diagrammen oder Screenshots.

Arbeiten mit Audio: Es kann Audioeingaben direkt verarbeiten, nicht nur verbale Inhalte, sondern auch Töne aufnehmen, mehrere Sprecher identifizieren und Hintergrundgeräusche herausfiltern.

Medienerstellung: Generieren Sie Texte und Bilder integriert und kontextuell.

Beachten Sie jedoch, dass GPT-4o zwar schneller ist als GPT-4 Turbo, aber keine signifikante Steigerung der allgemeinen Denkfähigkeiten zeigt. Wenn Sie eine komplexe Argumentation benötigen, sind andere Modelle möglicherweise besser für Ihr Projekt geeignet.

Claude Sonett 4

Bildquelle: CometAPI

Suchen Sie nach einem LLM-Modell, das außergewöhnliche Leistung mit angemessenen Kosten kombiniert? Claude Sonnet 4, das im Mai 2025 von Anthropic veröffentlicht wurde, stellt genau die ausgewogene Lösung dar, die Sie brauchen. Dieses Modell wurde speziell entwickelt, um fortschrittliche Codierungs- und Denkfunktionen zu bieten, ohne Ihr Budget zu beeinträchtigen, und positioniert sich als die praktischste Alternative innerhalb der Claude 4-Familie.

Im Gegensatz zu seinem großen Bruder Claude Opus 4 legt Sonnet 4 Wert auf Effizienz, ohne die Qualität zu beeinträchtigen, was es zur idealen Wahl für Entwickler und Unternehmen macht, die den maximalen Wert für ihre Investition suchen.

Claude Sonnet Speed 4

Sie fragen sich, wie schnell es Ihre Anfragen bearbeiten kann? Claude Sonnet 4 ist für Anwendungen mit hohen Stückzahlen optimiert, wobei die behördlichen Grenzwerte die Vorgängerversionen deutlich übertreffen:

- 50 Anfragen pro Minute (RPM)

- 30.000 Eingabe-Token pro Minute (ITPM)

- 8.000 Ausgabe-Token pro Minute (OTPM)

In der offiziellen Ankündigung von Anthropic heißt es: “Wir haben die API-Geschwindigkeitsbegrenzungen für Claude Sonnet 4 erhöht.” Diese Verbesserung ermöglicht es Ihnen, mehr Daten zu verarbeiten, ohne häufig an Grenzen zu stoßen, Ihre Anwendungen so zu skalieren, dass mehr Benutzer gleichzeitig bedient werden, und mehrere API-Aufrufe parallel auszuführen.

Denken Sie daran, dass Sonnet 4 ein innovatives “Cache-aware ITPM”-System implementiert. Nur nicht zwischengespeicherte Eingabetoken werden auf die Ratenlimits angerechnet. Mit einem ITPM-Limit von 2.000.000 und einer Cachetrefferrate von 80 % könnten Sie beispielsweise insgesamt 10.000.000 Eingabetoken pro Minute effektiv verarbeiten.

Claude Sonnet 4 Kosten

Die Preisstruktur von Claude Sonnet 4 ist so konzipiert, dass sie zugänglich und vorhersehbar ist:

| Token-Typ | Standardpreis | Preis mit Cache (5 min) | Preis mit Cache (1 Stunde) | Cache-Treffer |

| Token für den Eintrag | EUR 2.86/MTok | EUR 3.58/MTok | EUR 5.73/MTok | EUR 0,29/MTok |

| Ausgabe-Token | EUR 14,31/MTok | – | – | – |

Es wird empfohlen, die Zwischenspeicherung von Eingabeaufforderungen zu verwenden, um die Kosten zu optimieren, insbesondere wenn Ihre Anwendung wiederholte Abfragen ausführt. Für lange Kontexte (mehr als 200.000 Token), wenn Sie das 1M-Kontextfenster verwenden, fällt eine Premium-Gebühr an: 5,73 EUR pro Million Eingabe-Token und 21,47 EUR pro Million Ausgabe-Token.

Wenn Sie mit einem hohen Verarbeitungsvolumen umgehen, bietet Ihnen die Batch-API einen Rabatt von 50 %, wodurch die Kosten auf 1,43 EUR/MTok für die Eingabe und 7,16 EUR/MTok für die Ausgabe reduziert werden.

Claude Sonnet 4 Kontextfenster

Müssen Sie lange Dokumente bearbeiten oder lange Gespräche führen? Claude Sonnet 4 bietet ein Standard-Kontextfenster von 200.000 Token (ca. 150.000 Wörter oder ca. 500 Seiten Text), mit dem Sie komplexe Codebasen in einer einzigen Interaktion analysieren können.

Für Organisationen in Nutzungsstufe 4 und solche mit benutzerdefinierten Limits bietet Claude Sonnet 4 ein erweitertes Fenster von bis zu 1 Million Token im Beta-Modus. Diese Funktion ist über die Anthropic API, Amazon Bedrock und Google Vertex AI verfügbar und ermöglicht Folgendes:

- Umfangreiche Codeanalyse (bis zu 75.000 Codezeilen)

- Extrem umfangreiche Dokumentenverarbeitung

- Entwicklung von KI-Agenten mit langen Denkfähigkeiten

Um auf diese Funktion zuzugreifen, fügen Sie den Beta-Header “context-1m-2025-08-07” in Ihre API-Anfragen ein.

Beste Verwendung von Claude Sonnet 4

Claude Sonnet 4 zeichnet sich besonders in diesen Szenarien aus:

Codierung und Entwicklung: Mit außergewöhnlichen Ergebnissen in Benchmarks wie SWE-bench (72,7 %, etwas besser als Opus 4 mit 72,5 %) ist es perfekt für Programmieraufgaben, von der Codegenerierung bis zum vollständigen Refactoring.

Kundendienstmitarbeiter: Seine Effizienz und Geschwindigkeit machen es zur idealen Wahl für Chatbots und virtuelle Assistenten mit hohem Volumen, die schnelle, aber ausgefeilte Antworten erfordern.

Dokumentenverarbeitung: Perfekt zum Zusammenfassen, Analysieren oder Extrahieren von Informationen aus großen Dokumenten dank des breiten Kontextfensters.

Kostengünstige Unternehmensanwendungen: Da Leistung und Kosten in Einklang gebracht werden, ist es die bevorzugte Wahl für Implementierungen, die eine intensive Verarbeitung bei gleichzeitiger Einhaltung von Budgetbeschränkungen erfordern.

Ein weiterer Vorteil ist die kostenlose Verfügbarkeit über die Weboberfläche von Claude, im Gegensatz zu Opus 4, für das ein kostenpflichtiges Abonnement erforderlich ist. Dies macht es zu einer wertvollen Ressource, wenn Sie mit leistungsstarken LLM-Modellen experimentieren möchten, ohne dass Vorabkosten anfallen.

Grok 3

Bildquelle: CometAPI

Suchen Sie nach einem LLM-Modell mit erweiterten Argumentationsfunktionen? Grok 3, das von xAI im Februar 2025 veröffentlicht wurde, könnte die Lösung sein, die Sie brauchen. Dieses Modell wurde unter der Leitung von Elon Musk entwickelt und in einem beeindruckenden Rechenzentrum mit 200.000 Grafikprozessoren (GPUs) trainiert. Dieser Rechenaufwand, der zehnmal höher war als der Vorgänger, führte zu 200 Millionen kumulierten Rechenstunden.

Welche Geschwindigkeit bietet Grok 3?

Hier sind die herausragendsten Ergebnisse von Grok 3 in Bezug auf die Verarbeitungsgeschwindigkeit:

- Es löste ein komplexes logisches Denkrätsel in nur 67 Sekunden, während Konkurrenten wie DeepSeek R1 343 Sekunden brauchten

- Der “Think”-Modus verarbeitete komplexe Abfragen und generierte 3D-Animationscode in 114 Sekunden

Darüber hinaus bietet dir xAI eine optimierte Variante namens Grok 3 Mini an, bei der die Geschwindigkeit über ein gewisses Maß an Genauigkeit gestellt wird. Diese Flexibilität ermöglicht es Ihnen, je nach Ihren spezifischen Anforderungen zwischen maximaler Leistung oder agileren Reaktionen zu wählen.

Grok 3 Kostenstruktur

Im Folgenden finden Sie die Preisstruktur, mit der Sie beurteilen können, welche Version am besten zu Ihrem Budget passt:

| Modell | Eingabe-Token | Kosten für Ausgabe-Token |

| Grok 3 | 2,86 EUR pro Mio. | 14,31 Euro pro Mio. |

| Grok 3 Mini | 0,29 EUR pro Mio | 0,48 EUR pro Mio. |

Wie Sie sehen können, ist Grok 3 Mini etwa 10-mal billiger für Eingabe-Token und 30-mal billiger für Ausgabe-Token. Wir empfehlen diese Variante, wenn Sie eine kostengünstige Alternative für hochvolumige Anwendungen suchen.

Der primäre Zugang erfolgt über das X Premium+-Abonnement, das in den USA 38,17 € pro Monat kostet, nachdem es kürzlich von 20,99 € erhöht wurde. Sie können auch den für 28,63 EUR pro Monat beworbenen “SuperGrok”-Plan in Betracht ziehen, der erweiterte Funktionen bietet.

Verfügbare Kontextkapazität

Sowohl Grok 3 als auch Grok 3 Mini bieten Ihnen ein Kontextfenster von 131.072 Token. Diese Funktion ermöglicht es Ihnen, lange Dokumente zu verarbeiten und lange Gespräche zu führen, ohne relevante Kontextinformationen zu verlieren.

Denken Sie daran, dass, obwohl es theoretisch bis zu einer Million Token verarbeiten kann, Benutzerstudien darauf hindeuten, dass die optimale Leistung bis zu etwa 80.000 Token aufrechterhalten wird. Jenseits dieser Schwelle kann es zu einer allmählichen Verschlechterung der Kohärenz kommen.

Wann sollte man Grok 3 verwenden?

Wir empfehlen Grok 3 insbesondere für die folgenden Szenarien:

Mathematisches und naturwissenschaftliches Denken: Erzielen Sie hervorragende Ergebnisse in Tests wie AIME (Mathematik) und GPQA (Physik, Chemie und Biologie) und schlagen Sie Spitzenkonkurrenten.

Codeentwicklung: Generiert strukturierteren und funktionaleren Code als andere Modelle, insbesondere in Webanwendungen und Benutzeroberflächen. Seine Fähigkeit, optimierte HTML5-Lösungen zu erstellen, macht es ideal, wenn Sie ein Programmierer sind.

Recherche mit DeepSearch: Die integrierte Suchmaschine scannt das Internet und das soziale Netzwerk X und liefert dokumentierte Antworten schneller als Alternativen wie Gemini und OpenAI.

Kreatives Schreiben: Demonstrieren Sie überlegene Fähigkeiten im Geschichtenerzählen mit besserer Charakterbildung und besserer Handlungsentwicklung.

Content-Generierung mit weniger Einschränkungen: Bieten Sie einen weniger zensierten Ansatz und sprechen Sie sensible Themen auf ausdrücklichen Wunsch direkter an.

Wenn Sie ein LLM-Modell mit starken Argumentationsfähigkeiten benötigen und nach einem effektiven Gleichgewicht zwischen Geschwindigkeit, Kosten und Kontextbreite suchen, stellt Grok 3 eine leistungsstarke Option dar, die Sie im Jahr 2025 in Betracht ziehen sollten.

DeepSeek R1

Bildquelle: DeepSeek

Suchen Sie nach einem LLM-Modell, das Argumentationskraft mit erschwinglichen Preisen kombiniert? DeepSeek R1, das in China entwickelt und im Januar 2025 veröffentlicht wurde, könnte genau das sein, was Sie brauchen. Dieses Denkmodell basiert auf DeepSeek V3, enthält aber signifikante Verbesserungen durch Reinforcement Learning (RL), was es zu einem außergewöhnlich leistungsfähigen Werkzeug für die Lösung mathematischer und logischer Probleme sowie für die wissenschaftliche Analyse macht.

DeepSeek R1 Geschwindigkeit

Wenn Sie DeepSeek R1 evaluieren, werden Sie feststellen, dass bei seinem Ansatz Genauigkeit über Geschwindigkeit gestellt wird:

- Verarbeitet ca. 28 Token pro Sekunde

- Es ist etwa 6-mal langsamer als o1-mini und doppelt so langsam wie ChatGPT 4o

- Verbringen Sie zusätzliche Zeit mit tiefem Denken, bevor Sie Antworten generieren

Diese langsamere Geschwindigkeit hat einen Grund: DeepSeek R1 korrigiert sich während seiner Gedankenkette selbst und erkennt seine eigenen Fehler, bevor es die endgültige Antwort anbietet. Wenn Sie extrem präzise Antworten für komplexe Aufgaben benötigen, ist dieser deliberative Ansatz für Sie von Vorteil, insbesondere wenn Genauigkeit wichtiger ist als unmittelbare Geschwindigkeit.

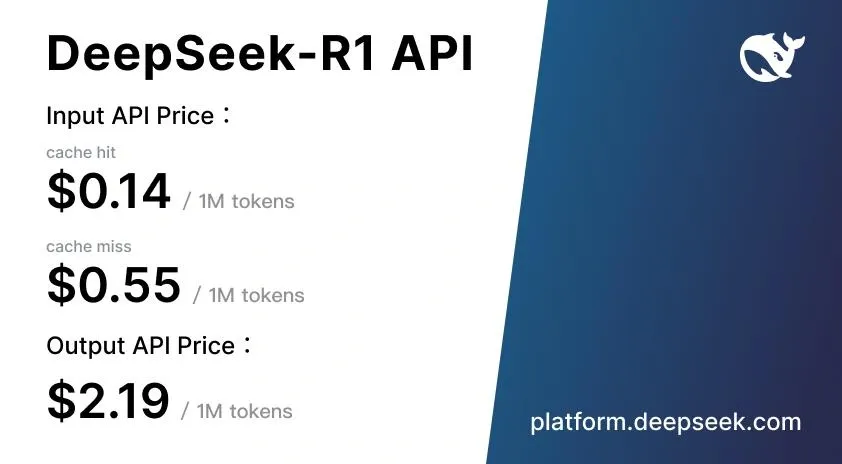

Kosten von DeepSeek R1

Hier finden Sie einen der herausragendsten Vorteile von DeepSeek R1: seine äußerst wettbewerbsfähige Preisstruktur.

| Token-Typ | Einheitspreis |

| Eingabe-Token (Cache-Treffer) | <citation index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0.13 |

| Eingabe-Token (Cache-Fehler) | <Zitationsindex=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0.13 |

| Ausgabe-Token | <citation index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0.13 |

Diese Preise sind 90-95 % niedriger als bei OpenAI o1, das 14,31 € pro Million Input-Token und 57,25 € pro Million Output-Token kostet. Darüber hinaus implementiert DeepSeek ein intelligentes Caching-System, das Ihnen Einsparungen von bis zu 90 % bei wiederholten Abfragen ermöglicht.

Wir empfehlen, DeepSeek R1 kostenlos über die DeepSeek Chat-Webplattform zu testen, wo Sie ohne Vorabkosten mit den Funktionen experimentieren können.

DeepSeek R1 Kontextfenster

DeepSeek R1 verarbeitet ein Kontextfenster mit 128.000 Token, sodass Sie Folgendes tun können:

- Verarbeiten Sie komplexe, mehrstufige Denkaufgaben

- Wahrung der Konsistenz über lange Dokumente hinweg

- Verfolgen Sie komplexe Argumentationsketten, ohne Informationen zu verlieren

- Detaillierte technische Diskussionen unter Beibehaltung des vollständigen Kontexts führen

Mit dieser Funktion liegt DeepSeek R1 auf dem gleichen Niveau wie GPT-4o (128 KB), wenn auch unter Claude 3.5 Sonnet (200 K) und Gemini 1.5 Pro (2 Millionen).

Beste Nutzung von DeepSeek R1

DeepSeek R1 eignet sich besonders gut, wenn Sie Folgendes benötigen:

- Mathematische und technische Problemlösung: Ideal für wissenschaftliche Forschung, Technik und Finanzen

- Softwareentwicklung und -codierung: Konkurrieren Sie effektiv mit Claude und OpenAI o1-mini in der automatisierten Programmierung

- RAG-Aufgaben (Recovery-Augmented Generation): Funktioniert genauso gut wie GPT-4o mit expliziter Schritt-für-Schritt-Argumentation

- Anpassung durch Open Source: Ihre MIT-Lizenz ermöglicht Modifikationen für spezifische Bedürfnisse

- Apps für den chinesischen Markt: Speziell optimiert für das Verständnis der chinesischen Sprache

Denken Sie daran, dass DeepSeek R1 einige wichtige Einschränkungen aufweist. Seine mehrsprachige Leistung ist außerhalb von Englisch und Chinesisch schlecht und es unterstützt keine Bildanalyse, was seine Nützlichkeit in multimodalen Anwendungen einschränkt.

Gemäß dem DeepSeek-R1-Zero-Modell kann das Denken allein mit RL von Grund auf neu entstehen, so dass erweiterte Funktionen entwickelt werden können, ohne sich auf gelabelte Daten verlassen zu müssen. Dies macht DeepSeek R1 besonders wertvoll für Forschungsteams, die neue Modelltrainingstechniken erforschen möchten.

Zwillinge 2.5 Pro

Bildquelle: CometAPI

Der im März 2025 eingeführte Gemini 2.5 Pro ist das fortschrittlichste Denkmodell, das Google bisher entwickelt hat. Wenn Sie auf der Suche nach einem Tool sind, mit dem Sie komplexe Probleme lösen können, bietet Ihnen dieses Modell verbesserte Denkfunktionen und ein Kontextfenster, das die Art und Weise verändert, wie Sie große Informationsmengen verarbeiten.

Gemini 2.5 Pro Geschwindigkeit

Du fragst dich, was die Geschwindigkeit des Gemini 2.5 Pro so besonders macht? Im Gegensatz zu anderen LLM-Modellen funktioniert dieses System auf einzigartige Weise: Es verbringt etwa 20 Sekunden mit der anfänglichen Argumentation und generiert dann Token mit einer außergewöhnlich hohen Geschwindigkeit. Betrachten Sie es als einen “Denk nach, bevor du antwortest”-Prozess, der dir eine perfekte Balance zwischen tiefgreifender Analyse und Geschwindigkeit bei der Erstellung von Inhalten bietet.

Das Modell übertrifft die Geschwindigkeit früherer Versionen deutlich, ohne die Qualität des Ergebnisses zu beeinträchtigen. Darüber hinaus hat Google seine Infrastruktur so konzipiert, dass die typischen Geschwindigkeitsbegrenzungen, die Sie bei anderen konkurrierenden Systemen erleben, vermieden werden, um sicherzustellen, dass Sie auch bei der Arbeit mit komplexen Aufgaben ein reibungsloseres Erlebnis haben.

Gemini 2.5 Pro Kosten

Die Preisstruktur von Gemini 2.5 Pro variiert je nach Volumen der von Ihnen verwendeten Token und der Art der Verarbeitung, die Sie benötigen:

| Art der Verarbeitung | Token für den Eintrag | Ausgabe-Token |

| Standard (≤200K Token) | 1,25 $ pro Million | 10,00 $ pro Million |

| Standard (>200K Token) | 2,50 $ pro Million | 15,00 $ pro Million |

| Stapelverarbeitung | 0,625 $ pro Million | 5,00 $ pro Million |

Google bietet Ihnen auch ein Caching-System, mit dem Sie Ihre Kosten für sich wiederholende Abfragen erheblich senken können, mit Preisen ab 0,125 $ pro Million Token.

Um auf Gemini 2.5 Pro zuzugreifen, können Sie zwischen dem Abonnement Google AI Pro (21,99 €/Monat) oder Google AI Ultra (274,99 €/Monat) wählen, wenn Sie höhere Nutzungslimits benötigen.

Gemini 2.5 Pro Kontextfenster

Eines der Merkmale, von denen Sie an Gemini 2.5 Pro am meisten beeindruckt sein werden, ist das außergewöhnliche Kontextfenster von 1.048.576 Token, das in zukünftigen Updates auf 2 Millionen erweitert werden soll. Was bedeutet das für Sie in der Praxis?

- Sie können bis zu 1.500 Textseiten gleichzeitig verarbeiten

- Analysieren Sie 30.000 Codezeilen in einem einzigen Vorgang

- Führen Sie ausführliche Gespräche, ohne Kontextinformationen zu verlieren

Diese umfangreiche kontextbezogene Funktion macht es Ihnen leicht, ganze Dokumente, umfangreiche Codebasen und komplexe Datensätze in einer einzigen Sitzung zu analysieren.

Beste Nutzung von Gemini 2.5 Pro

Wir empfehlen Gemini 2.5 Pro speziell für:

- Fortgeschrittene Webentwicklung: Führt das WebDev Arena-Ranking bei der Erstellung funktionaler und ästhetisch ansprechender Webanwendungen an

- Komplexes Denken: Ideal, wenn Sie mathematische, naturwissenschaftliche und vielschichtige Probleme lösen müssen, die eine Schritt-für-Schritt-Analyse erfordern

- Code-Transformation und -Bearbeitung: Besonders effektiv für die Automatisierung komplexer Programmieraufgaben

- Multimodale Verarbeitung: Fähigkeit, Text-, Code-, Bild-, Audio- und Videoeingaben zu verstehen

Wenn Sie ein Entwickler, Forscher oder Fachmann sind, der große Mengen an multimodalen Informationen mit tiefem und präzisem Denken verarbeiten muss, wird dieses Modell für Sie besonders wertvoll sein.

Claude 4 Opus

Bildquelle: CometAPI

Suchen Sie nach dem leistungsstärksten LLM-Modell für fortgeschrittene Programmierung? Claude Opus 4, das im Mai 2025 auf den Markt kam, repräsentiert das Premium-Angebot von Anthropic und ist laut Hersteller als “das beste Programmiermodell der Welt” positioniert. Diese Version setzt einen neuen Standard in der dialogorientierten künstlichen Intelligenz, die speziell für Deep Reasoning und komplexe Codierungsaufgaben entwickelt wurde.

Claude Speed 4 Opus

Claude Opus 4 bietet Ihnen eine bemerkenswerte Rechenleistung, wobei die offiziellen Grenzen bei folgenden Werten festgelegt sind:

- 50 Anfragen pro Minute (RPM)

- 30.000 Eingabe-Token pro Minute (ITPM)

- 8.000 Ausgabe-Token pro Minute (OTPM)

Was macht dieses Modell wirklich besonders? Seine einzigartige Fähigkeit, längere Arbeitssitzungen durchzuhalten. Während andere Konkurrenten nach ein oder zwei Stunden an Konsistenz verlieren, kann Claude Opus 4 bis zu sieben Stunden lang ununterbrochen arbeiten, ohne dass die Leistung beeinträchtigt wird. Diese Funktion ist unerlässlich, wenn Sie an komplexen Programmierprojekten arbeiten, die anhaltende Konzentration erfordern.

Claude 4 Opus Kosten

Wir empfehlen Ihnen, Ihr Budget sorgfältig zu überdenken, da Claude Opus 4 eine Premium-Investition darstellt:

| Token-Typ | Standardpreis | Mit Stapelverarbeitung |

| Eingang | EUR 14,31/MTok | EUR 7,16/MTok |

| Ausgang | EUR 71.57/MTok | EUR 35.78/MTok |

Mit diesen Preisen steht Opus 4 an der Spitze des Marktes. Sie können die Kosten jedoch optimieren, indem Sie die Mechanismen verwenden, die Anthropic bietet: promptes Caching (Kostensenkung um bis zu 90 %) und Batch-Verarbeitung (mit einem Rabatt von 50 %).

Kontextfenster von Claude 4 Opus

Claude Opus 4 hat ein Kontextfenster von 200.000 Token, vergleichbar mit seinem Vorgänger, aber niedriger als die 1.048.576 Token von Gemini 2.5 Pro. Beachten Sie, dass diese Einschränkung für extrem große Codebasen restriktiv sein kann, aber für die meisten praktischen Anwendungen ausreichend ist.

Das Modell enthält eine einzigartige Funktion: “Erweitertes Denken”, ein Modus, der es Ihnen ermöglicht, zwischen internem Denken und der Verwendung externer Werkzeuge zu wechseln. Diese Funktionalität verbessert Ihre Fähigkeit, komplexe Probleme zu lösen, erheblich.

Beste Verwendung von Claude 4 Opus

Wann sollten Sie sich für Claude Opus 4 entscheiden? In diesen Fällen sticht es besonders hervor:

- Komplexe Codierungsaufgaben: SWE-bench führt den Benchmark mit 72,5 % und Terminal-bench mit 43,2 % an und lässt Konkurrenten wie GPT-4.1 (54,6 %) und Gemini 2.5 Pro (63,2 %) hinter sich.

- Fortgeschrittenes wissenschaftliches Denken: Erreicht 79,6 % im GPQA Diamond (83,3 % im High-Computing-Modus).

- Autonome KI-Agenten: Sein langes Aufmerksamkeitsfenster macht es ideal für Aufgaben, die Tausende von Schritten und Stunden kontinuierlicher Bearbeitung erfordern.

- Projektumgestaltung: Sie können ganze Codebasen in einer einzigen Sitzung analysieren und ändern.

Wenn Sie ein professioneller Entwickler, Forscher oder Teil eines Teams sind, das fortschrittliche KI-Agenten erstellt und ein Höchstmaß an Leistung benötigt, ist Claude Opus 4 die optimale Wahl.

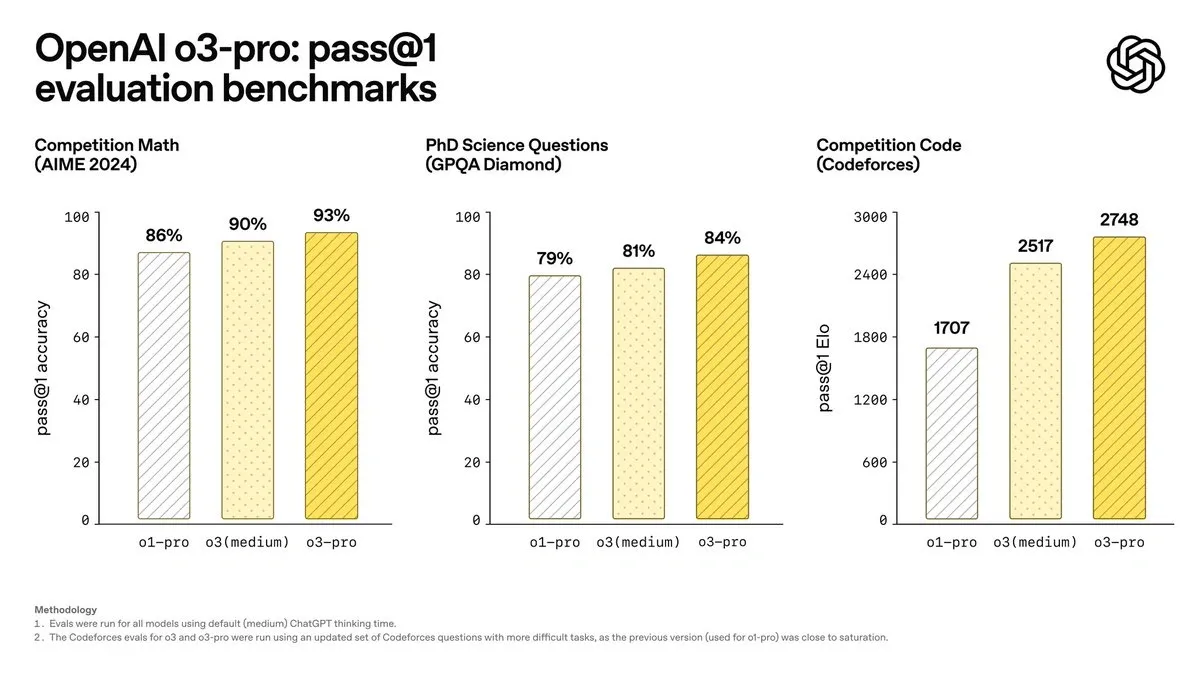

OpenAI o3

Bildquelle: apidog

OpenAI stellt im April 2025 sein o3-Modell vor, das einen Wendepunkt im Bereich des künstlichen Denkens markiert. Im Gegensatz zu den Modellen, die wir zuvor besprochen haben, ist o3 speziell darauf ausgelegt, “länger zu denken, bevor Sie reagieren” und fortschrittliche Argumentationsfunktionen mit autonomem Zugriff auf Tools zu integrieren.

Welche Geschwindigkeit bietet OpenAI o3?

Obwohl o3 tiefe Reflexion in den Vordergrund stellt, behält es eine Effizienz bei, die Sie überraschen wird:

- Übertrifft den o1-Durchsatz bei gleicher Latenz

- Seine Architektur ermöglicht langwieriges Denken, ohne die Reaktionsgeschwindigkeit zu beeinträchtigen

- Die o3-mini-Version zeigt 24 % schnellere Zeiten an (7,7 Sekunden im Vergleich zu 10,16 Sekunden bei o1-mini)

Im Vergleich zu anderen Reasoning-Modellen gelingt es o3, komplexe Aufgaben in der Regel in weniger als einer Minute zu erledigen und so ein effektives Gleichgewicht zwischen tiefgreifender Analyse und Reaktionsagilität herzustellen.

OpenAI o3 Preisstruktur

Es wird Sie freuen zu hören, dass OpenAI die Preise von o3 deutlich gesenkt hat:

| Kerl | Ursprünglicher | Aktueller Preis (80% Ermäßigung) |

| Token für den Eintrag | 9,54 €/Mio. | 1,91 €/Mio. |

| Ausgabe-Token | 38,17 €/Mio. | 7,63 €/Mio. |

| Cache-Eingabe | – | 0,48 €/Mio. |

Mit dieser Reduzierung positioniert sich o3 im Wettbewerb mit Gemini 2.5 Pro (0,95 €/Mio. Input, 9,54 €/Mio. Output) und Claude Sonnet 4 (2,86 €/Mio. Input, 14,31 €/Mio. Output).

OpenAI o3 Kontextfähigkeit

O3 bietet außergewöhnliche kontextbezogene Funktionen, die Sie in Betracht ziehen sollten:

- Verarbeitet bis zu 128.000 Token in Standardbereitstellungen

- Erreichen Sie 200.000 Token in bestimmten Umgebungen

- Generieren von bis zu 100.000 Ausgabetoken

Diese kontextbezogene Breite ermöglicht es Ihnen, lange Dokumente und komplexen Code zu analysieren und lange Gespräche zu führen, ohne die Konsistenz zu beeinträchtigen.

Wann sollte OpenAI o3 verwendet werden?

Wir empfehlen o3 speziell für diese Anwendungsfälle:

Programmierung auf hohem Niveau: Es führt SWE-bench mit 71,7 % an und übertrifft o1 (48,9 %) deutlich, was es zur besten Wahl für komplexe Entwicklungen macht.

Erweiterte mathematische Auflösung: Mit 96,7 % in AIME im Vergleich zu 83,3 % in o1 ist es ideal, wenn Sie außergewöhnliche mathematische Präzision benötigen.

Wissenschaftliche Forschung: Erreicht 87,7 % in GPQA Diamond und beweist damit die Beherrschung hochkomplexer wissenschaftlicher Fragen.

Integrierte visuelle Analyse: Integriert Bilder in Ihre Argumentation und ermöglicht es Ihnen, Diagramme und Grafiken kontextbezogen zu analysieren.

Automatisierung mit Tools: Kombiniert Websuche, Dateianalyse und Python-Codeausführung autonom.

Darüber hinaus lässt sich o3 in die Codex-CLI integrieren, sodass Entwickler, die ihren Workflow optimieren möchten, die Funktionen direkt von der Befehlszeile aus nutzen können.

Vergleichstabelle

Benötigen Sie einen schnellen Überblick, um all diese Modelle zu vergleichen? Hier ist eine Übersichtstabelle, die Ihnen hilft, herauszufinden, welche am besten zu Ihren spezifischen Anforderungen passt.

Denken Sie daran, dass jedes Modell seine besonderen Stärken hat. Dieser Vergleich ermöglicht es Ihnen, schnell die wichtigsten Unterschiede zwischen Geschwindigkeit, Kosten und Funktionen zu bewerten:

| Modell | Geschwindigkeit | Kosten (pro Million Token) | Kontext-Fenster | Optimale Anwendungsfälle |

| GPT-4o | 110 Token/Sekunde | Buy-in: 0,01 €/1.000 Token Ausgabe: 0,03 €/1.000 Token |

128.000 Token• | Echtzeit-Konversationen • Mehrsprachige Verarbeitung• Visuelle Analyse• Audio-Transkription |

| Claude Sonett 4 | 50 Anfragen/min | Buy-in: €2.86 Ausgabe: 14,31 |

200.000 Token (erweiterbar auf 1M) | • Codierung • Kundensupport • Dokumentenverarbeitung • Unternehmensanwendungen |

| Grok 3 | 67 Sekunden (Logiknachweise) | Buy-in: €2.86 Ausgabe: 14,31 |

131.072 Token• | Mathematisches Denken• Codeentwicklung • Forschung • Kreatives Schreiben |

| DeepSeek R1 | 28 Token/Sekunde | Einkauf: 0,52 €Ausgabe: 2,09 |

128.000 Token | • Mathematische Problemlösung• Softwareentwicklung • RAG • Chinesischer Markt |

| Zwillinge 2.5 Pro | 20s anfänglich + hohe Geschwindigkeit | Eintritt: $1.25 Ausgabe: $10.00 |

1.048.576 Token | • Webentwicklung • Komplexes Denken• Code-Transformation • Multimodale Verarbeitung |

| Claude 4 Opus | 50 Anfragen/min | Eintritt: 14,31 €Ausgabe: 71,57 |

200.000 Token | • Komplexe Codierung• Wissenschaftliches Denken• Autonome KI-Agenten • Refactoring |

| OpenAI o3 | N/A | Eintritt: 1,91 €Ausgabe: 7,63 |

128.000 Token (erweiterbar auf 200K) | • Fortgeschrittene Programmierung• Mathematik • Naturwissenschaften • Visuelles Denken |

Wenn Sie auf der Suche nach der günstigsten Option sind, bietet DeepSeek R1 unschlagbare Preise. Für maximale Geschwindigkeit in multimodalen Anwendungen ist GPT-4o die beste Alternative. Müssen Sie langwierige Dokumente verarbeiten? Gemini 2.5 Pro mit seinem massiven Kontextfenster ist perfekt für Sie.

Wir empfehlen Ihnen, zunächst Ihre spezifischen Anwendungsfälle zu evaluieren, bevor Sie sich für ein Modell entscheiden. Die meisten bieten kostenlose Versionen an, sodass Sie sie ohne Vorabkosten ausprobieren können.

Fazit

Welches LLM-Modell passt am besten zu Ihren spezifischen Bedürfnissen? Die Antwort hängt ganz von Ihren speziellen Anwendungsfällen und dem verfügbaren Budget ab.

Denken Sie daran, dass jedes Modell seine eigenen Stärken hat. GPT-4o zeichnet sich aus, wenn Sie schnelle multimodale Antworten benötigen, während Claude Sonnet 4 Ihnen ein außergewöhnliches Gleichgewicht zwischen Leistung und Kosten bietet. Wenn Sie mit komplexem mathematischem Denken arbeiten, ist Grok 3 möglicherweise die beste Option.

Auf der Suche nach der günstigsten Alternative? DeepSeek R1 stellt eine außergewöhnliche Option dar, insbesondere wenn Sie komplexe technische Probleme lösen müssen, ohne Ihr Budget zu gefährden. Um langwierige Dokumente oder umfangreiche Codebasen zu verarbeiten, können Sie mit Gemini 2.5 Pro mehr als eine Million Token in einer einzigen Sitzung verarbeiten.

Wenn Sie diese Modelle für die berufliche Entwicklung verwenden, die maximale Leistung erfordert, setzt Claude 4 Opus den höchsten Standard in der fortgeschrittenen Programmierung. Auf der anderen Seite zeichnet sich OpenAI o3 besonders durch Programmierung und Mathematik mit integrierten visuellen Fähigkeiten aus.

Das Interessante an den Modellen ist, dass sie alle in unseren KI-Agenten mit n8n verwendet werden können. Durch unsere Vorlagen können Sie die volle Leistungsfähigkeit der verschiedenen Modelle in Ihren Arbeitsabläufen nutzen, um jedes Ziel zu erreichen, das Sie sich selbst gesetzt haben.

Wie wählen Sie Ihr ideales Modell aus?

Wir empfehlen Ihnen, diese wichtigen Aspekte zu berücksichtigen:

Schritt 1: Definieren Sie Ihren primären Anwendungsfall

- Müssen Sie große Mengen an Dokumenten verarbeiten? Gemini 2.5 Pro oder Claude Sonnet 4 sind Ihre besten Alternativen.

- Legen Sie Wert auf schnelle interaktive Gespräche? GPT-4o bietet Ihnen die beste Erfahrung.

- Arbeiten Sie mit komplexen mathematischen Problemen? DeepSeek R1 oder Grok 3 zeichnen sich durch diese Aufgaben aus.

Schritt 2: Bewerten Sie Ihr Budget

- Für hochvolumige Anwendungen mit kleinem Budget: DeepSeek R1

- Für ein ausgewogenes Preis-Leistungs-Verhältnis: Claude Sonnet 4

- Für maximale Leistung ohne Kosteneinschränkungen: Claude 4 Opus

Schritt 3: Experimentieren Sie, bevor Sie sich entscheiden Glücklicherweise bieten die meisten dieser Modelle kostenlose Versionen oder Testguthaben an. Probieren Sie es kostenlos mit jedem Modell aus, das Sie für Ihren speziellen Anwendungsfall für geeignet halten.

Der Wettbewerb unter den Entwicklern führt weiterhin zu ständigen Verbesserungen bei der Geschwindigkeit, Kostensenkung und Kapazitätserweiterung. Das bedeutet, dass Sie im Laufe des Jahres 2025 wahrscheinlich bedeutende Updates sehen werden, die Ihrer Bereitstellung direkt zugute kommen werden.

Wenn Sie diese Modelle in Ihre bestehenden Systeme wie CRM, ERP oder bestimmte Anwendungen integrieren müssen, denken Sie daran, dass viele robuste APIs und eine detaillierte Dokumentation bieten, um die Integration zu erleichtern.

Die Wahl des richtigen Modells kann den Unterschied zwischen einer erfolgreichen Implementierung und einer schlecht vergeudeten Investition ausmachen. Nehmen Sie sich die Zeit, jede Option mit Ihren tatsächlichen Daten zu bewerten, bevor Sie sich für eine groß angelegte Bereitstellung entscheiden.

ANHANG, neues ChatGPT-5-Modell

Bildquelle: OpenAI

Im April 2025 führte OpenAI ChatGPT-5 ein, die bedeutendste Entwicklung seit GPT-4, und festigte damit seine Position als Benchmark für multimodale Sprachmodelle. Dieses neue System verbessert nicht nur die Geschwindigkeit und die Kosten pro Token, sondern führt auch ein viel tieferes kontextbezogenes Verständnis und ein aktives Gedächtnis ein, das die Art und Weise verändert, wie Sie mit KI interagieren.

Geschwindigkeit und Leistung

ChatGPT-5 bietet die 2,3-fache Leistung von GPT-4o und erreicht eine durchschnittliche Geschwindigkeit von 250 Token pro Sekunde mit Antwortlatenzen von unter 180 Millisekunden im Sprachmodus. Dieser Sprung ist auf eine optimierte Inferenzarchitektur und die einheitliche Verarbeitung von Text, Audio, Bild und Video innerhalb eines einzigen neuronalen Netzwerks zurückzuführen.

Das Ergebnis ist ein reibungsloseres Erlebnis, insbesondere bei Echtzeitanwendungen oder Umgebungen mit kontinuierlicher Konversationsunterstützung.

Kontext und Speicherkapazität

Einer der größten Fortschritte von ChatGPT-5 ist sein erweitertes Kontextfenster auf 512.000 Token (1 Million in der Unternehmensversion), mit dem umfangreiche Dokumente, Code-Repositories oder ganze Unternehmensberichte analysiert werden können, ohne die Informationen zu fragmentieren.

Darüber hinaus enthält es einen persistenten Speicher, der den Interaktionsverlauf, die Stilpräferenzen und den Benutzerkontext zwischen den Sitzungen beibehält. Dies ermöglicht eine schrittweise Anpassung und kohärentere Reaktionen im Laufe der Zeit.

Kosten und Effizienz

OpenAI hat es geschafft, die Kosten im Vergleich zu GPT-4o um rund 60 % zu senken . Der durchschnittliche Preis pro 1.000 Token liegt bei etwa 0,012 €, was ChatGPT-5 zur bisher günstigsten und effizientesten Version der Serie macht.

Diese Verbesserung ermöglicht es Ihnen, Geschäftsprojekte und komplexe Automatisierungsabläufe zu skalieren, ohne Kompromisse bei Genauigkeit oder Geschwindigkeit einzugehen.

Integration und Automatisierung

ChatGPT-5 erweitert die Interoperabilität früherer Modelle durch native Unterstützung für das Model Context Protocol (MCP). Dank dieser Standardschicht können Sie sich direkt mit Tools wie n8n, Zapier, Make, CRMs oder ERPs verbinden, automatisierte Aufgaben ausführen und den Kontext zwischen den Systemen beibehalten.

Die erweiterte API-Unterstützung ermöglicht auch die Generierung und Validierung von Daten in Echtzeit, ideal für Abläufe mit autonomen Agenten oder Verifizierungsprozesse.

Verbessertes Gesprächserlebnis

Im Sprachbereich erreicht ChatGPT-5 ein bemerkenswertes Maß an Natürlichkeit. Es erkennt Intonationen, Pausen und Emotionen genauer und bietet Dialoge, die praktisch nicht von menschlichen Dialogen zu unterscheiden sind.

Das System passt seinen Ton je nach Kontext an – informativ, technisch oder kommerziell – und zeigt ein besseres Verständnis für andere Sprachen als Englisch, wodurch eine der Schwächen von GPT-4 korrigiert wird.

Vergleichende Zusammenfassung

| Merkmal | GPT-4 | GPT-4o | ChatGPT-5 (Englisch) |

|---|---|---|---|

| Durchschnittliche | 60 Token/s | 110 Token/s | 250 Token/s |

| Kontext-Fenster | 8K – 128K | 128 Tsd. | 512 K – 1 M |

| Modalitäten | Text | Text, Audio, Bild | Text, Audio, Bild, Video |

| Persistenter | Nein | Teilweise | Ja, zwischen den Sitzungen |

| Ungefähre | €0,03/1K | €0,015/1K | €0,012/1K |

| Integration | API | API | API + MCP (n8n, Zapier usw.) |

Fazit

ChatGPT-5 steht für die Reife des “Omni”-Ansatzes von OpenAI.

Seine Kombination aus erhöhter Geschwindigkeit, reduzierten Kosten, erweitertem Kontext und echtem Speicher positioniert es als das ausgewogenste Modell für 2025.

Darüber hinaus eröffnet die Integration mit Automatisierungstools wie n8n neue Möglichkeiten für den Aufbau von KI-Agenten, die ohne manuelle Eingriffe echte Daten verbinden, denken und darauf reagieren.

FAQs

Frage 1. Was ist das schnellste LLM-Modell, das im Jahr 2025 verfügbar ist? GPT-4o zeichnet sich durch seine Geschwindigkeit aus, verarbeitet 110 Token pro Sekunde und bietet Audioantworten in nur 232 Millisekunden, was es ideal für Echtzeitgespräche und Anwendungen macht, die schnelle Antworten erfordern.

Frage 2. Welches Modell bietet das beste Preis-Leistungs-Verhältnis? DeepSeek R1 ist die wirtschaftlichste Option, mit Preisen, die bis zu 90-95 % niedriger sind als die von Konkurrenten wie OpenAI, bei gleichzeitiger Beibehaltung einer hohen Leistung bei Denk- und Softwareentwicklungsaufgaben.

Frage 3. Welches Modell eignet sich am besten für die Verarbeitung großer Informationsmengen? Gemini 2.5 Pro zeichnet sich durch sein beeindruckendes Kontextfenster von 1.048.576 Token aus, mit dem bis zu 1.500 Textseiten gleichzeitig verarbeitet werden können, was es ideal für die Analyse großer Dokumente und komplexer Codebasen macht.

Frage 4. Welches Modell ist für Programmieraufgaben am weitesten fortgeschritten? Claude 4 Opus gilt als “das beste Programmiermodell der Welt” und führt Benchmarks wie SWE-bench mit einer Leistung von 72,5 % an und zeichnet sich durch komplexe Codierungsaufgaben und das Refactoring ganzer Projekte aus.

Frage 5. Wie haben sich die Kosten für LLM-Modelle im Jahr 2025 entwickelt? Die Kosten sind deutlich gesunken. Zum Beispiel hat OpenAI o3 seine Preise um 80 % gesenkt und bietet wettbewerbsfähige Preise von 1,91 € pro Million Input-Token und 7,63 € pro Million Output-Token, wodurch fortschrittliche Modelle zugänglicher werden.