Los modelos LLM de 2025 ofrecen opciones diversas para equilibrar velocidad, coste y capacidades según necesidades específicas. En este artículo compararemos los principales modelos, sus punts fuertes y débiles y como les puedes sacra el máximo partido:

• GPT-4o lidera en velocidad multimodal con 110 tokens/segundo y capacidades de audio en tiempo real, ideal para conversaciones interactivas y procesamiento multimedia.

• DeepSeek R1 es la opción más económica con costes 90-95% menores que competidores, perfecto para tareas de razonamiento matemático y desarrollo de software.

• Gemini 2.5 Pro destaca por su ventana de contexto masiva de 1M+ tokens, permitiendo procesar hasta 1.500 páginas simultáneamente para análisis documental extenso.

• Claude 4 Opus establece el estándar en codificación profesional con 72.5% en SWE-bench y capacidad de trabajo continuo durante 7 horas sin degradación.

• La elección del modelo debe basarse en casos de uso específicos: velocidad para tiempo real (GPT-4o), economía para volumen alto (DeepSeek R1), o máximo rendimiento para desarrollo complejo (Claude 4 Opus).

La competencia entre estos modelos impulsa mejoras constantes en 2025, ofreciendo versiones gratuitas para experimentar antes de implementaciones empresariales a gran escala.

GPT-4o

Image Source: Cody AI

¿Qué hace especial a GPT-4o entre todos los modelos disponibles? Este modelo de OpenAI, donde la “o” significa “omni”, representa un salto cualitativo importante en inteligencia artificial. A diferencia de versiones anteriores que procesaban solo texto, GPT-4o puede trabajar con texto, audio, imágenes y vídeo de forma simultánea y en tiempo real. Esta capacidad multimodal lo convierte en una herramienta verdaderamente versátil para casi cualquier aplicación que puedas imaginar.

¿Qué velocidad ofrece GPT-4o?

La rapidez de GPT-4o es realmente impresionante. Cuando le hables mediante audio, recibirás respuestas en tan solo 232 milisegundos, con un promedio de 320 milisegundos – prácticamente igual que el tiempo de respuesta humano en una conversación natural.

Para que comprendas la mejora que esto representa, observa estos datos comparativos:

- GPT-3.5 tardaba 2,8 segundos en responder

- GPT-4 necesitaba 5,4 segundos para generar respuestas

En términos de procesamiento de texto, GPT-4o alcanza 110 tokens por segundo, una velocidad aproximadamente tres veces superior a GPT-4 Turbo. Esta rapidez también supera a otros modelos competidores como Claude 3 Opus y Gemini 1.5 Pro.

¿Cómo logra esta velocidad? La clave está en su arquitectura integrada. Mientras los modelos anteriores requerían hasta tres sistemas separados para procesar audio (transcripción, generación y síntesis), GPT-4o unifica todo en una sola red neuronal.

¿Cuánto cuesta utilizar GPT-4o?

OpenAI ha conseguido hacer GPT-4o mucho más económico, con una reducción de costes del 50% respecto a GPT-4 Turbo. Aquí tienes la estructura de precios actual:

| Tipo de token | Precio |

| Tokens de entrada | 0,01$ por 1.000 tokens |

| Tokens de salida | 0,03$ por 1.000 tokens |

Para darte una idea práctica: procesar un texto de 500 palabras te costaría aproximadamente 7,64€ (incluyendo 625 tokens de entrada y 725 tokens de salida).

Si buscas una opción aún más económica, puedes utilizar GPT-4o mini. Esta versión cuesta 0,15$ por millón de tokens de entrada y 0,60$ por millón de tokens de salida, resultando aproximadamente 7,2 veces más barata que GPT-4.

¿Cuánta información puede procesar GPT-4o?

GPT-4o maneja una ventana de contexto de 128.000 tokens, una mejora considerable frente a los 8.192 tokens del GPT-4 original. ¿Qué significa esto para ti en la práctica?

Con esta capacidad expandida, GPT-4o puede:

- Analizar documentos extensos completos

- Mantener conversaciones largas recordando todo el contexto previo

- Procesar y responder basándose en grandes volúmenes de información

- Generar hasta 16.384 tokens en una sola respuesta

Recuerda que aunque esta ventana de contexto es amplia, modelos como Claude 3.5 Sonnet ofrecen 200.000 tokens y Gemini 1.5 Pro alcanza los 2 millones.

¿Cuándo te recomendamos utilizar GPT-4o?

GPT-4o sobresale especialmente cuando necesitas procesamiento multimodal y respuestas rápidas. Te recomendamos considerarlo para:

Conversaciones en tiempo real: Su baja latencia lo convierte en la opción ideal para chatbots y asistentes virtuales que requieren interacciones fluidas y naturales.

Procesamiento de idiomas diversos: Muestra mejoras significativas al trabajar con idiomas distintos al inglés. Por ejemplo, utiliza 4,4 veces menos tokens para gujarati, 3,5 veces menos para telugu y 3,3 veces menos para tamil.

Análisis de imágenes: Su capacidad mejorada para comprender contenido visual lo hace perfecto para describir documentos, diagramas o capturas de pantalla.

Trabajo con audio: Puede procesar entrada de audio directamente, captando no solo el contenido verbal sino también el tono, identificando múltiples hablantes y filtrando ruido de fondo.

Creación de contenido multimedia: Genera texto e imágenes de manera integrada y contextual.

Sin embargo, ten en cuenta que aunque GPT-4o es más rápido que GPT-4 Turbo, no muestra un aumento significativo en capacidades generales de razonamiento. Si necesitas razonamiento complejo, otros modelos pueden ser más adecuados para tu proyecto.

Claude Sonnet 4

Image Source: CometAPI

¿Buscas un modelo LLM que combine rendimiento excepcional con costes razonables? Claude Sonnet 4, lanzado por Anthropic en mayo de 2025, representa exactamente esa solución equilibrada que necesitas. Este modelo se ha diseñado específicamente para ofrecer capacidades avanzadas de codificación y razonamiento sin comprometer tu presupuesto, posicionándose como la alternativa más práctica dentro de la familia Claude 4.

A diferencia de su hermano mayor Claude Opus 4, Sonnet 4 prioriza la eficiencia sin sacrificar calidad, convirtiéndolo en la elección ideal para desarrolladores y empresas que buscan máximo valor por su inversión.

Velocidad de Claude Sonnet 4

¿Te preguntas qué tan rápido puede procesar tus consultas? Claude Sonnet 4 está optimizado para aplicaciones de alto volumen, con límites oficiales que superan significativamente a versiones anteriores:

- 50 solicitudes por minuto (RPM)

- 30.000 tokens de entrada por minuto (ITPM)

- 8.000 tokens de salida por minuto (OTPM)

Como confirma el anuncio oficial de Anthropic: “Hemos aumentado los límites de velocidad de la API para Claude Sonnet 4”. Esta mejora te permite procesar más datos sin alcanzar límites frecuentemente, escalar tus aplicaciones para servir más usuarios simultáneamente y ejecutar múltiples llamadas API en paralelo.

Recuerda que Sonnet 4 implementa un sistema innovador de “ITPM consciente de caché”. Solo los tokens de entrada no almacenados en caché cuentan hacia los límites de velocidad. Por ejemplo, con un límite de ITPM de 2.000.000 y una tasa de acierto de caché del 80%, podrías procesar efectivamente 10.000.000 tokens de entrada totales por minuto.

Coste de Claude Sonnet 4

La estructura de precios de Claude Sonnet 4 está diseñada para ser accesible y predecible:

| Tipo de token | Precio estándar | Precio con caché (5 min) | Precio con caché (1 hora) | Caché hits |

| Tokens de entrada | EUR 2,86/MTok | EUR 3,58/MTok | EUR 5,73/MTok | EUR 0,29/MTok |

| Tokens de salida | EUR 14,31/MTok | – | – | – |

Te recomendamos utilizar el almacenamiento en caché de prompts para optimizar costes, especialmente si tu aplicación realiza consultas repetitivas. Para contextos largos (más de 200K tokens) cuando usas la ventana de contexto de 1M, se aplica una tarifa premium: EUR 5,73 por millón de tokens de entrada y EUR 21,47 por millón de tokens de salida.

Si manejas alto volumen de procesamiento, el API de lotes te ofrece un descuento del 50%, reduciendo el coste a EUR 1,43/MTok para entrada y EUR 7,16/MTok para salida.

Ventana de contexto de Claude Sonnet 4

¿Necesitas procesar documentos extensos o mantener conversaciones largas? Claude Sonnet 4 ofrece una ventana de contexto estándar de 200K tokens (aproximadamente 150.000 palabras o unas 500 páginas de texto), permitiéndote analizar bases de código complejas en una sola interacción.

Para organizaciones en el nivel de uso 4 y aquellas con límites personalizados, Claude Sonnet 4 proporciona una ventana expandida de hasta 1 millón de tokens en modo beta. Esta capacidad está disponible a través de la API de Anthropic, Amazon Bedrock y Google Vertex AI, permitiendo:

- Análisis de código a escala masiva (hasta 75.000 líneas de código)

- Procesamiento de documentos extremadamente extensos

- Creación de agentes de IA con capacidades de razonamiento prolongado

Para acceder a esta característica, incluye el encabezado beta “context-1m-2025-08-07” en tus solicitudes de API.

Mejor uso de Claude Sonnet 4

Claude Sonnet 4 destaca especialmente en estos escenarios:

Codificación y desarrollo: Con puntuaciones excepcionales en benchmarks como SWE-bench (72,7%, superando ligeramente a Opus 4 con 72,5%), resulta perfecto para tareas de programación, desde generación de código hasta refactorización completa.

Agentes de atención al cliente: Su eficiencia y velocidad lo convierten en la opción ideal para chatbots de alto volumen y asistentes virtuales que requieren respuestas rápidas pero sofisticadas.

Procesamiento documental: Perfecto para resumir, analizar o extraer información de documentos extensos gracias a su amplia ventana de contexto.

Aplicaciones empresariales económicas: Al equilibrar rendimiento y coste, es la elección preferida para implementaciones que requieren procesamiento intensivo manteniendo restricciones presupuestarias.

Una ventaja adicional es su disponibilidad gratuita a través de la interfaz web de Claude, a diferencia de Opus 4 que requiere suscripción de pago. Esto lo convierte en un recurso valioso si deseas experimentar con modelos LLM de alto rendimiento sin coste inicial.

Grok 3

Image Source: CometAPI

¿Buscas un modelo LLM con capacidades de razonamiento avanzadas? Grok 3, lanzado por xAI en febrero de 2025, podría ser la solución que necesitas. Desarrollado bajo la dirección de Elon Musk, este modelo fue entrenado utilizando un impresionante centro de datos con 200.000 unidades de procesamiento gráfico (GPU). Esta inversión computacional, diez veces superior a su predecesor, se tradujo en 200 millones de horas de cómputo acumuladas.

¿Qué velocidad ofrece Grok 3?

Te presentamos los resultados más destacados de Grok 3 en términos de velocidad de procesamiento:

- Resolvió un rompecabezas complejo de razonamiento lógico en apenas 67 segundos, mientras que competidores como DeepSeek R1 tardaron 343 segundos

- Su modo “Think” procesó consultas complejas, generando código de animación 3D en 114 segundos

Además, xAI te ofrece una variante optimizada llamada Grok 3 Mini, que prioriza la rapidez sobre cierto grado de precisión. Esta flexibilidad te permite elegir entre potencia máxima o respuestas más ágiles según tus necesidades específicas.

Estructura de costes de Grok 3

A continuación, encontrarás la estructura de precios que te permitirá evaluar qué versión se adapta mejor a tu presupuesto:

| Modelo | Coste tokens de entrada | Coste tokens de salida |

| Grok 3 | EUR 2,86 por millón | EUR 14,31 por millón |

| Grok 3 Mini | EUR 0,29 por millón | EUR 0,48 por millón |

Como puedes observar, Grok 3 Mini resulta aproximadamente 10 veces más económico para tokens de entrada y 30 veces más barato para tokens de salida. Te recomendamos esta variante si buscas una alternativa rentable para aplicaciones de alto volumen.

El acceso principal se obtiene mediante la suscripción a X Premium+, con un coste de EUR 38,17 mensuales en EE.UU. tras un reciente aumento desde EUR 20,99. También puedes considerar el plan “SuperGrok” anunciado por EUR 28,63 mensuales que ofrecerá funcionalidades más avanzadas.

Capacidad de contexto disponible

Tanto Grok 3 como Grok 3 Mini te proporcionan una ventana de contexto de 131.072 tokens. Esta capacidad te permite procesar documentos extensos y mantener conversaciones prolongadas sin perder información contextual relevante.

Recuerda que aunque teóricamente puede manejar hasta un millón de tokens, estudios de usuarios sugieren que el rendimiento óptimo se mantiene hasta aproximadamente 80.000 tokens. Más allá de este umbral, podrías experimentar una degradación gradual de coherencia.

¿Cuándo utilizar Grok 3?

Te recomendamos Grok 3 particularmente para estos escenarios:

Razonamiento matemático y científico: Obtiene resultados sobresalientes en pruebas como AIME (matemáticas) y GPQA (física, química y biología), superando a competidores de primer nivel.

Desarrollo de código: Genera código más estructurado y funcional que otros modelos, especialmente en aplicaciones web e interfaces de usuario. Su capacidad para producir soluciones HTML5 optimizadas lo hace ideal si eres programador.

Investigación con DeepSearch: Su motor de búsqueda integrado escanea internet y la red social X proporcionando respuestas documentadas más rápidamente que alternativas como Gemini y OpenAI.

Escritura creativa: Demuestra habilidades narrativas superiores con mejor construcción de personajes y progresión de tramas.

Generación de contenido con menos restricciones: Ofrece un enfoque menos censurado, abordando temas sensibles de manera más directa cuando lo solicitas explícitamente.

Si necesitas un modelo LLM con sólidas capacidades de razonamiento y buscas un equilibrio efectivo entre velocidad, coste y amplitud de contexto, Grok 3 representa una opción potente que deberías considerar en 2025.

DeepSeek R1

Image Source: DeepSeek

¿Buscas un modelo LLM que combine potencia de razonamiento con precios accesibles? DeepSeek R1, desarrollado en China y lanzado en enero de 2025, puede ser exactamente lo que necesitas. Este modelo de razonamiento se basa en DeepSeek V3 pero incorpora mejoras significativas mediante aprendizaje por refuerzo (RL), convirtiéndose en una herramienta excepcionalmente potente para resolver problemas matemáticos y lógicos, así como para análisis científicos.

Velocidad de DeepSeek R1

Cuando evalúes DeepSeek R1, notarás que su enfoque prioriza la precisión sobre la rapidez:

- Procesa aproximadamente 28 tokens por segundo

- Es aproximadamente 6 veces más lento que o1-mini y el doble de lento que ChatGPT 4o

- Dedica tiempo adicional al razonamiento profundo antes de generar respuestas

Esta velocidad más pausada tiene una razón de ser: DeepSeek R1 se autocorrige durante su cadena de pensamiento, detectando sus propios errores antes de ofrecer la respuesta final. Si necesitas respuestas extremadamente precisas para tareas complejas, este enfoque deliberativo te resultará beneficioso, especialmente cuando la exactitud es más importante que la velocidad inmediata.

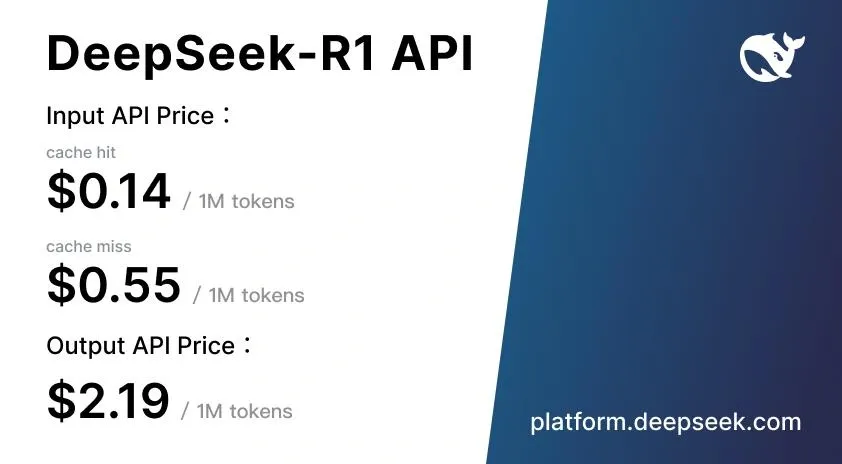

Coste de DeepSeek R1

Aquí encontrarás una de las ventajas más destacadas de DeepSeek R1: su estructura de precios altamente competitiva.

| Tipo de token | Precio estándar |

| Tokens de entrada (cache hit) | <citation index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0.13 |

| Tokens de entrada (cache miss) | <citation index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0.13 |

| Tokens de salida | <citation index=”26″ link=”https://deepseek-r1.com/es/pricing/” similar_text=”EUR 0.13 |

Estos precios son 90-95% inferiores a los de OpenAI o1, cuyo coste asciende a EUR 14,31 por millón de tokens de entrada y EUR 57,25 por millón de tokens de salida. Además, DeepSeek implementa un sistema inteligente de almacenamiento en caché que te proporciona hasta un 90% de ahorro para consultas repetidas.

Te recomendamos probar DeepSeek R1 de forma gratuita a través de la plataforma web DeepSeek Chat, donde puedes experimentar con sus capacidades sin ningún coste inicial.

Ventana de contexto de DeepSeek R1

DeepSeek R1 maneja una ventana de contexto de 128K tokens, lo que te permite:

- Procesar tareas de razonamiento complejas de varios pasos

- Mantener coherencia en documentos extensos

- Seguir cadenas complejas de razonamiento sin perder información

- Manejar discusiones técnicas detalladas manteniendo el contexto completo

Esta capacidad sitúa a DeepSeek R1 al mismo nivel que GPT-4o (128K), aunque por debajo de Claude 3.5 Sonnet (200K) y Gemini 1.5 Pro (2 millones).

Mejor uso de DeepSeek R1

DeepSeek R1 sobresale particularmente cuando necesitas:

- Resolución de problemas matemáticos y técnicos: Ideal para investigación científica, ingeniería y finanzas

- Desarrollo de software y codificación: Compite eficazmente con Claude y OpenAI o1-mini en programación automatizada

- Tareas de generación aumentada por recuperación (RAG): Rinde tan bien como GPT-4o con razonamiento explícito paso a paso

- Personalización mediante código abierto: Su licencia MIT permite modificaciones para necesidades específicas

- Aplicaciones para el mercado chino: Optimizado especialmente para comprensión del idioma chino

Recuerda que DeepSeek R1 presenta algunas limitaciones importantes. Su rendimiento multilingüe es pobre fuera del inglés y chino y no es compatible con análisis de imágenes, lo que restringe su utilidad en aplicaciones multimodales.

Según el modelo DeepSeek-R1-Zero, el razonamiento puede surgir desde cero usando solo RL, permitiendo desarrollar capacidades avanzadas sin depender de datos etiquetados. Esto hace que DeepSeek R1 sea particularmente valioso para equipos de investigación que buscan explorar nuevas técnicas de entrenamiento de modelos.

Gemini 2.5 Pro

Image Source: CometAPI

Presentado en marzo de 2025, Gemini 2.5 Pro es el modelo de razonamiento más avanzado que Google ha desarrollado hasta ahora. Si buscas una herramienta que pueda resolver problemas complejos, este modelo te ofrece capacidades mejoradas de razonamiento y una ventana de contexto que cambiarán la forma en que procesas grandes volúmenes de información.

Velocidad de Gemini 2.5 Pro

¿Te preguntas qué hace especial la velocidad de Gemini 2.5 Pro? A diferencia de otros modelos LLM, este sistema funciona de manera particular: dedica aproximadamente 20 segundos al razonamiento inicial y después genera tokens a una velocidad extraordinariamente alta. Piensa en ello como un proceso de “reflexionar antes de responder” que te proporciona un equilibrio perfecto entre análisis profundo y rapidez en la generación de contenido.

El modelo supera significativamente la velocidad de versiones anteriores sin comprometer la calidad del resultado. Además, Google ha diseñado su infraestructura para evitar los típicos límites de velocidad que experimentas con otros sistemas competidores, lo que te garantiza una experiencia más fluida incluso cuando trabajas con tareas complejas.

Coste de Gemini 2.5 Pro

La estructura de precios de Gemini 2.5 Pro varía según el volumen de tokens que utilices y el tipo de procesamiento que necesites:

| Tipo de procesamiento | Tokens de entrada | Tokens de salida |

| Estándar (≤200K tokens) | $1.25 por millón | $10.00 por millón |

| Estándar (>200K tokens) | $2.50 por millón | $15.00 por millón |

| Procesamiento por lotes | $0.625 por millón | $5.00 por millón |

Google te ofrece además un sistema de almacenamiento en caché que puede reducir significativamente tus costes para consultas repetitivas, con precios desde $0.125 por millón de tokens.

Para acceder a Gemini 2.5 Pro puedes elegir entre la suscripción Google AI Pro (21,99€/mes) o Google AI Ultra (274,99€/mes) si necesitas límites de uso mayores.

Ventana de contexto de Gemini 2.5 Pro

Una de las características que más te impresionará de Gemini 2.5 Pro es su extraordinaria ventana de contexto de 1.048.576 tokens, con planes para ampliarla a 2 millones en futuras actualizaciones. ¿Qué significa esto para ti en términos prácticos?

- Puedes procesar hasta 1.500 páginas de texto simultáneamente

- Analizar 30.000 líneas de código en una sola operación

- Mantener conversaciones extensas sin perder información contextual

Esta amplia capacidad contextual te facilita el análisis de documentos completos, bases de código extensas y conjuntos de datos complejos en una sola sesión.

Mejor uso de Gemini 2.5 Pro

Te recomendamos Gemini 2.5 Pro especialmente para:

- Desarrollo web avanzado: Lidera el ranking WebDev Arena en la creación de aplicaciones web funcionales y estéticamente atractivas

- Razonamiento complejo: Ideal cuando necesitas resolver matemáticas, ciencias y problemas multifacéticos que requieren análisis paso a paso

- Transformación y edición de código: Particularmente eficaz para automatizar tareas de programación complejas

- Procesamiento multimodal: Capacidad para comprender entradas de texto, código, imágenes, audio y video

Si eres desarrollador, investigador o profesional que necesita procesar grandes volúmenes de información multimodal con razonamiento profundo y preciso, este modelo te resultará especialmente valioso.

Claude 4 Opus

Image Source: CometAPI

¿Buscas el modelo LLM más potente para programación avanzada? Claude Opus 4, lanzado en mayo de 2025, representa la propuesta premium de Anthropic y se posiciona como “el mejor modelo de programación del mundo” según su fabricante. Esta versión marca un nuevo estándar en inteligencia artificial conversacional, especialmente diseñada para tareas de razonamiento profundo y codificación compleja.

Velocidad de Claude 4 Opus

Claude Opus 4 te ofrece una capacidad de procesamiento notable, con límites oficiales establecidos en:

- 50 solicitudes por minuto (RPM)

- 30.000 tokens de entrada por minuto (ITPM)

- 8.000 tokens de salida por minuto (OTPM)

¿Qué hace realmente especial a este modelo? Su capacidad única para mantener sesiones de trabajo prolongadas. Mientras otros competidores pierden coherencia tras una o dos horas, Claude Opus 4 puede trabajar continuamente durante hasta siete horas sin degradación de rendimiento. Esta característica resulta fundamental si trabajas en proyectos complejos de programación que requieren concentración sostenida.

Coste de Claude 4 Opus

Te recomendamos considerar cuidadosamente el presupuesto, ya que Claude Opus 4 representa una inversión premium:

| Tipo de token | Precio estándar | Con procesamiento por lotes |

| Entrada | EUR 14.31/MTok | EUR 7.16/MTok |

| Salida | EUR 71.57/MTok | EUR 35.78/MTok |

Estos precios sitúan a Opus 4 en la gama alta del mercado. Sin embargo, puedes optimizar costes utilizando los mecanismos que Anthropic ofrece: el almacenamiento en caché de prompts (reduciendo hasta un 90% los costos) y el procesamiento por lotes (con descuento del 50%).

Ventana de contexto de Claude 4 Opus

Claude Opus 4 dispone de una ventana de contexto de 200.000 tokens, comparable a su predecesor pero inferior a los 1.048.576 tokens de Gemini 2.5 Pro. Recuerda que esta limitación puede resultar restrictiva para bases de código extremadamente grandes, aunque es suficiente para la mayoría de aplicaciones prácticas.

El modelo incorpora una característica única: el “pensamiento extendido”, un modo que permite alternar entre razonamiento interno y uso de herramientas externas. Esta funcionalidad mejora significativamente su capacidad para resolver problemas sofisticados.

Mejor uso de Claude 4 Opus

¿Cuándo deberías elegir Claude Opus 4? Sobresale particularmente en estos casos:

- Tareas de codificación complejas: Lidera el benchmark SWE-bench con un 72.5% y Terminal-bench con 43.2%, superando a competidores como GPT-4.1 (54.6%) y Gemini 2.5 Pro (63.2%).

- Razonamiento científico avanzado: Alcanza 79.6% en GPQA Diamond (83.3% en modo de alta computación).

- Agentes de IA autónomos: Su prolongada ventana de atención lo hace ideal para tareas que requieren miles de pasos y horas de procesamiento continuo.

- Refactorización de proyectos: Puede analizar y modificar bases de código completas en una sola sesión.

Si eres desarrollador profesional, investigador o formas parte de equipos que crean agentes de IA avanzados y necesitas el máximo nivel de rendimiento, Claude Opus 4 representa tu elección óptima.

OpenAI o3

Image Source: Apidog

OpenAI presenta en abril de 2025 su modelo o3, que marca un punto de inflexión en el razonamiento artificial. A diferencia de los modelos que hemos analizado anteriormente, o3 está específicamente diseñado para “pensar durante más tiempo antes de responder”, integrando capacidades de razonamiento avanzado con acceso autónomo a herramientas.

¿Qué velocidad ofrece OpenAI o3?

Aunque o3 prioriza la reflexión profunda, mantiene una eficiencia que te sorprenderá:

- Supera el rendimiento de o1 manteniendo la misma latencia

- Su arquitectura permite razonamiento prolongado sin comprometer la velocidad de respuesta

- La versión o3-mini muestra tiempos 24% más rápidos (7,7 segundos frente a 10,16 segundos de o1-mini)

Comparado con otros modelos de razonamiento, o3 logra completar tareas complejas generalmente en menos de un minuto, estableciendo un equilibrio efectivo entre análisis profundo y agilidad de respuesta.

Estructura de precios de OpenAI o3

Te alegrará saber que OpenAI ha reducido significativamente los precios de o3:

| Tipo | Precio original | Precio actual (80% reducción) |

| Tokens entrada | €9,54/millón | €1,91/millón |

| Tokens salida | €38,17/millón | €7,63/millón |

| Caché entrada | – | €0,48/millón |

Esta reducción posiciona a o3 competitivamente frente a Gemini 2.5 Pro (€0,95/millón entrada, €9,54/millón salida) y Claude Sonnet 4 (€2,86/millón entrada, €14,31/millón salida).

Capacidad de contexto de OpenAI o3

o3 ofrece capacidades contextuales extraordinarias que debes considerar:

- Maneja hasta 128.000 tokens en implementaciones estándar

- Alcanza 200.000 tokens en entornos específicos

- Genera hasta 100.000 tokens de salida

Esta amplitud contextual te permite analizar documentos extensos, códigos complejos y mantener conversaciones largas sin pérdida de coherencia.

¿Cuándo usar OpenAI o3?

Te recomendamos o3 especialmente para estos casos de uso:

Programación de alto nivel: Lidera SWE-bench con 71,7%, superando significativamente a o1 (48,9%), lo que lo convierte en tu mejor opción para desarrollo complejo.

Resolución matemática avanzada: Con 96,7% en AIME frente al 83,3% de o1, es ideal si necesitas precisión matemática excepcional.

Investigación científica: Alcanza 87,7% en GPQA Diamond, demostrando dominio en preguntas científicas de alta complejidad.

Análisis visual integrado: Incorpora imágenes en su razonamiento, permitiendo analizar diagramas y gráficos de manera contextual.

Automatización con herramientas: Combina autónomamente búsqueda web, análisis de archivos y ejecución de código Python.

Además, o3 se integra con Codex CLI, permitiendo aprovechar sus capacidades directamente desde la línea de comandos para desarrolladores que buscan optimizar su flujo de trabajo.

Tabla de Comparación

¿Necesitas una vista rápida para comparar todos estos modelos? A continuación, te presentamos una tabla resumen que te ayudará a identificar cuál se adapta mejor a tus necesidades específicas.

Recuerda que cada modelo tiene sus fortalezas particulares. Esta comparación te permitirá evaluar rápidamente las diferencias clave entre velocidad, coste y capacidades:

| Modelo | Velocidad de Procesamiento | Coste (por millón de tokens) | Ventana de Contexto | Casos de Uso Óptimos |

| GPT-4o | 110 tokens/segundo | Entrada: €0,01/1.000 tokens Salida: €0,03/1.000 tokens |

128.000 tokens | • Conversaciones en tiempo real • Procesamiento multilingüe • Análisis visual • Transcripción de audio |

| Claude Sonnet 4 | 50 solicitudes/min | Entrada: €2,86 Salida: €14,31 |

200.000 tokens (expandible a 1M) | • Codificación • Atención al cliente • Procesamiento documental • Aplicaciones empresariales |

| Grok 3 | 67 segundos (pruebas lógicas) | Entrada: €2,86 Salida: €14,31 |

131.072 tokens | • Razonamiento matemático • Desarrollo de código • Investigación • Escritura creativa |

| DeepSeek R1 | 28 tokens/segundo | Entrada: €0,52 Salida: €2,09 |

128.000 tokens | • Resolución problemas matemáticos • Desarrollo software • RAG • Mercado chino |

| Gemini 2.5 Pro | 20s inicial + alta velocidad | Entrada: $1,25 Salida: $10,00 |

1.048.576 tokens | • Desarrollo web • Razonamiento complejo • Transformación de código • Procesamiento multimodal |

| Claude 4 Opus | 50 solicitudes/min | Entrada: €14,31 Salida: €71,57 |

200.000 tokens | • Codificación compleja • Razonamiento científico • Agentes IA autónomos • Refactorización |

| OpenAI o3 | N/A | Entrada: €1,91 Salida: €7,63 |

128.000 tokens (expandible a 200K) | • Programación avanzada • Matemáticas • Ciencias • Razonamiento visual |

Si buscas la opción más económica, DeepSeek R1 ofrece precios imbatibles. Para máxima velocidad en aplicaciones multimodales, GPT-4o es tu mejor alternativa. ¿Necesitas procesar documentos extensos? Gemini 2.5 Pro con su ventana de contexto masiva será perfecto para ti.

Te recomendamos evaluar primero tus casos de uso específicos antes de decidirte por un modelo. La mayoría ofrecen versiones gratuitas para que puedas probarlos sin coste inicial.

Conclusión

¿Cuál es el modelo LLM que mejor se adapta a tus necesidades específicas? La respuesta depende completamente de tus casos de uso particulares y presupuesto disponible.

Recuerda que cada modelo tiene sus propias fortalezas. GPT-4o sobresale cuando necesitas respuestas multimodales rápidas, mientras que Claude Sonnet 4 te ofrece un equilibrio excepcional entre rendimiento y coste. Si trabajas con razonamiento matemático complejo, Grok 3 puede ser tu mejor opción.

¿Buscas la alternativa más económica? DeepSeek R1 representa una opción extraordinaria, especialmente si necesitas resolver problemas técnicos complejos sin comprometer tu presupuesto. Para procesar documentos extensos o bases de código masivas, Gemini 2.5 Pro te permite manejar más de un millón de tokens en una sola sesión.

Si vas a utilizar estos modelos para desarrollo profesional que requiere máximo rendimiento, Claude 4 Opus establece el estándar más alto en codificación avanzada. Por otro lado, OpenAI o3 destaca particularmente en programación y matemáticas con capacidades visuales integradas.

Lo interesante de los modelos es que todo ellos pueden ser utilizados en nuestros agentes de IA con n8n. A través de nuestras plantillas podrás utilizar toda la potencia de los distintos modelos en tus flujos de trabajo para conseguir cualquier objetivo que te propongas.

¿Cómo elegir tu modelo ideal?

Te recomendamos considerar estos aspectos clave:

Paso 1: Define tu caso de uso principal

- ¿Necesitas procesar grandes volúmenes de documentos? Gemini 2.5 Pro o Claude Sonnet 4 son tus mejores alternativas.

- ¿Priorizas conversaciones interactivas rápidas? GPT-4o te ofrecerá la mejor experiencia.

- ¿Trabajas con problemas matemáticos complejos? DeepSeek R1 o Grok 3 destacan en estas tareas.

Paso 2: Evalúa tu presupuesto

- Para aplicaciones de alto volumen con presupuesto limitado: DeepSeek R1

- Para equilibrio entre coste y rendimiento: Claude Sonnet 4

- Para máximo rendimiento sin restricciones de coste: Claude 4 Opus

Paso 3: Experimenta antes de decidir Afortunadamente, la mayoría de estos modelos ofrecen versiones gratuitas o créditos de prueba. Pruébalo gratis con cada modelo que consideres viable para tu caso de uso específico.

La competencia entre desarrolladores continúa impulsando mejoras constantes en velocidad, reducción de costes y ampliación de capacidades. Esto significa que probablemente verás actualizaciones significativas durante 2025 que beneficiarán directamente tu implementación.

Si necesitas integrar estos modelos en tus sistemas existentes como CRM, ERP o aplicaciones específicas, recuerda que muchos ofrecen APIs robustas y documentación detallada para facilitar la integración.

La elección del modelo correcto puede marcar la diferencia entre una implementación exitosa y una inversión mal aprovechada. Tómate el tiempo necesario para evaluar cada opción con tus datos reales antes de comprometerte con una implementación a gran escala.

ANEXO, nuevo modelo ChatGPT-5

Image Source: OpenAI

En abril de 2025, OpenAI presentó ChatGPT-5, la evolución más significativa desde GPT-4, consolidando su posición como referente en modelos de lenguaje multimodal. Este nuevo sistema no solo mejora la velocidad y el coste por token, sino que introduce una comprensión contextual mucho más profunda y una memoria activa que cambia la forma de interactuar con la IA.

Velocidad y rendimiento

ChatGPT-5 ofrece un rendimiento 2,3 veces superior al de GPT-4o, alcanzando una velocidad media de 250 tokens por segundo con latencias de respuesta por debajo de los 180 milisegundos en modo de voz. Este salto se debe a una arquitectura de inferencia optimizada y al procesamiento unificado de texto, audio, imagen y vídeo dentro de una misma red neuronal.

El resultado es una experiencia más fluida, especialmente en aplicaciones en tiempo real o entornos de asistencia conversacional continua.

Capacidad de contexto y memoria

Uno de los mayores avances de ChatGPT-5 es su ventana de contexto ampliada a 512 000 tokens (1 millón en versión empresarial), lo que permite analizar documentos extensos, repositorios de código o informes corporativos completos sin fragmentar la información.

Además, incorpora memoria persistente, que conserva el historial de interacción, preferencias de estilo y contexto de usuario entre sesiones. Esto permite una adaptación progresiva y respuestas más coherentes a lo largo del tiempo.

Coste y eficiencia

OpenAI ha logrado reducir los costes en torno a un 60 % respecto a GPT-4o. El precio medio por 1 000 tokens se sitúa en torno a €0,012, lo que convierte a ChatGPT-5 en la versión más económica y eficiente de la serie hasta la fecha.

Esta mejora permite escalar proyectos empresariales y flujos de automatización complejos sin comprometer precisión ni velocidad.

Integración y automatización

ChatGPT-5 amplía la interoperabilidad de los modelos anteriores mediante compatibilidad nativa con el Model Context Protocol (MCP). Gracias a esta capa estándar, puede conectarse directamente con herramientas como n8n, Zapier, Make, CRMs o ERPs, ejecutando tareas automatizadas y manteniendo el contexto entre sistemas.

Su soporte API extendido permite también la generación y validación de datos en tiempo real, ideal para flujos con agentes autónomos o procesos de verificación.

Experiencia conversacional mejorada

En el apartado de voz, ChatGPT-5 alcanza un nivel de naturalidad notable. Reconoce entonaciones, pausas y emociones con mayor precisión, ofreciendo un diálogo prácticamente indistinguible del humano.

El sistema ajusta su tono según el contexto —informativo, técnico o comercial— y muestra una mejor comprensión de idiomas distintos al inglés, corrigiendo uno de los puntos débiles de GPT-4.

Resumen comparativo

| Característica | GPT-4 | GPT-4o | ChatGPT-5 |

|---|---|---|---|

| Velocidad media | 60 tokens/s | 110 tokens/s | 250 tokens/s |

| Ventana de contexto | 8 K – 128 K | 128 K | 512 K – 1 M |

| Modalidades | Texto | Texto, audio, imagen | Texto, audio, imagen, vídeo |

| Memoria persistente | No | Parcial | Sí, entre sesiones |

| Coste aproximado | €0,03/1K | €0,015/1K | €0,012/1K |

| Integración | API | API | API + MCP (n8n, Zapier, etc.) |

Conclusión

ChatGPT-5 representa la madurez del enfoque “omni” de OpenAI.

Su combinación de mayor velocidad, costes reducidos, contexto ampliado y memoria real lo posiciona como el modelo más equilibrado para 2025.

Además, su integración con herramientas de automatización como n8n abre nuevas posibilidades para construir agentes de IA que conectan, piensan y actúan sobre datos reales sin intervención manual.

FAQs

Q1. ¿Cuál es el modelo LLM más rápido disponible en 2025? GPT-4o destaca por su velocidad, procesando 110 tokens por segundo y ofreciendo respuestas de audio en apenas 232 milisegundos, lo que lo hace ideal para conversaciones en tiempo real y aplicaciones que requieren respuestas rápidas.

Q2. ¿Qué modelo ofrece la mejor relación calidad-precio? DeepSeek R1 se posiciona como la opción más económica, con precios hasta 90-95% inferiores a los de competidores como OpenAI, manteniendo un alto rendimiento en tareas de razonamiento y desarrollo de software.

Q3. ¿Cuál es el modelo más adecuado para procesar grandes volúmenes de información? Gemini 2.5 Pro sobresale con su impresionante ventana de contexto de 1.048.576 tokens, permitiendo procesar hasta 1.500 páginas de texto simultáneamente, lo que lo hace ideal para análisis de documentos extensos y bases de código complejas.

Q4. ¿Qué modelo es el más avanzado para tareas de programación? Claude 4 Opus se considera “el mejor modelo de programación del mundo”, liderando benchmarks como SWE-bench con un 72.5% de rendimiento y destacando en tareas de codificación complejas y refactorización de proyectos enteros.

Q5. ¿Cómo han evolucionado los costos de los modelos LLM en 2025? Los costos han disminuido significativamente. Por ejemplo, OpenAI o3 ha reducido sus precios en un 80%, ofreciendo tarifas competitivas de €1,91 por millón de tokens de entrada y €7,63 por millón de tokens de salida, haciendo que los modelos avanzados sean más accesibles.